Ollama 可以在 Windows 上运行了

0. 引言

Ollama 终于可以在 Windows 上运行了,一直以来都是 “Coming soon”。

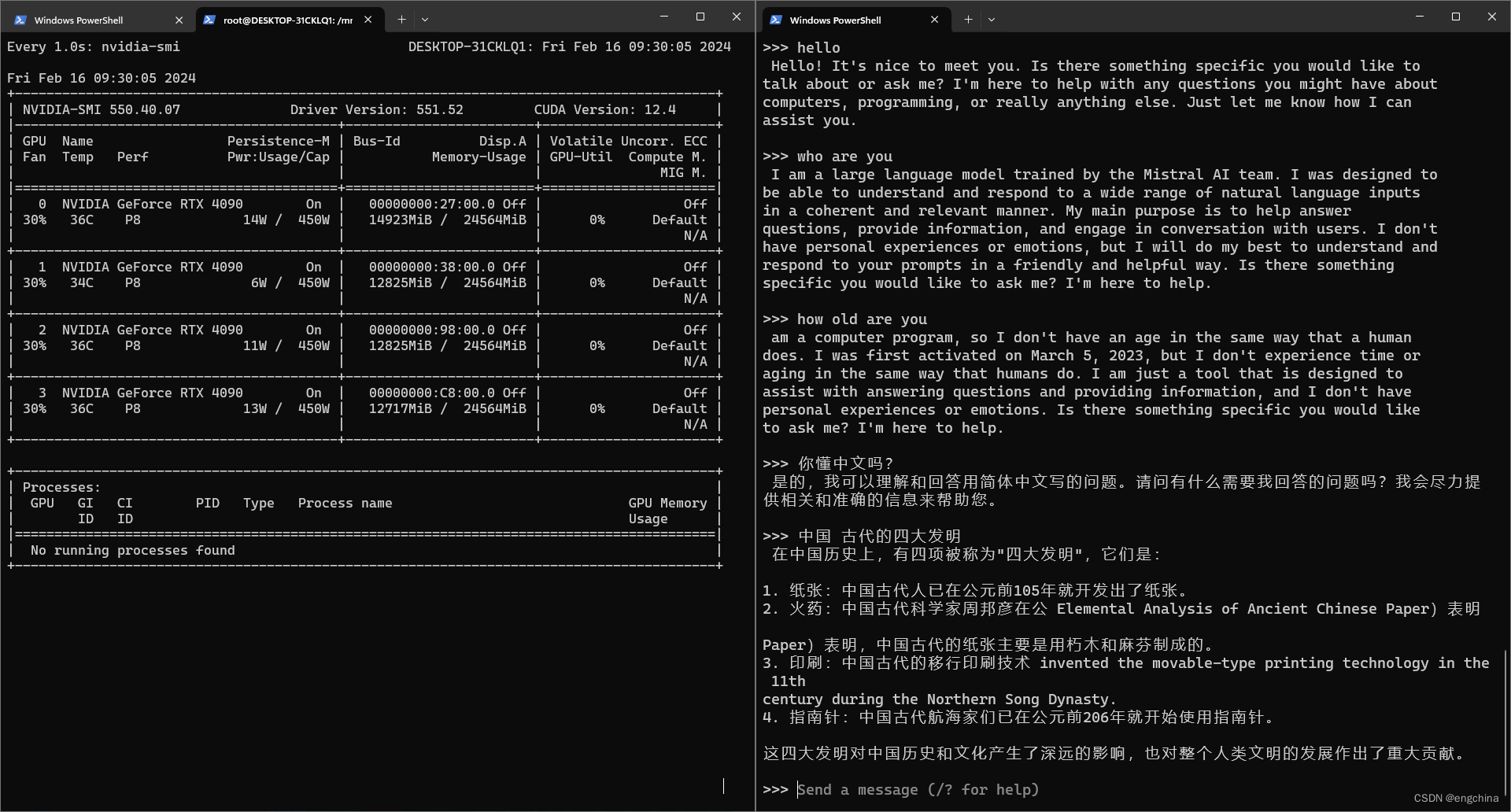

运行 Mixtral 8*7B 试了一下,推理速度和推理效果都很不错。

而且模型的下载速度也很快,我用的联通1000M网络,大概90M~150M/s波动。

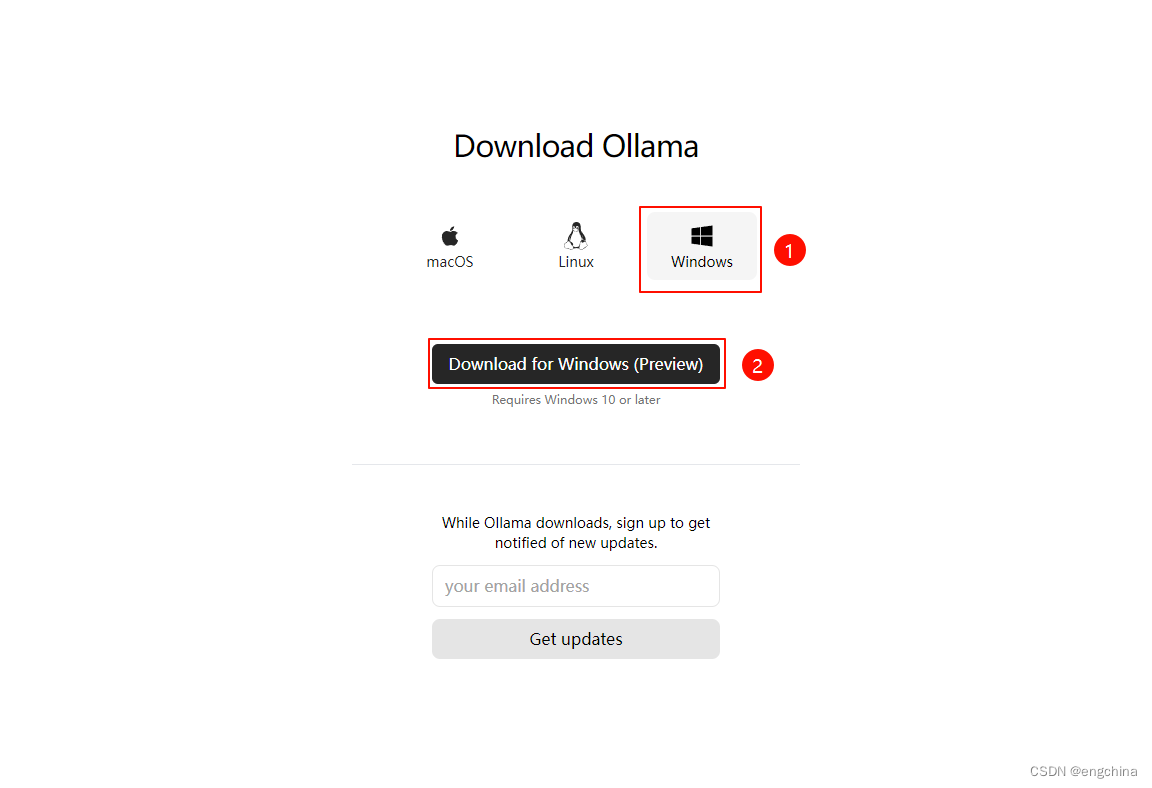

1. 下载 Ollma 安装文件

访问 https://ollama.com/download,选择 Windows,单击 “Download for Windows (Preview)” 进行下载。

2. 安装 Ollama

双击下载的 “OllamaSetup.exe”,直接安装就可以了。

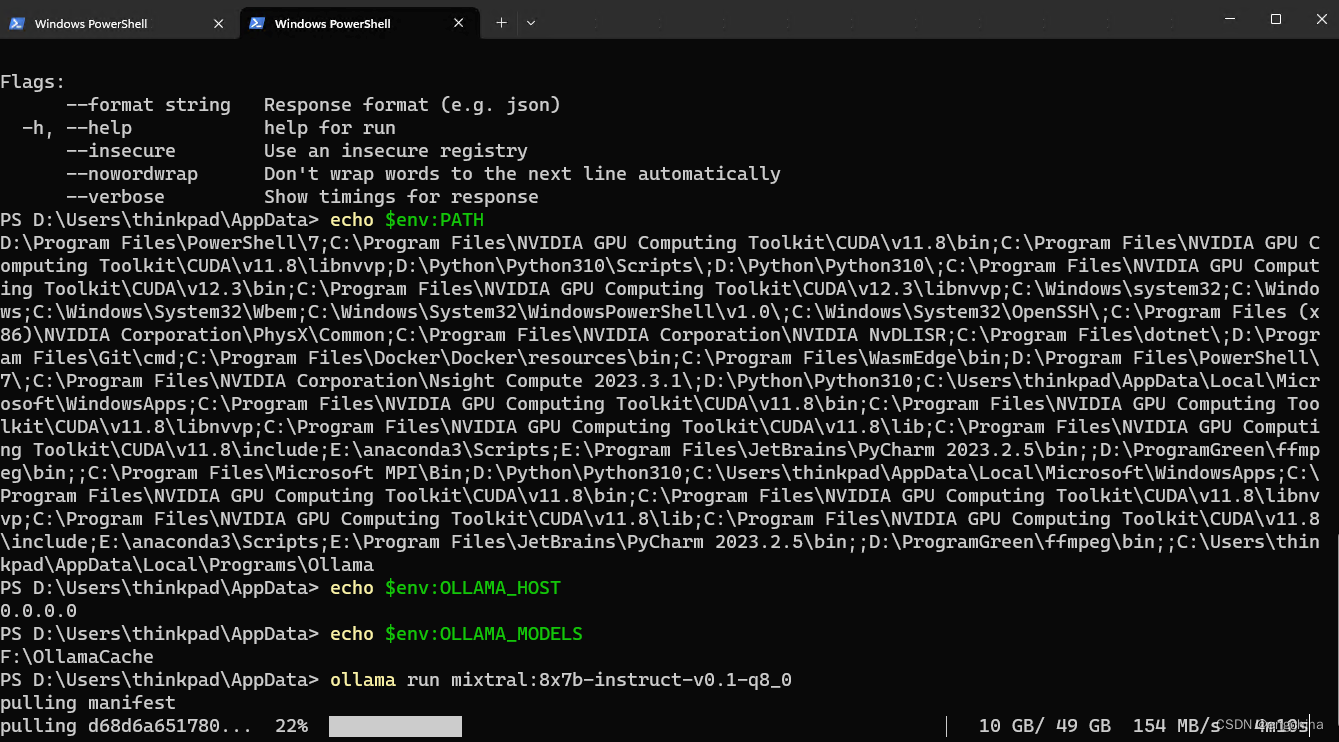

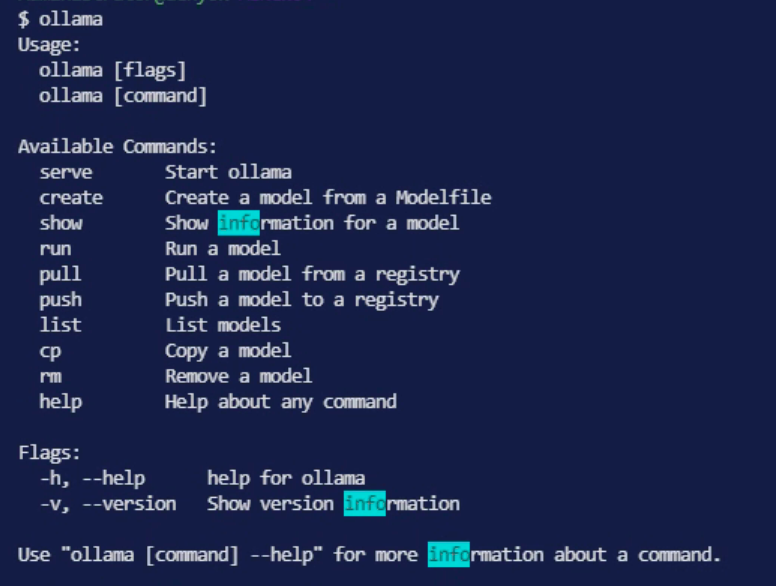

3. 使用 Ollama

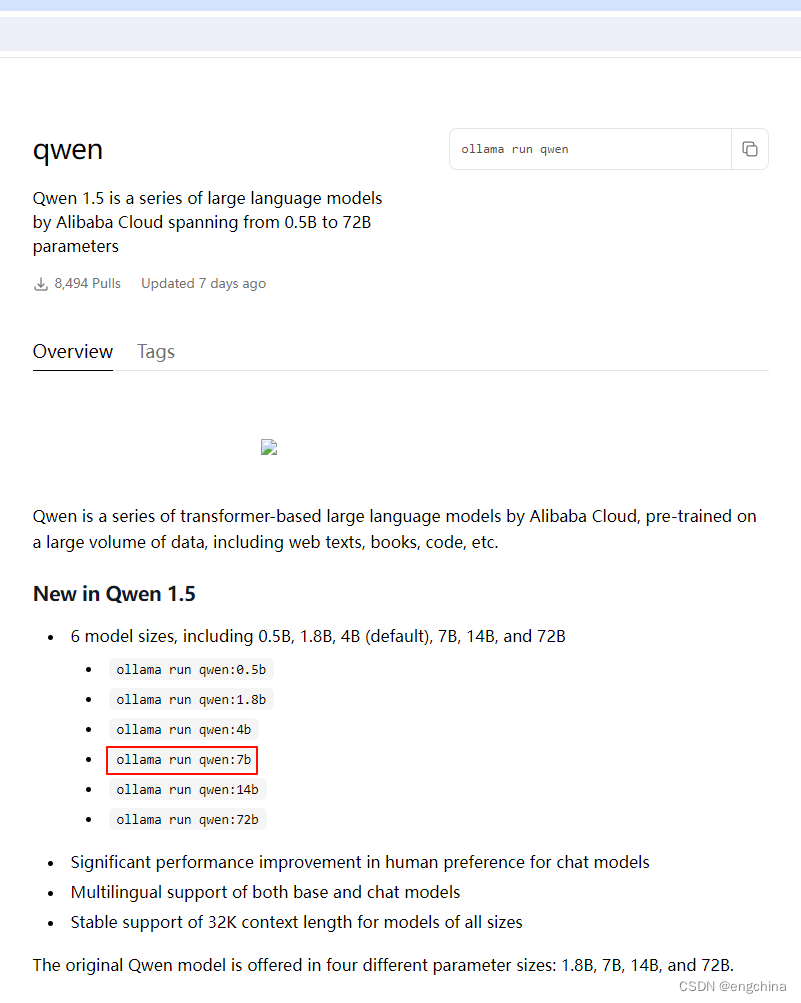

访问 https://ollama.com/library,搜索你要使用的模型,主流的模型,比如 llama2、qwen1.5、mixtral 等,Ollama都支持。

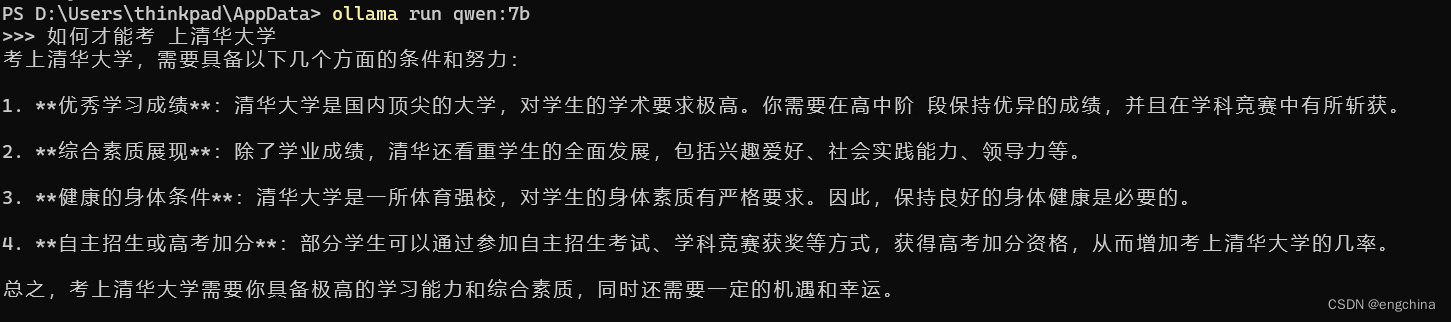

下面以允许 qwen 为例,我们要运行 7b 的模型,

拷贝上面红框的命令并运行,

ollama run qwen:7b

问一个问题试试,

完结!

![【sgCreateTableColumn】自定义小工具:敏捷开发→自动化生成表格列html代码(表格列生成工具)[基于el-table-column]](https://img-blog.csdnimg.cn/direct/1ce75f457fb24b5ba540809aedce0013.gif)

![[经验] 天猫盒子怎么投屏手机照片 #经验分享#其他#经验分享](https://img-home.csdnimg.cn/images/20230724024159.png?origin_url=https%3A%2F%2Fwww.hao123rr.com%2Fzb_users%2Fcache%2Fly_autoimg%2F%25E5%25A4%25A9%25E7%258C%25AB%25E7%259B%2592%25E5%25AD%2590%25E6%2580%258E%25E4%25B9%2588%25E6%258A%2595%25E5%25B1%258F%25E6%2589%258B%25E6%259C%25BA%25E7%2585%25A7%25E7%2589%2587.jpg&pos_id=A4SDL2Lz)