姿态估计(PoseEstimation)在我们前面的相关项目中涉及到的并不多,CV数据场景下主要还是以目标检测、图像识别和分割居多,最近正好项目中在使用YOLO系列最新的模型开发项目,就想着抽时间基于YOLOv8也开发构建实现姿态估计分析系统。在前面的博文实践中我们已经构建开发了基于人体的姿态估计分析系统,而关于动物的姿态估计则很少涉及,本文的主要思想就是想要基于最新的YOLOv8来开发构建动物姿态估计分析系统,这里我们选定以老虎为分析对象。

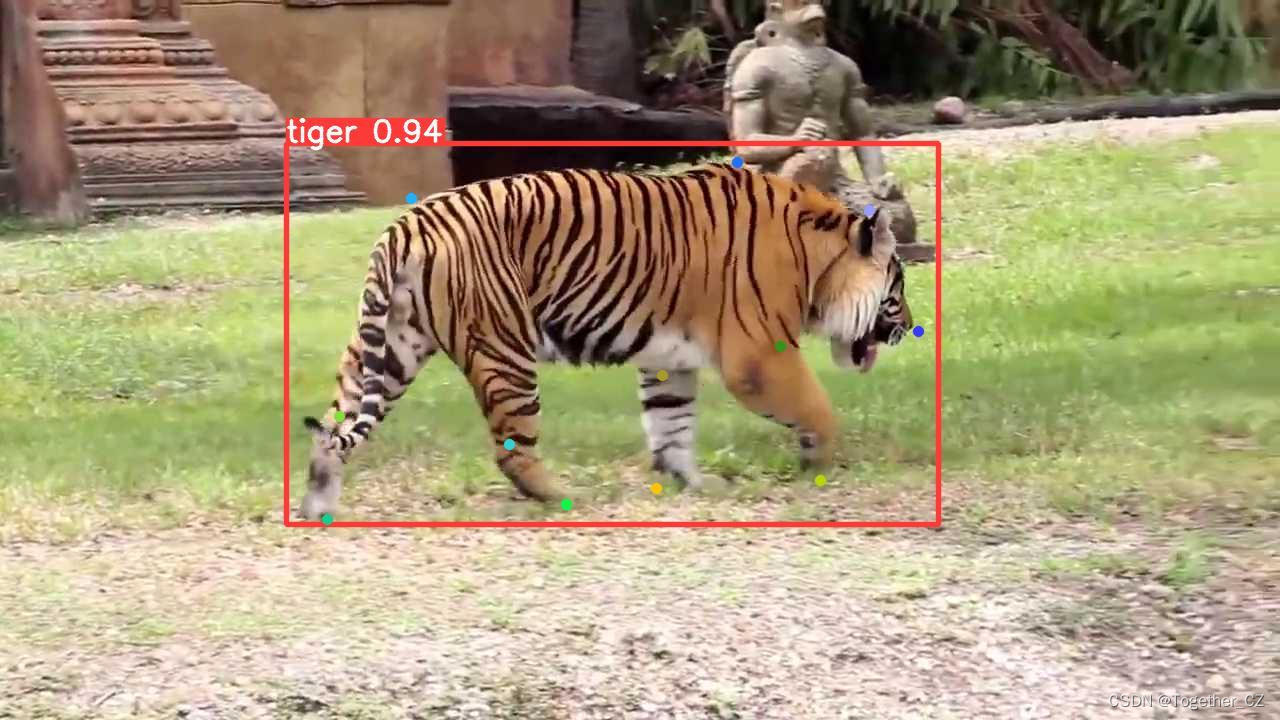

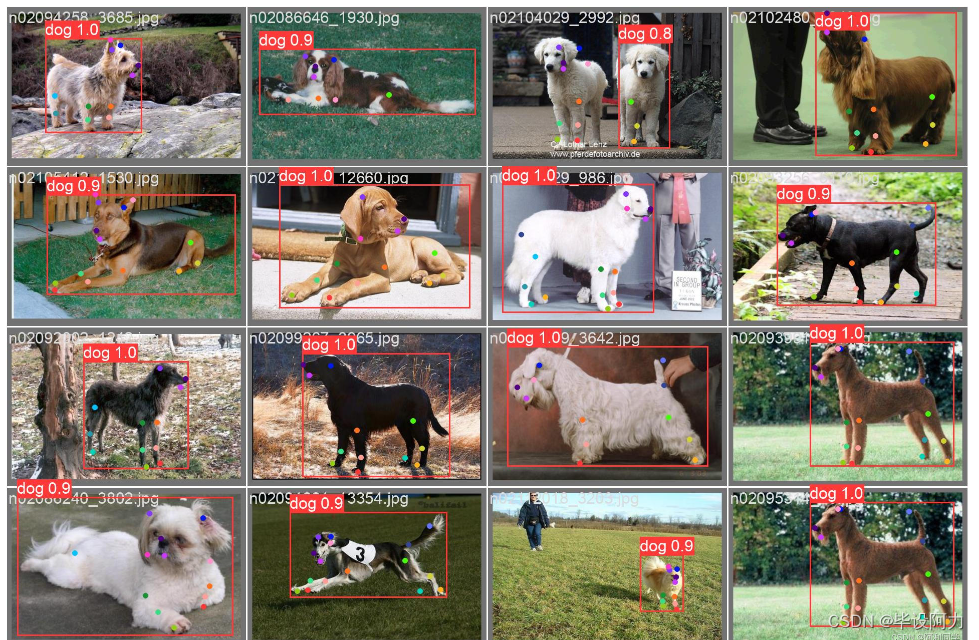

首先看下实例效果:

接下来简单看下我们构建的数据集:

实例标注数据如下所示:

0 0.5109375 0.4895833333333333 0.68125 0.6013888888888889 0.84765625 0.5055555555555555 0.79921875 0.3 0.64453125 0.2 0.2828125 0.25555555555555554 0.40703125 0.6611111111111111 0.47890625 0.7652777777777777 0.21875 0.7638888888888888 0.253125 0.4652777777777778 0.65390625 0.5388888888888889 0.62421875 0.7513888888888889 0.59453125 0.5555555555555556 0.73671875 0.7583333333333333

这里姿态估计的训练数据配置有别于目标检测,需要额外给出点位字段,下面给出来完整的训练数据配置文件内容:

# Dataset

path: ./dataset

train:

- /animal-pose-yolov8/dataset/images/train

val:

- /animal-pose-yolov8/dataset/images/test

test:

- /animal-pose-yolov8/dataset/images/test

kpt_shape: [12, 2]

flip_idx: [0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11]

# Classes

names:

0: tiger

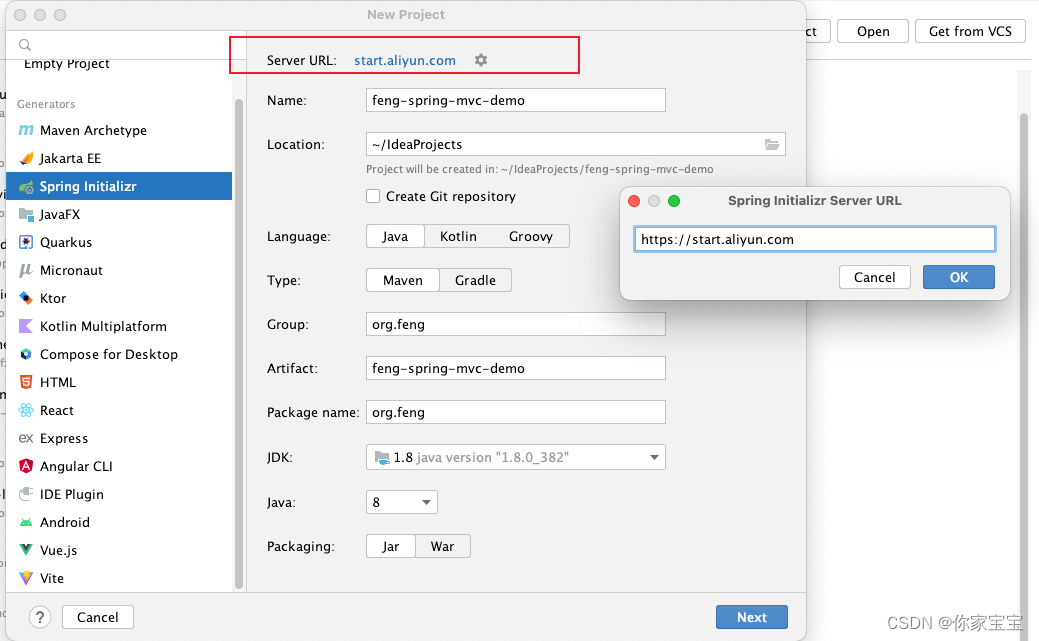

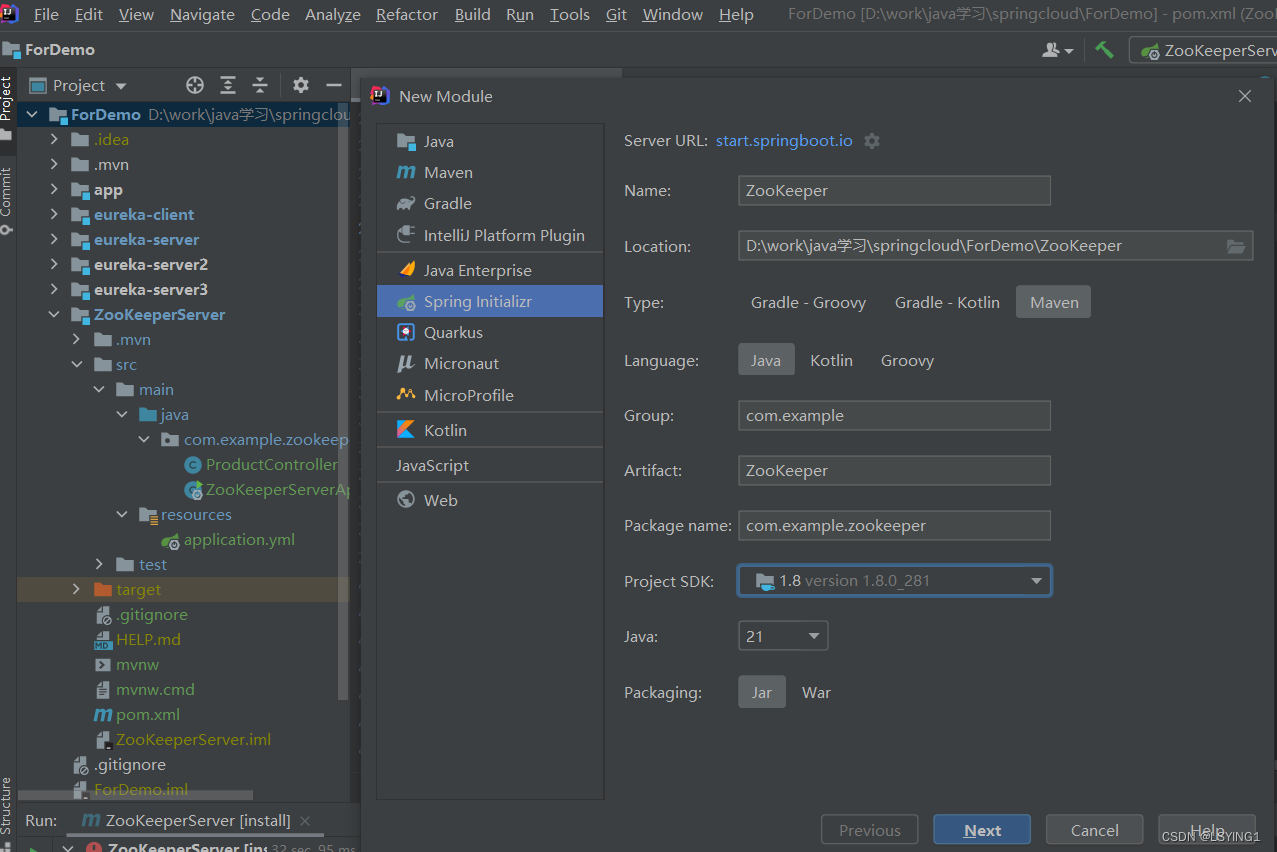

为了对YOLOv8这一款模型性能进行全面对比分析,这里我们开发构建了包括:n、s、m、l和x在内的全系列参数模型,模型文件如下:

# Parameters

nc: 1 # number of classes

kpt_shape: [17, 3]

scales: # model compound scaling constants, i.e. 'model=yolov8n-pose.yaml' will call yolov8-pose.yaml with scale 'n'

# [depth, width, max_channels]

n: [0.33, 0.25, 1024]

s: [0.33, 0.50, 1024]

m: [0.67, 0.75, 768]

l: [1.00, 1.00, 512]

x: [1.00, 1.25, 512]

# YOLOv8.0n backbone

backbone:

# [from, repeats, module, args]

- [-1, 1, Conv, [64, 3, 2]] # 0-P1/2

- [-1, 1, Conv, [128, 3, 2]] # 1-P2/4

- [-1, 3, C2f, [128, True]]

- [-1, 1, Conv, [256, 3, 2]] # 3-P3/8

- [-1, 6, C2f, [256, True]]

- [-1, 1, Conv, [512, 3, 2]] # 5-P4/16

- [-1, 6, C2f, [512, True]]

- [-1, 1, Conv, [1024, 3, 2]] # 7-P5/32

- [-1, 3, C2f, [1024, True]]

- [-1, 1, SPPF, [1024, 5]] # 9

# YOLOv8.0n head

head:

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 6], 1, Concat, [1]] # cat backbone P4

- [-1, 3, C2f, [512]] # 12

- [-1, 1, nn.Upsample, [None, 2, 'nearest']]

- [[-1, 4], 1, Concat, [1]] # cat backbone P3

- [-1, 3, C2f, [256]] # 15 (P3/8-small)

- [-1, 1, Conv, [256, 3, 2]]

- [[-1, 12], 1, Concat, [1]] # cat head P4

- [-1, 3, C2f, [512]] # 18 (P4/16-medium)

- [-1, 1, Conv, [512, 3, 2]]

- [[-1, 9], 1, Concat, [1]] # cat head P5

- [-1, 3, C2f, [1024]] # 21 (P5/32-large)

- [[15, 18, 21], 1, Pose, [nc, kpt_shape]] # Pose(P3, P4, P5)在实验阶段我们设定不同系列的参数模型完全相同的训练配置,等待全部训练完成后来看下结果详情对比情况。

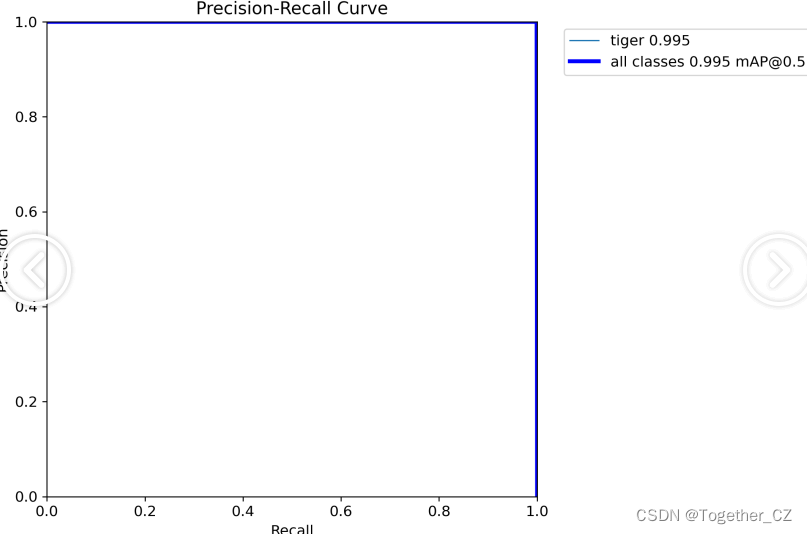

【Precision曲线】

精确率曲线(Precision-Recall Curve)是一种用于评估二分类模型在不同阈值下的精确率性能的可视化工具。它通过绘制不同阈值下的精确率和召回率之间的关系图来帮助我们了解模型在不同阈值下的表现。

精确率(Precision)是指被正确预测为正例的样本数占所有预测为正例的样本数的比例。召回率(Recall)是指被正确预测为正例的样本数占所有实际为正例的样本数的比例。

绘制精确率曲线的步骤如下:

使用不同的阈值将预测概率转换为二进制类别标签。通常,当预测概率大于阈值时,样本被分类为正例,否则分类为负例。

对于每个阈值,计算相应的精确率和召回率。

将每个阈值下的精确率和召回率绘制在同一个图表上,形成精确率曲线。

根据精确率曲线的形状和变化趋势,可以选择适当的阈值以达到所需的性能要求。

通过观察精确率曲线,我们可以根据需求确定最佳的阈值,以平衡精确率和召回率。较高的精确率意味着较少的误报,而较高的召回率则表示较少的漏报。根据具体的业务需求和成本权衡,可以在曲线上选择合适的操作点或阈值。

精确率曲线通常与召回率曲线(Recall Curve)一起使用,以提供更全面的分类器性能分析,并帮助评估和比较不同模型的性能。

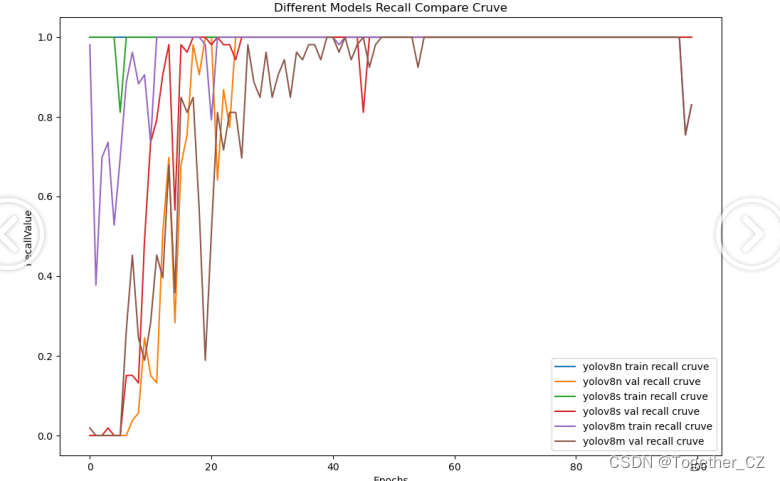

【Recall曲线】

召回率曲线(Recall Curve)是一种用于评估二分类模型在不同阈值下的召回率性能的可视化工具。它通过绘制不同阈值下的召回率和对应的精确率之间的关系图来帮助我们了解模型在不同阈值下的表现。

召回率(Recall)是指被正确预测为正例的样本数占所有实际为正例的样本数的比例。召回率也被称为灵敏度(Sensitivity)或真正例率(True Positive Rate)。

绘制召回率曲线的步骤如下:

使用不同的阈值将预测概率转换为二进制类别标签。通常,当预测概率大于阈值时,样本被分类为正例,否则分类为负例。

对于每个阈值,计算相应的召回率和对应的精确率。

将每个阈值下的召回率和精确率绘制在同一个图表上,形成召回率曲线。

根据召回率曲线的形状和变化趋势,可以选择适当的阈值以达到所需的性能要求。

通过观察召回率曲线,我们可以根据需求确定最佳的阈值,以平衡召回率和精确率。较高的召回率表示较少的漏报,而较高的精确率意味着较少的误报。根据具体的业务需求和成本权衡,可以在曲线上选择合适的操作点或阈值。

召回率曲线通常与精确率曲线(Precision Curve)一起使用,以提供更全面的分类器性能分析,并帮助评估和比较不同模型的性能。

【F1值曲线】

F1值曲线是一种用于评估二分类模型在不同阈值下的性能的可视化工具。它通过绘制不同阈值下的精确率(Precision)、召回率(Recall)和F1分数的关系图来帮助我们理解模型的整体性能。

F1分数是精确率和召回率的调和平均值,它综合考虑了两者的性能指标。F1值曲线可以帮助我们确定在不同精确率和召回率之间找到一个平衡点,以选择最佳的阈值。

绘制F1值曲线的步骤如下:

使用不同的阈值将预测概率转换为二进制类别标签。通常,当预测概率大于阈值时,样本被分类为正例,否则分类为负例。

对于每个阈值,计算相应的精确率、召回率和F1分数。

将每个阈值下的精确率、召回率和F1分数绘制在同一个图表上,形成F1值曲线。

根据F1值曲线的形状和变化趋势,可以选择适当的阈值以达到所需的性能要求。

F1值曲线通常与接收者操作特征曲线(ROC曲线)一起使用,以帮助评估和比较不同模型的性能。它们提供了更全面的分类器性能分析,可以根据具体应用场景来选择合适的模型和阈值设置。

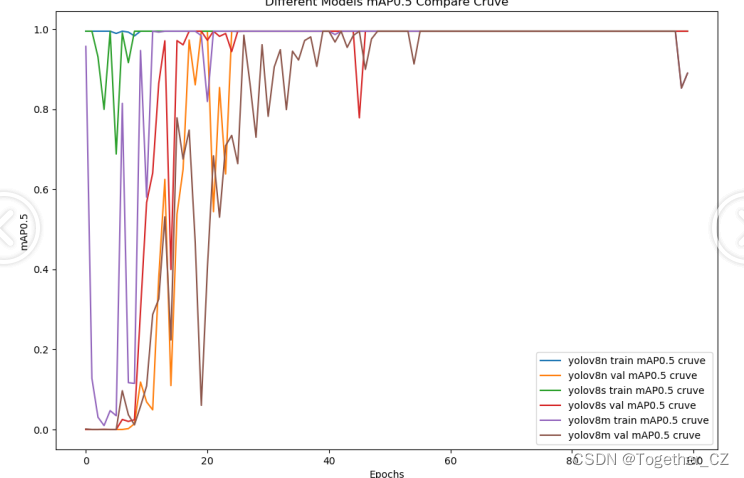

【mAP0.5】

mAP0.5(mean Average Precision at 0.5 IoU)

mAP0.5表示在IoU(交并比)阈值为0.5的情况下计算的平均精度(Average Precision,AP)。

IoU阈值决定了何时认为检测框与真实框匹配。较高的IoU阈值意味着更严格的匹配标准。

mAP0.5主要关注低阈值下的性能,即当IoU接近0.5时,模型在识别重叠框时的准确性。

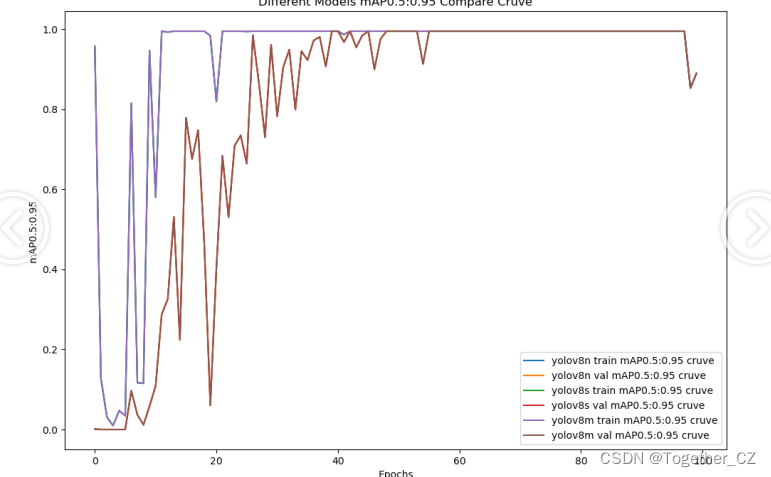

【mAP0.5:0.95】

mAP0.5:0.95(mean Average Precision over IoU thresholds from 0.5 to 0.95):

mAP0.5:0.95表示在多个IoU阈值(从0.5到0.95)下计算的平均精度。

它涵盖了从低到高的IoU阈值,更全面地评估了模型在不同IoU阈值下的性能。

mAP0.5:0.95可以帮助我们了解模型在不同重叠程度下的检测能力。

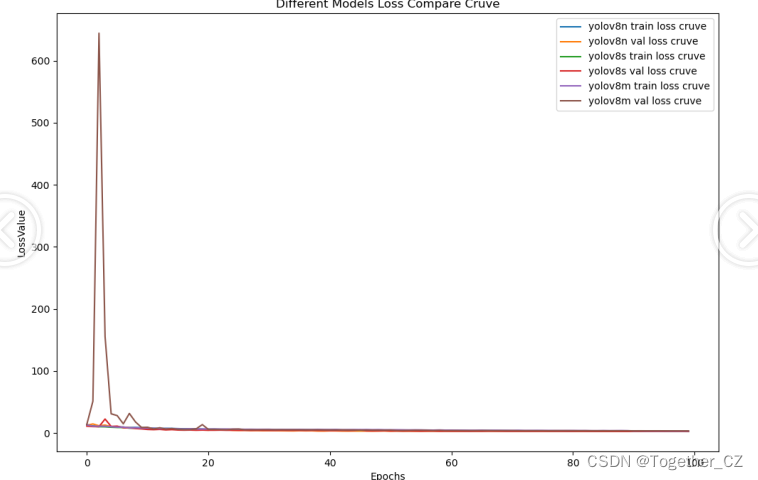

【loss曲线】

从实验对比结果来看:几款不同参数量级的模型在40个epoch有比较明显的差距,到了50个epoch之后就达到了基本相近的水准了,这里最终考虑选择使用s系列的模型来作为线上推理模型。

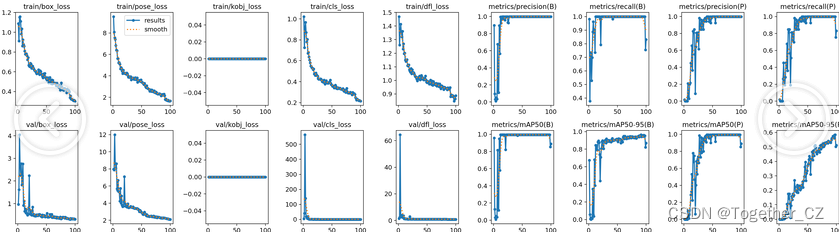

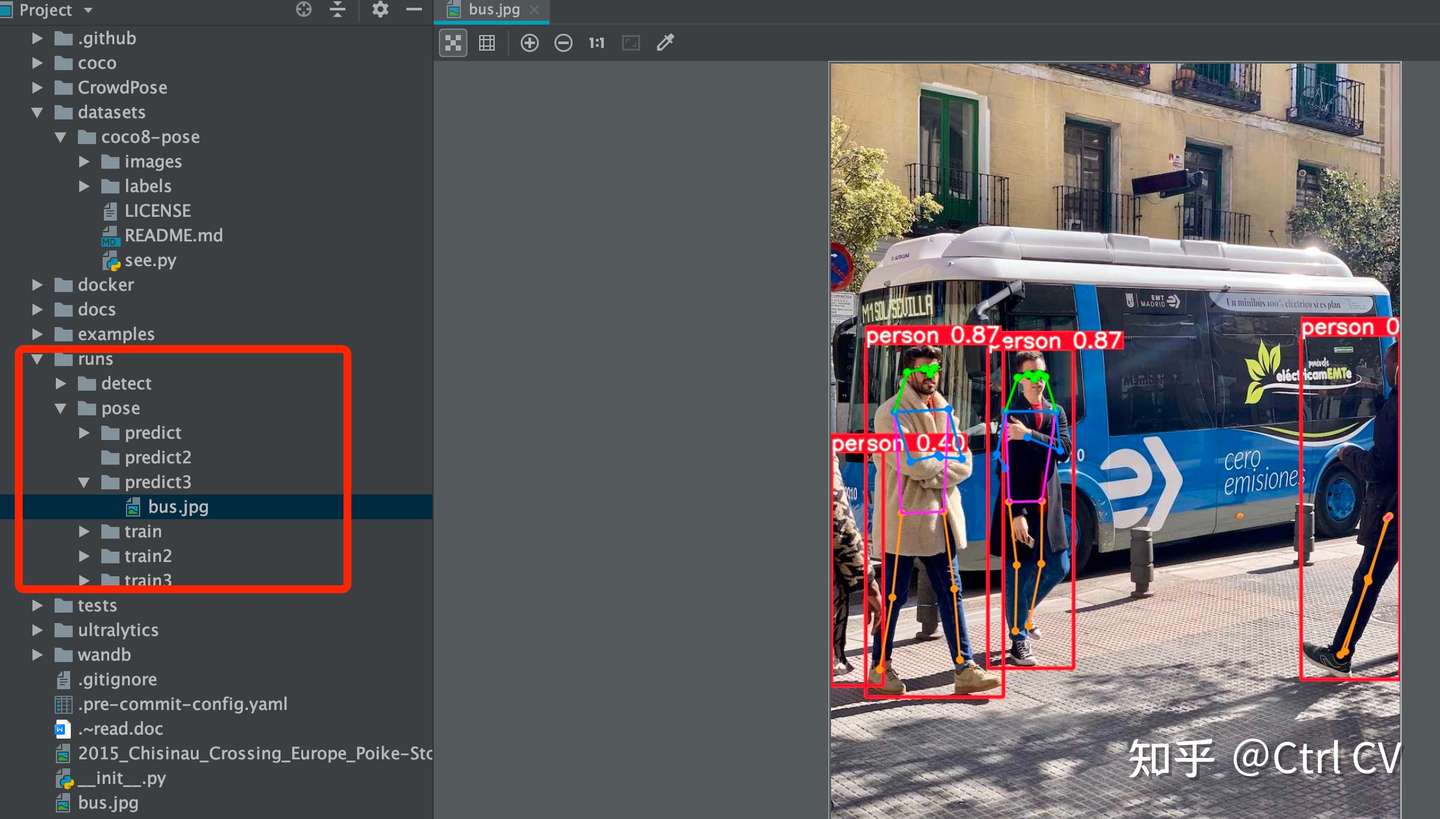

接下来我们以s系列模型为例看下结果详情:

【Batch实例】

【训练可视化】

【PR曲线】

【离线推理实例效果如下】

感兴趣的话也都可以试试看!

如果自己不具备开发训练的资源条件或者是没有时间自己去训练的话这里我提供出来对应的训练结果可供自行按需索取。

![[word] word中页眉怎么设置与上一节不同 #笔记#笔记#经验分享](https://img-blog.csdnimg.cn/img_convert/5942b618133e47538c9dc4d53e3a0b5e.png)