我在李沐动手深度学习中第10章学了多头注意力。

最近的论文里有多尺度注意力,其实这俩不一样,我下面综述一下两者的区别。

多头注意力(Multi-head Attention)和多尺度注意力(Multi-scale Attention)是两种不同的注意力机制,它们在处理输入数据时关注不同的方面。虽然两者都旨在提高模型对输入数据的理解和处理能力,但它们的设计理念、目标和应用场景有所不同。

多头注意力(Multi-head Attention)

- 设计理念:多头注意力机制的核心思想是同时从不同的表示子空间(或“头”)中捕获输入数据的不同特征。在这种机制中,注意力机制被分成多个“头”,每个头独立地对输入进行处理,然后将所有头的输出合并起来。这允许模型在不同的表示空间中捕获信息,从而获得更丰富和全面的输入数据表示。

- 主要目的:通过并行地关注输入的不同方面,多头注意力旨在提高模型的表示能力,使其能够更好地捕捉到输入之间的复杂关系,如不同层次的语义或不同类型的信息。

- 应用场景:多头注意力被广泛应用于自然语言处理(NLP)任务中,如机器翻译、文本生成、语言理解等,也被用于计算机视觉和多模态学习任务。

多尺度注意力(Multi-scale Attention)

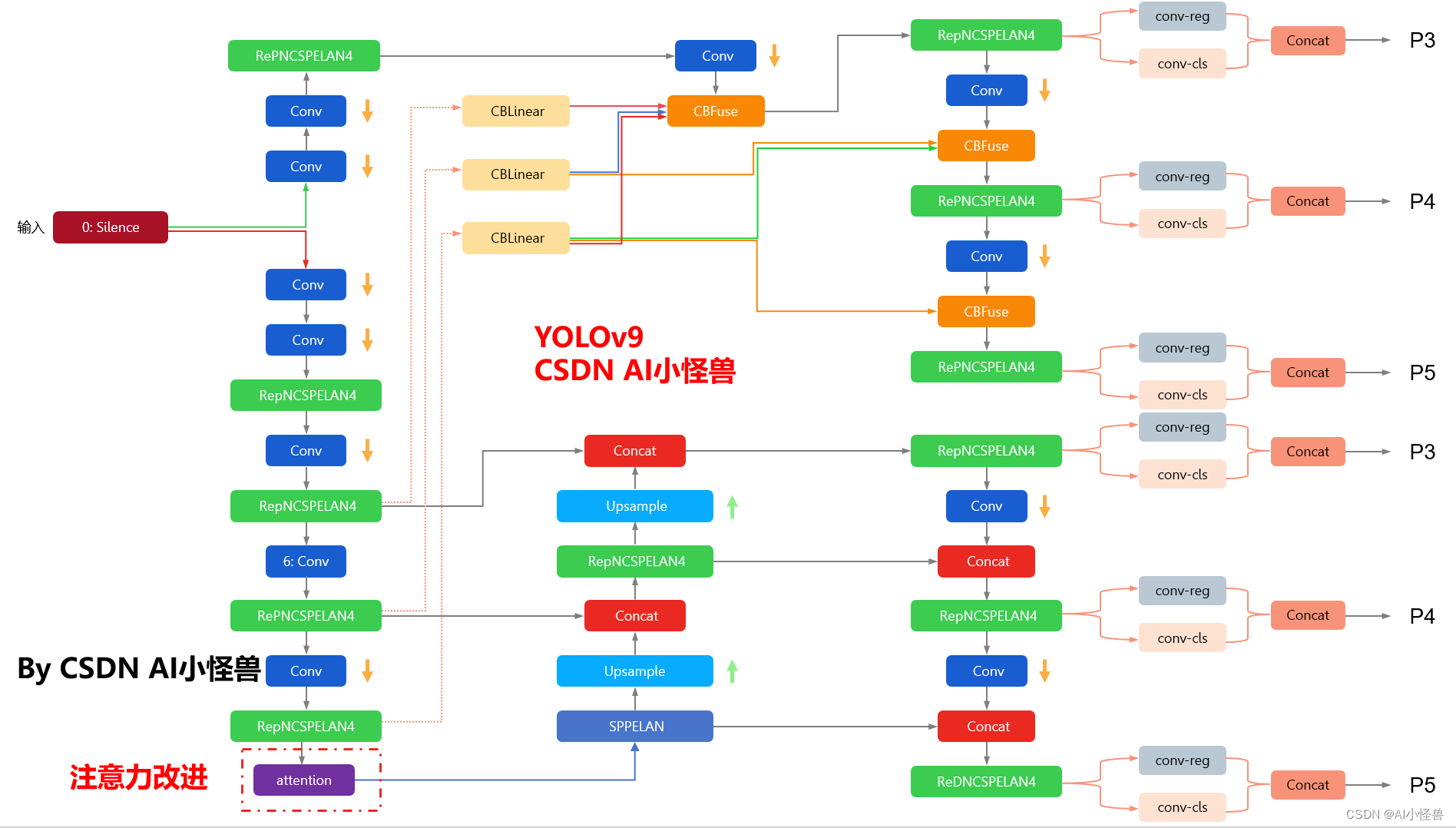

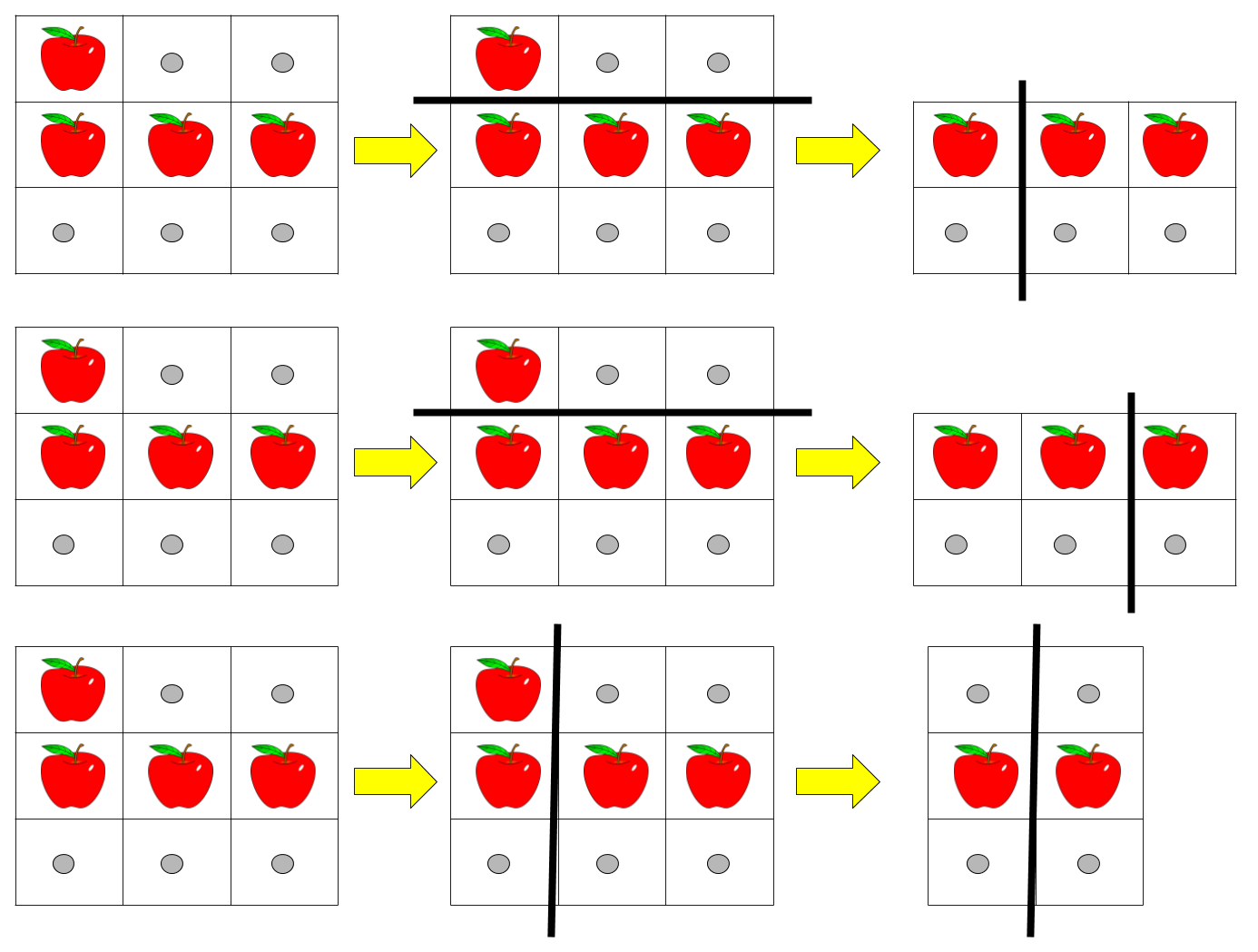

- 设计理念:多尺度注意力关注的是在不同的尺度(或分辨率)上捕获输入数据的特征。这种机制通过在多个尺度上处理输入数据(例如,图像的不同分辨率版本或文本的不同抽象级别),使模型能够同时捕获粗粒度(全局)和细粒度(局部)的特征。

- 主要目的:多尺度注意力的目的是增强模型对输入数据的多层次理解,使其能够同时考虑局部细节和全局上下文。这对于处理需要同时理解局部特征和全局结构的任务尤为重要。

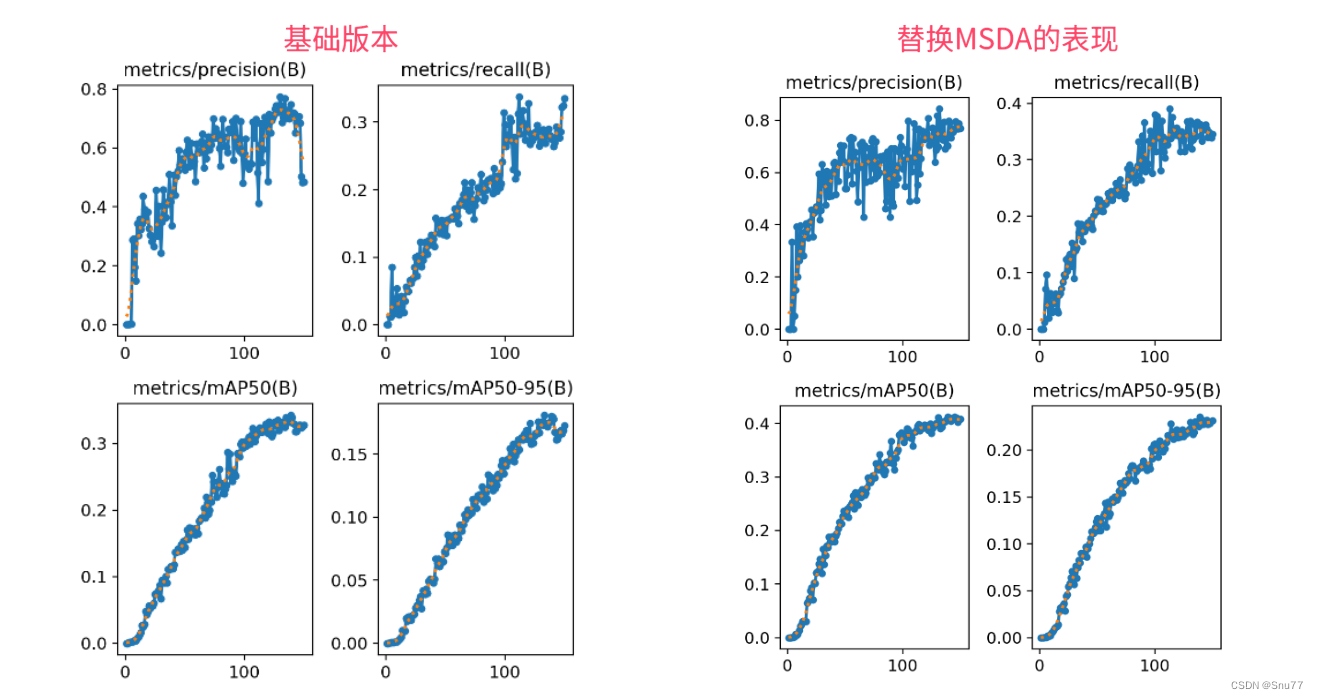

- 应用场景:多尺度注意力机制通常用于图像处理任务,如图像分类、目标检测和图像分割,也被应用于视频处理和某些NLP任务,以及需要综合多层次信息的场景。

总结

- 关注点不同:多头注意力通过将注意力分散到不同的表示子空间来增强模型的表示能力,而多尺度注意力通过在不同尺度上处理数据来捕获不同层次的特征。

- 目标不同:多头注意力旨在提高对输入数据复杂关系的理解,多尺度注意力则旨在通过结合局部细节和全局上下文来增强模型的感知能力。

- 应用场景不同:虽然两种机制都可以跨多个领域应用,但多头注意力更常见于NLP和多模态任务中,而多尺度注意力则更多应用于图像和视频处理领域。