本章主要内容:

- 了解群集的结构与工作模式

- 了解 LVS 负载均衡群集原理

- 学会配置 NFS 共享服务

- 学会构建 LVS-NAT 负载均衡群集

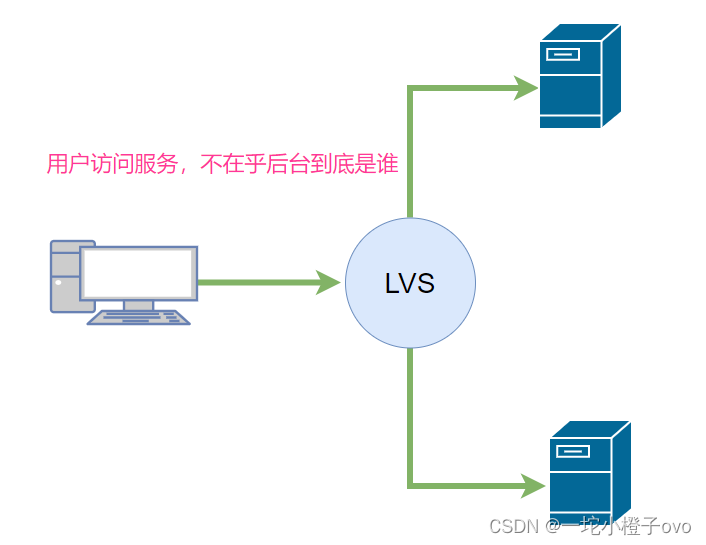

在各种互联网应用中,随着站点对硬件性能、响应速度、服务稳定性、数据可靠性等要求越来越高,单台服务器已经无法满足负载均衡及高可用的要求。除了使用价格昂贵的大型机、专用负载分流设备以外,企业还有另外一种选择来解决难题,那就是构建群集服务器— —通过整合多台服务器,使用 LVS 来达到服务器的高可用和负载均衡,并以同一个 IP 地址对外提供相同的服务。

本章将要学习在企业中常用的一种群集技术——LVS(Linux Virtual Server,Linux 虚拟服务器)。

1.1 LVS群集应用基础

群集的称呼来自于英文单词“Cluster”,表示一群、一串的意思,用在服务器领域则表示大量服务器的集合体,以区分于单个服务器。本节将对群集的结构、工作模式、LVS 虚拟应用,以及 NFS 共享存储介绍及使用。

1.1.1 群集技术概述

根据实际企业环境的不同,群集所提供的功能也各不相同,采用的技术细节也可能各有千秋。然而从整体上来看,需要先了解一些关于群集的共性特征,才能在构建和维护群集的工作中做到心中有数,避免操作上的盲目性。

1.群集的类型

无论是哪种群集,都至少包括两台节点服务器,而对外表现为一个整体,只提供一个访问入口。根据群集所针对的目标差异,可分为以下三种类型。

-

负载均衡群集(Load Balance Cluster):以提高应用系统的响应能力、尽可能处理更多的访问请求、减少延迟为目标,获得高并发、高负载的整体性能。例如,“DNS轮询”“应用层交换”“反向代理”等都可用作负载均衡群集。LB 的负载分配依赖于主节点的分流算法,将来自客户机的访问请求分担给多个服务器节点,从而缓解整个系统的负载压力。

-

高可用群集(High Availability Cluster):以提高应用系统的可靠性、尽可能地减少中断时间为目标,确保服务的连续性,达到高可用(HA)的容错效果。例如,“故障切换”“双机热备”“多机热备”等都属于高可用群集技术。HA 的工作方式包括双工和主从两种模式。双工即所有节点同时在线;主从则只有主节点在线,但当出现故障时从节点能自动切换为主节点。

-

高性能运算群集(High Performance Computer Cluster):以提高应用系统的 CPU运算速度、扩展硬件资源和分析能力为目标,获得相当于大型、超级计算机的高性 能运算(HPC)能力。例如,“云计算”“网格计算”也可视为高性能运算的一种。高性能运算群集的高性能依赖于“分布式运算”“并行计算”,通过专用硬件和软件将多个服务器的 CPU、内存等资源整合在一起,实现只有大型、超级计算机才具备的计算能力。

2. 负载均衡的分层结构

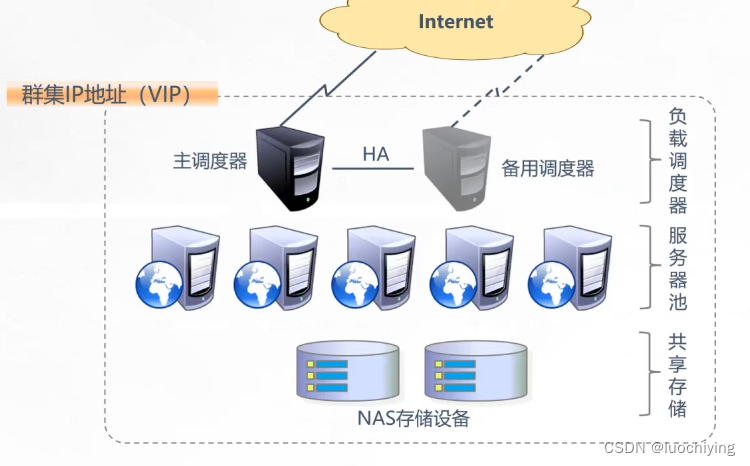

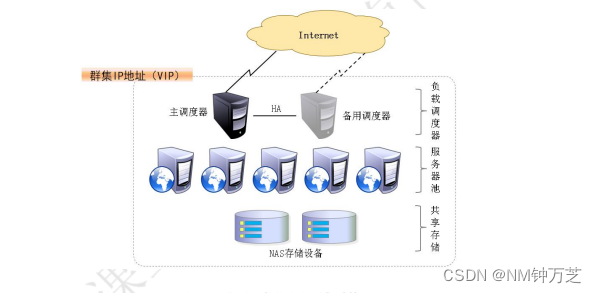

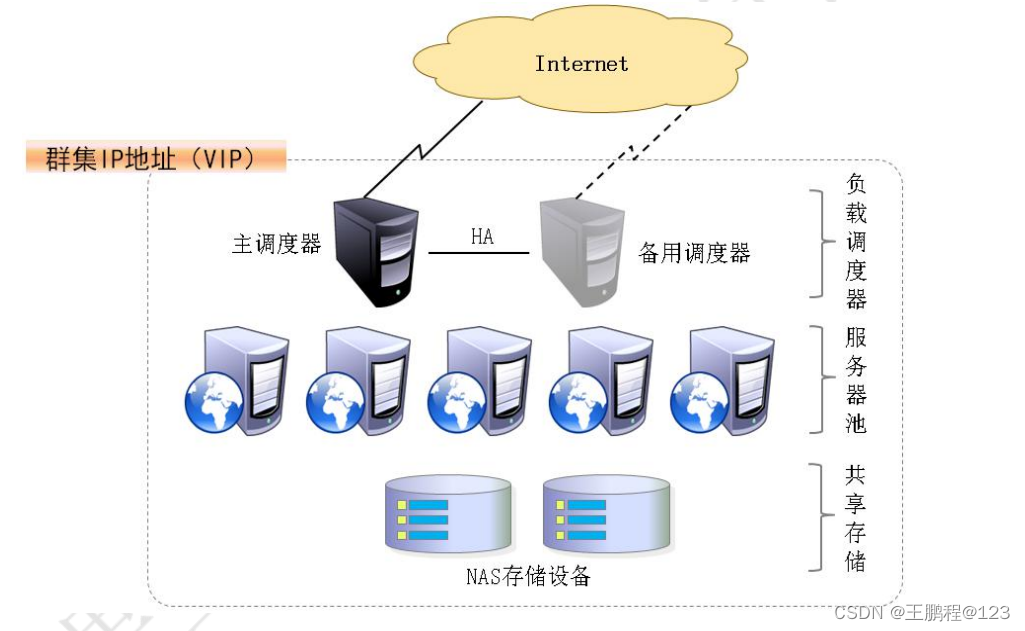

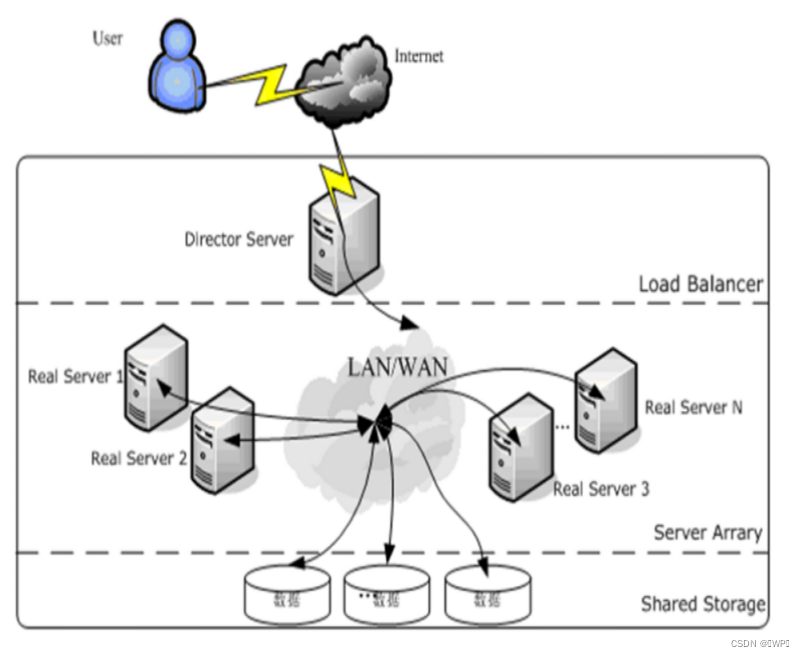

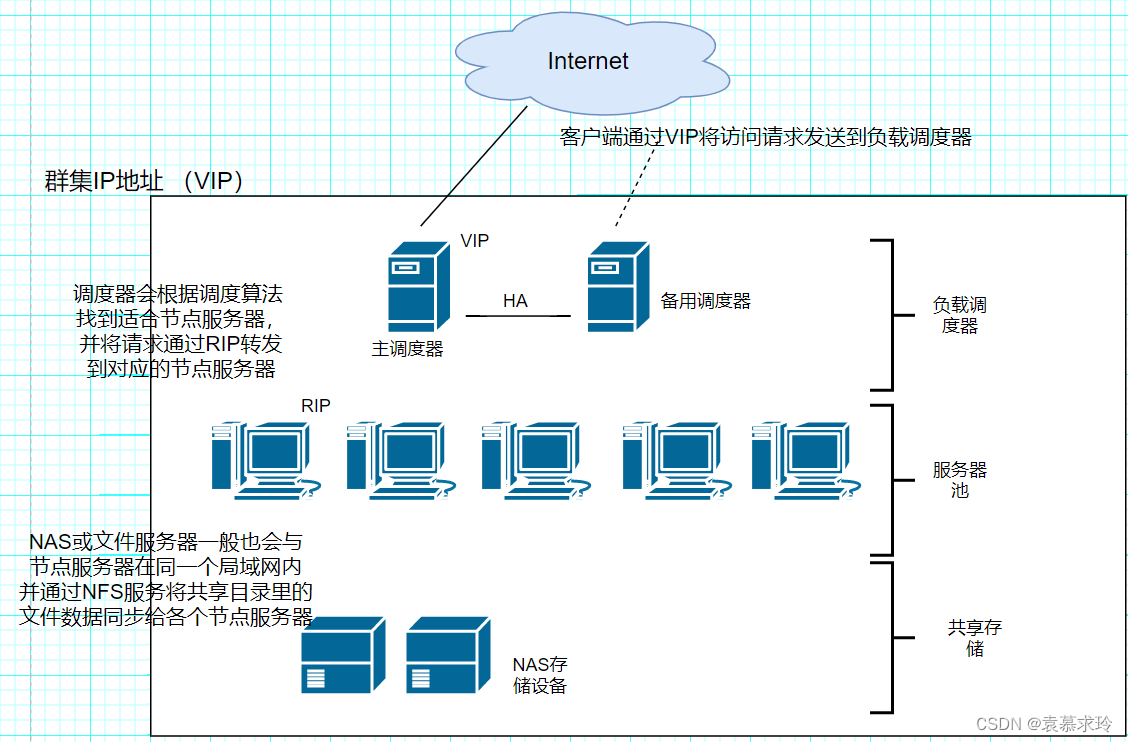

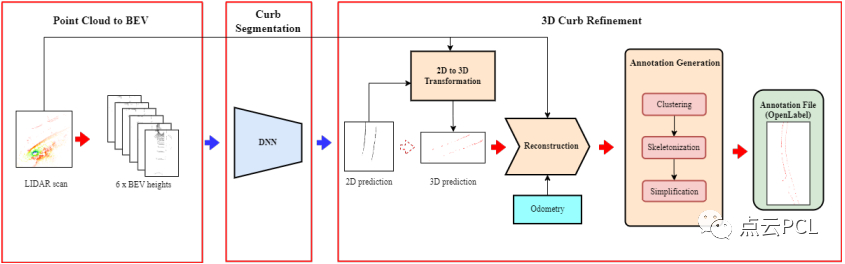

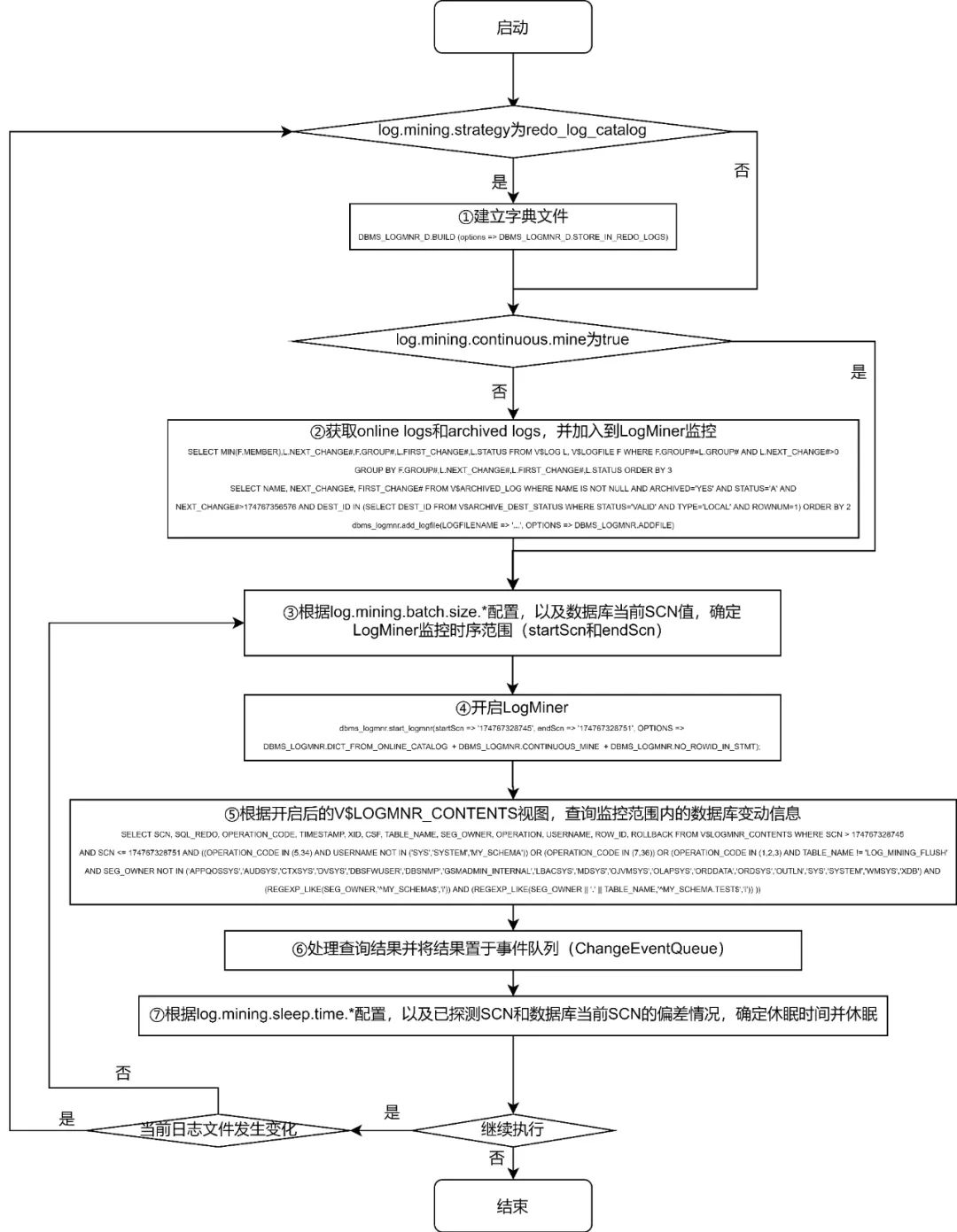

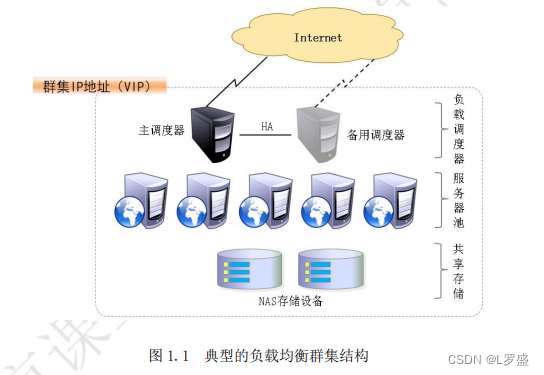

在典型的负载均衡群集中,包括三个层次的组件,如图 1.1 所示。前端至少有一个负载调度器(Load Balancer,或称为 Director)负责响应并分发来自客户机的访问请求;后端由大量真实服务器(Real Server)构成服务器池(Server Pool),提供实际的应用服务,整个群集的伸缩性通过增加、删除服务器节点来完成,而这些过程对客户机是透明的;为了保持服务的一致性,所有节点使用共享存储设备。

> 第一层,负载调度器:这是访问整个群集系统的唯一入口,对外使用所有服务器共有的 VIP(Virtual IP 虚拟IP)地址,也称为群集IP地址。通常会配置主,备 两台调度器实现热备份,当主调度器失效以后能够平滑替换至备用调度器,确保高可用性。

> 第二层,服务器池:群集所提供的应用服务(如 HTTP,FTP)由服务器池承担,其中每个节点具有独立的 RIP(Real IP,真实IP)地址,只处理调度器分发过来的客户机请求,当某个节点暂时失效时,负载调度器的容错机制将其隔离,等待错误排除以后再重新纳入服务器池。

> 第三次,共享存储:为服务器池中的所有节点提供稳定,一致的文件存取服务,确保整个群集的统一性。在 Linux/UNIX 环境中,共享存储可以使用 NAS设备,或者提供 NFS(Network File System,网络文件系统)共享服务的专用服务器

3.负载均衡的工作模式

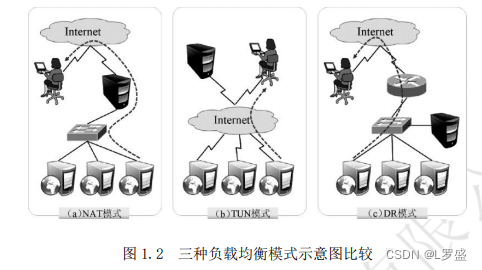

关于群集的负载调度技术,可以基于 IP、端口、内容等进行分发,其中基于 IP 的负载调度是效率最高的。基于 IP 的负载均衡模式中,常见的有地址转换、IP 隧道和直接路由三种工作模式,如图 1.2 所示。

- 地址转换(Network Address Translation):简称 NAT 模式,类似于防火墙的私有网络结构,负载调度器作为所有服务器节点的网关,即作为客户机的访问入口,也是各节点回应客户机的访问出口。服务器节点使用私有IP地址,与负载调度器位于同一个物理网络,安全性要优于其他两种方式

- IP隧道(IP Tunnel):简称 TUN 模式,采用开放式的网络结构,负载调度器仅作为客户机的访问入口,各节点通过各自的 Internet 连接直接回应客户机,而不再经过负载调度器。服务器节点分散在互联网中的不同位置,具有独立的公网IP地址,通过专用的 IP 隧道于负载调度器相互通信

-

直接路由(Direct Routing):简称 DR 模式,采用半开放式的网络结构,与 TUN 模式的结构类似,但各节点并不是分散在各地,而是与调度器位于同一个物理网络。负载调度器与各节点服务器通过本地网络连接,不需要建立专用的 IP 隧道。

以上三种工作模式中,NAT 方式只需要一个公网 IP 地址,从而成为最易用的一种负载均衡模式,安全性也比较好,许多硬件负载均衡设备就采用这种方式。相比较而言,DR 模式和 TUN 模式的负载能力更加强大,适用范围更广,但节点的安全性要稍差一些。

1.1.2 LVS 虚拟服务器

Linux Virtual Server 是针对 Linux 内核开发的一个负载均衡项目,由我国的章文嵩博士在1998 年 5 月创建,官方站点位于 http://www.linuxvirtualserver.org/。LVS 实际上相当于基于 IP 地址的虚拟化应用,为基于 IP 地址和内容请求分发的负载均衡提出了一种高效的解决方法。

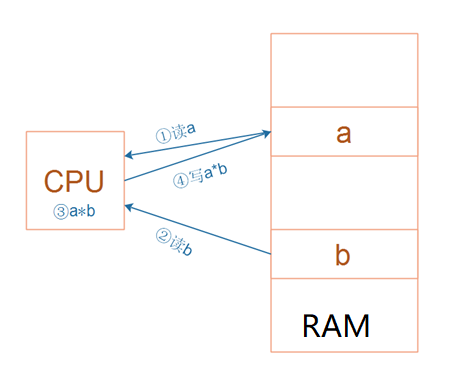

LVS 现在已成为 Linux 内核的一部分,默认编译为 ip_vs 模块,必要时能够自动调用。在 CentOS 7 系统中,以下操作可以手动加载 ip_vs 模块,并查看当前系统中 ip_vs 模块的版本信息。

[root@LVS ~]# modprobe ip_vs //加载ip_vs模块

[root@LVS ~]# cat /proc/net/ip_vs //查看ip_vs 版本信息

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

[root@LVS ~]# 开启路由转发

[root@LVS ~]# vim /etc/sysctl.conf

[root@LVS ~]# cat /etc/sysctl.conf | grep net

net.ipv4.ip_forward = 1

[root@LVS ~]# sysctl -p

net.ipv4.ip_forward = 1

[root@LVS ~]#

下面将介绍LVS 所支持的主要负载调度算法,以及在LVS 负载均衡调度器上如何使用 ipvsadm管理工具

1.LVS 的负载调度算法

针对不同的网络服务喝配置需要,LVS 调度器提供多种不同的负载调度算法,其中最常用的四种算法时轮询,加权轮询,最少连接和加权最少连接

- 轮询(Round Robin):将会收到的访问请求安装顺序轮流分配给群集中的各节点,均等的对待每台服务器,而不管服务器实际的连接数和系统负载

- 加权轮询(Weifhed Round Robin):根据调度器设置的权重值来分发请求,权重值高的节点优先获得任务并且分配的请求越多,这样可以保证性能高的节点承担更多的请求

- 最少连接(Least Connections):根据真实服务器以建立的连接数进行分配,将收到的访问请求优先分配给连接数最少的节点。如果所有的服务器系节点性能相近,采用这种方式可以更好的均衡负载

- 加权最少连接(Weighted Least Connections):在服务器的性能差异较大的情况下,调度器可以根据节点服务器负载自动调整权重,权重较高的节点将承担更大比例的活动连接负载

2.使用 ipvsadm 管理工具

ipvsadm 是在负载调度器上使用的 LVS 群集管理工具,通过调用 ip_vs 模块来添加、删除 服 务器 节 点 ,以 及 查 看 群集 的 运 行状 态 。 在 CentOS 7 系 统 中 , 需 要 手动 安装

ipvsadm.x86_64 0:1.27-7.el7 软件包。

[root@LVS ~]# yum -y install ipvsadm

[root@LVS ~]# ipvsadm -v

ipvsadm v1.27 2008/5/15 (compiled with popt and IPVS v1.2.1)

LVS 群集的管理工作主要包括创建虚拟服务器、添加服务器节点、查看群集节点状态、删除服务器节点和保存负载分配策略。下面分别展示使用 ipvsadm 命令的操作方法。

1)创建虚拟服务器

若群集的 VIP 地址为 192.168.182.100,针对 TCP 80 端口提供负载分流服务,使用的调度算法为轮询,则对应的 ipvsadm 命令操作如下所示。对于负载均衡调度器来说,VIP 必须是本机实际已启用的 IP 地址。

[root@LVS ~]# ipvsadm -A -t 192.168.182.100:80 -s rr

上述操作中,选项-A 表示添加虚拟服务器,-t 用来指定 VIP 地址及 TCP 端口,-s 用来指定负载调度算法——轮询(rr)、加权轮询(wrr)、最少连接(lc)、加权最少连接(wlc)。

2)添加服务器节点

为虚拟服务器 192.168.182.100 添加四个服务器节点,IP 地址依次为 192.168.182.101~105,对应的 ipvsadm 命令操作如下所示。若希望使用保持连接,还应添加“-p 60”选项,其中60 为保持时间(单位为 s)。

[root@LVS ~]# ipvsadm -a -t 192.168.182.100:80 -r 192.168.182.101:80 -m -w 1

[root@LVS ~]# ipvsadm -a -t 192.168.182.100:80 -r 192.168.182.102:80 -m -w 1上述操作中,有以下选择

- -a 表示添加真实服务器

- -t 用来指定 VIP 地址及TCP端口

- -r 用来指定 RIP 地址及 TCP 端口

- -m 表示使用 NAT 群集模式(-g DR模式,-i TUN 模式)

- -w 用来设置权重(权重为0时表示暂停节点)

3)查看群集状态

结合选项-l 可以列表查看 LVS 虚拟服务器,可以指定只查看某一个 VIP 地址(默认为查看所有),结合选项-n 将以数字形式显示地址、端口等信息。

[root@LVS ~]# ipvsadm -ln //查看节点状态

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.182.100:80 rr

-> 192.168.182.101:80 Masq 1 0 0

-> 192.168.182.102:80 Masq 1 0 0

[root@LVS ~]#

上述输出结果中,Forward 列下的 Masq 对应 Masquerade(地址伪装),表示采用的群集模式为 NAT。如果是 Route,则表示采用的群集模式为 DR。

4)删除服务器节点

需要从服务器池中删除某一个节点时,使用选项-d。执行删除操作必须指定目标对象,包括节点地址、虚拟 IP 地址。例如,以下操作将会删除 LVS 群集 192.168.182.100 中的节点 192.168.182.101。

[root@LVS ~]# ipvsadm -d -t 192.168.182.100:80 -r 192.168.182.101:80

或

[root@LVS ~]# ipvsadm -d -r 192.168.182.101:80 -t 192.168.182.100:80

[root@LVS ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.182.100:80 rr

-> 192.168.182.102:80 Masq 1 0 0

[root@LVS ~]#

需要删除整个虚拟服务器时,使用选项-D 并指定虚拟 IP 地址即可,无须指定节点。例如,若执行“ipvsadm -D -t 192.168.182.100:80”,则删除此虚拟服务器。

5)保存负载配置策略

使用导出/导入工具 ipvsadm-save/ipvsadm-restore 可以保存、恢复 LVS 策略。当然也可以快速清除、重建负载分配策略。

[root@LVS ~]# ipvsadm-save > /etc/sysconfig/ipvsadm //保存策略

[root@LVS ~]# cat /etc/sysconfig/ipvsadm //确认保存结果

-A -t LVS:http -s rr

-a -t LVS:http -r 192.168.182.101:http -m -w 1

-a -t LVS:http -r 192.168.182.102:http -m -w 1

[root@LVS ~]# systemctl stop ipvsadm.service //停止服务(清楚策略)

[root@LVS ~]# systemctl start ipvsadm.service //启动服务(重建规则)

[root@LVS ~]# systemctl status ipvsadm.service 1.1.3 NFS共享存储服务

NFS 服务的实现依赖于 RPC(Remote Process Call,远端过程调用)机制,以完成远程到本地的映射过程。在 CentOS 7 系统中,需要安装 nfs-utils、rpcbind 软件包来提供 NFS 共享服务,前者用于 NFS 共享发布和访问,后者用于 RPC 支持。

1)安装 nfs-utils,rpcbind 软件包

提供 RPC 支持的服务为 rpcbind,提供 NFS 共享的服务为 nfs,完成安装以后建议调整这两个服务的自启动状态,以便每次开机后自动启用。手动加载 NFS 共享服务时,应该先启动 rpcbind,再启动 nfs。

[root@nfs ~]# yum -y install nfs-utils rpcbind

[root@nfs ~]# systemctl enable nfs

[root@nfs ~]# systemctl enable rpcbind

2)设置共享目录

NFS 的配置文件为/etc/exports,文件内容默认为空(无任何共享)。在 exports 文件中设置共享资源时,记录格式为“目录位置客户机地址(权限选项)”。例如,若要将文件夹/opt/wwwroot 共享给 192.168.182.0/24 网段使用,允许读写操作,具体配置如下所示。

[root@nfs ~]# mkdir -p /opt/wwwroot

[root@nfs ~]# vim /etc/exports

[root@nfs ~]# cat /etc/exports

/opt/wwwroot 192.168.182.0/24(rw,sync,no_root_squash)

其中客户机地址可以是主机名、IP 地址、网段地址,允许使用*、?通配符;权限选项中的 rw 表示允许读写(ro 为只读),sync 表示同步写入,no_root_squash 表示当客户机以 root 身份访问时赋予本地 root 权限(默认是 root_squash,将作为 nfsnobody 用户降权对待)。

当需要将同一个目录共享给不同的客户机,且分配不同的权限时,只要以空格分隔指定多个“客户机(权限选项)”即可。例如,以下操作将/var/ftp/public 目录共享给两个客户机,并分别给予只读、读写权限。

[root@nfs ~]# vim /etc/exports

/var/ftp/public 192.168.182.101(ro) 192.168.182.102(rw)

3)启动 NFS服务程序

[root@nfs ~]# systemctl start rpcbind

[root@nfs ~]# systemctl start nfs

[root@nfs ~]# netstat -anpt | grep rpc

tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 64248/rpcbind

tcp 0 0 0.0.0.0:20048 0.0.0.0:* LISTEN 64447/rpc.mountd

tcp 0 0 0.0.0.0:40730 0.0.0.0:* LISTEN 64443/rpc.statd

tcp6 0 0 :::111 :::* LISTEN 64248/rpcbind

tcp6 0 0 :::20048 :::* LISTEN 64447/rpc.mountd

tcp6 0 0 :::55161 :::* LISTEN 64443/rpc.statd

[root@nfs ~]#

4)查看本机发布的 NFS 共享目录

[root@nfs ~]# showmount -e

Export list for nfs:

/opt/wwwroot 192.168.182.0/24

[root@nfs ~]#

2.在客户机中访问 NFS 共享资源

NFS 协议的目标是提供一种网络文件系统,因此对 NFS 共享的访问也使用 mount 命令来进行挂载,对应的文件系统类型为 nfs。既可以手动挂载,也可以加入/etc/fstab 配置文件来实现开机自动挂载。考虑到群集系统中的网络稳定性,NFS 服务器与客户机之间最好使用专有网络进行连接。

1)安装 rpcbind 软件包,并启动 rpcbind 服务

若要正常访问 NFS 共享资源,客户机中也需要安装 rpcbind 软件包,并启动 rpcbind 系统服务。另外,为了使用 showmount 查询工具,建议将 nfs-utils 软件包也一并装上。

[root@node01 ~]# yum -y install rpcbind nfs-utils

[root@node01 ~]# systemctl enable rpcbind

[root@node01 ~]# systemctl start rpcbind

如果已经安装了 nfs-utils 软件包,则客户机也可以使用 showmount 查看 NFS 服务器端共享了哪些目录,查询格式为“showmount -e 服务器地址”。

[root@node01 ~]# showmount -e 192.168.182.105

Export list for 192.168.182.105:

/opt/wwwroot 192.168.182.0/24

[root@node01 ~]#

2)下载httpd服务并启动

[root@node01 ~]# yum -y install httpd

[root@node01 ~]# systemctl start httpd

[root@node01 ~]# systemctl enable httpd

Created symlink from /etc/systemd/system/multi-user.target.wants/httpd.service to /usr/lib/systemd/system/httpd.service.

[root@node01 ~]#

3)手动挂载 NFS 共享目录

以 root 用户身份执行 mount 操作,将 NFS 服务器共享的/opt/wwwroot 目录挂载到本地目录/var/www/html。

[root@node01 ~]# mount 192.168.182.105:/opt/wwwroot /var/www/html

[root@node01 ~]# tail -1 /etc/mtab //确认挂载结果

192.168.182.105:/opt/wwwroot /var/www/html nfs4 rw,relatime,vers=4.1,rsize=131072,wsize=131072,namlen=255,hard,proto=tcp,timeo=600,retrans=2,sec=sys,clientaddr=192.168.182.101,local_lock=none,addr=192.168.182.105 0 0

[root@node01 ~]#

[root@node01 ~]# vim /var/www/html/index.html

[root@node01 ~]# cat /var/www/html/index.html

<h1>hello word</h1>

[root@node01 ~]#

完成挂载以后,访问客户机的/var/www/html 文件夹,实际上就相当于访问 NFS 服务器中的/opt/wwwroot 文件夹,其中的网络映射过程对于用户程序来说是透明的。例如,上述操作中创建的 index.html 测试文件,会立刻出现在服务器的/opt/wwwroot/目录下。

4)fstal 自动挂载

修改/etc/fstab 配置文件,加入 NFS 共享目录的挂载设置。注意将文件系统类型设为 nfs,挂载参数建议添加_netdev(设备需要网络)。若添加 soft、intr 参数可以实现软挂载,允许在网络中断时放弃挂载。这样,客户机就可以在每次开机后自动挂载 NFS 共享资源了。

[root@LVS ~]# vim /etc/fstab

[root@LVS ~]# cat /etc/fstab | grep nfs

192.168.182.105:/opt/wwwroot /var/www/html nfs defaults,netdev 0 0

[root@LVS ~]#