租用AutoDL容器

- 注意:结束实验时记得将数据库数据转移存储

使用Docker实现本地IDEA连接AutoDL

- @后为ssh服务器地址

- 用户名为@前的

- 端口号

- ssh密码为用户密码

安装JDK

压缩包安装

Java下载地址:Oracle Java Download(hadoop不指定特定版本java)

解压安装

cd /usr/lib

sudo mkdir jvm #创建/usr/lib/jvm目录用来存放JDK文件

cd ~ #进入hadoop用户的主目录

cd Downloads #注意区分大小写字母,刚才已经通过FTP软件把JDK安装包jdk-8u162-linux-x64.tar.gz上传到该目录下

sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm #把JDK文件解压到/usr/lib/jvm目录下

- 配置环境变量

cd ~

vim ~/.bashrc

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_351 # 自己安装java的位置

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

source ~/.bashrc

- 查看是否生效

java -version

安装Hadoop

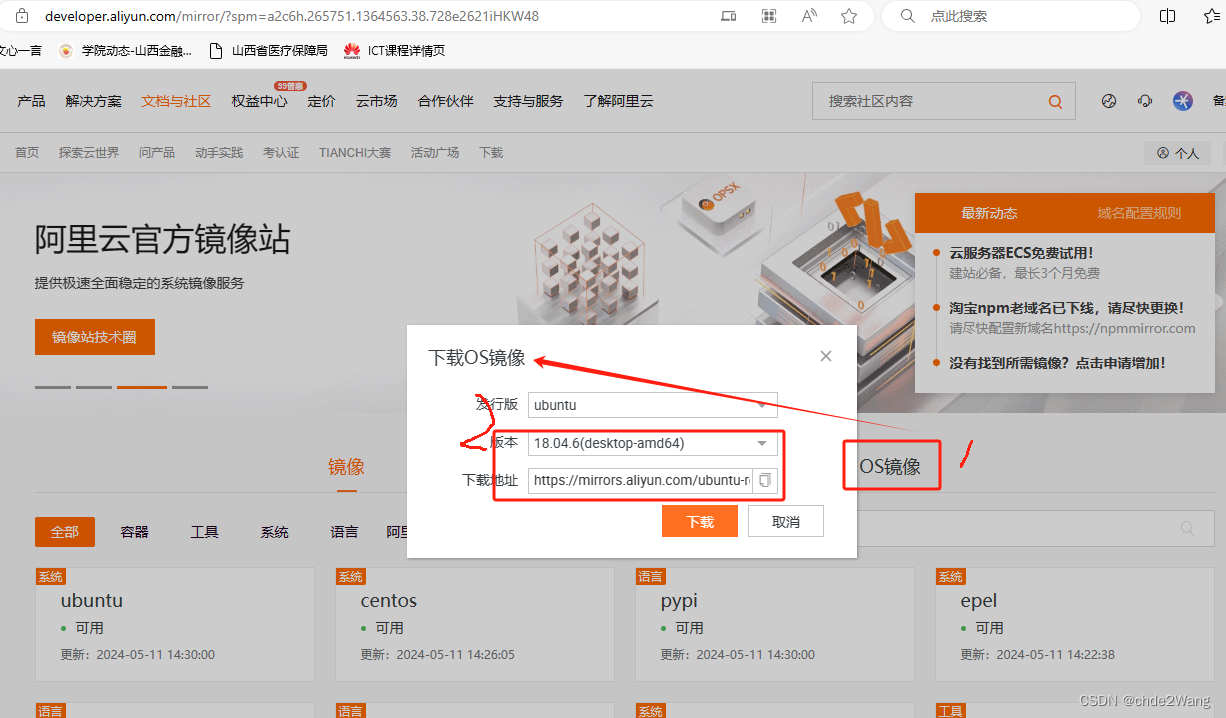

- hadoop下载地址

- 解压安装

sudo tar -zxf ~/下载/hadoop-3.3.4.tar.gz -C /usr/local # 解压到/usr/local中

cd /usr/local/

sudo mv ./hadoop-3.3.4/ ./hadoop # 将文件夹名改为hadoop

# 修改文件权限

sudo chown -R hadoop ./hadoop

sudo chmod -R 777 ./hadoop # 常用这个命令改变权限

- 检查是否可用

cd /usr/local/hadoop

./bin/hadoop version

hadoop伪装分布式

- Hadoop 的配置文件位于 /usr/local/hadoop/etc/hadoop/ 中

- 伪分布式需要修改2个配置文件 core-site.xml 和 hdfs-site.xml

- 修改配置文件 core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

- 修改配置文件 hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

- 配置hadoop环境变量

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

- 在hadoop-env.sh中重新声明JAVA_HOME

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH:$HOME/bin

- 配置完成后,执行 NameNode 的格式化

cd /usr/local/hadoop

./bin/hdfs namenode -format

- 开启 NameNode 和 DataNode 守护进程

cd /usr/local/hadoop

./sbin/start-dfs.sh #start-dfs.sh是个完整的可执行文件,中间没有空格

![[足式机器人]Part3 机构运动学与动力学分析与建模 Ch00-2(1) 质量刚体的在坐标系下运动](https://img-blog.csdnimg.cn/direct/4a14b95a3e3443cc910dfba90c7a1613.png#pic_center)