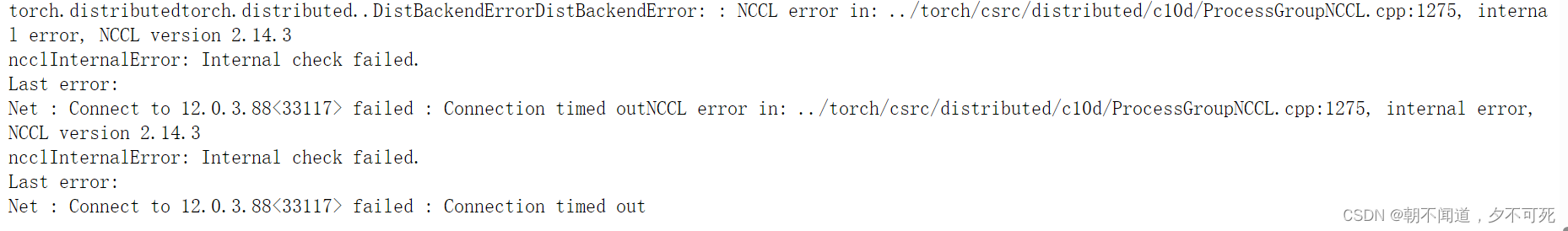

torch.distributedtorch.distributed…DistBackendErrorDistBackendError: : NCCL error in: …/torch/csrc/distributed/c10d/ProcessGroupNCCL.cpp:1275, internal error, NCCL version 2.14.3

这个不知道什么原因,然后解决方法是

增加环境变量NCCL_SOCKET_IFNAME=eth2

torch.distributedtorch.distributed…DistBackendErrorDistBackendError: : NCCL error in: …/torch/csrc/distributed/c10d/ProcessGroupNCCL.cpp:1275, internal error, NCCL version 2.14.3

这个不知道什么原因,然后解决方法是

增加环境变量NCCL_SOCKET_IFNAME=eth2