内容概要:

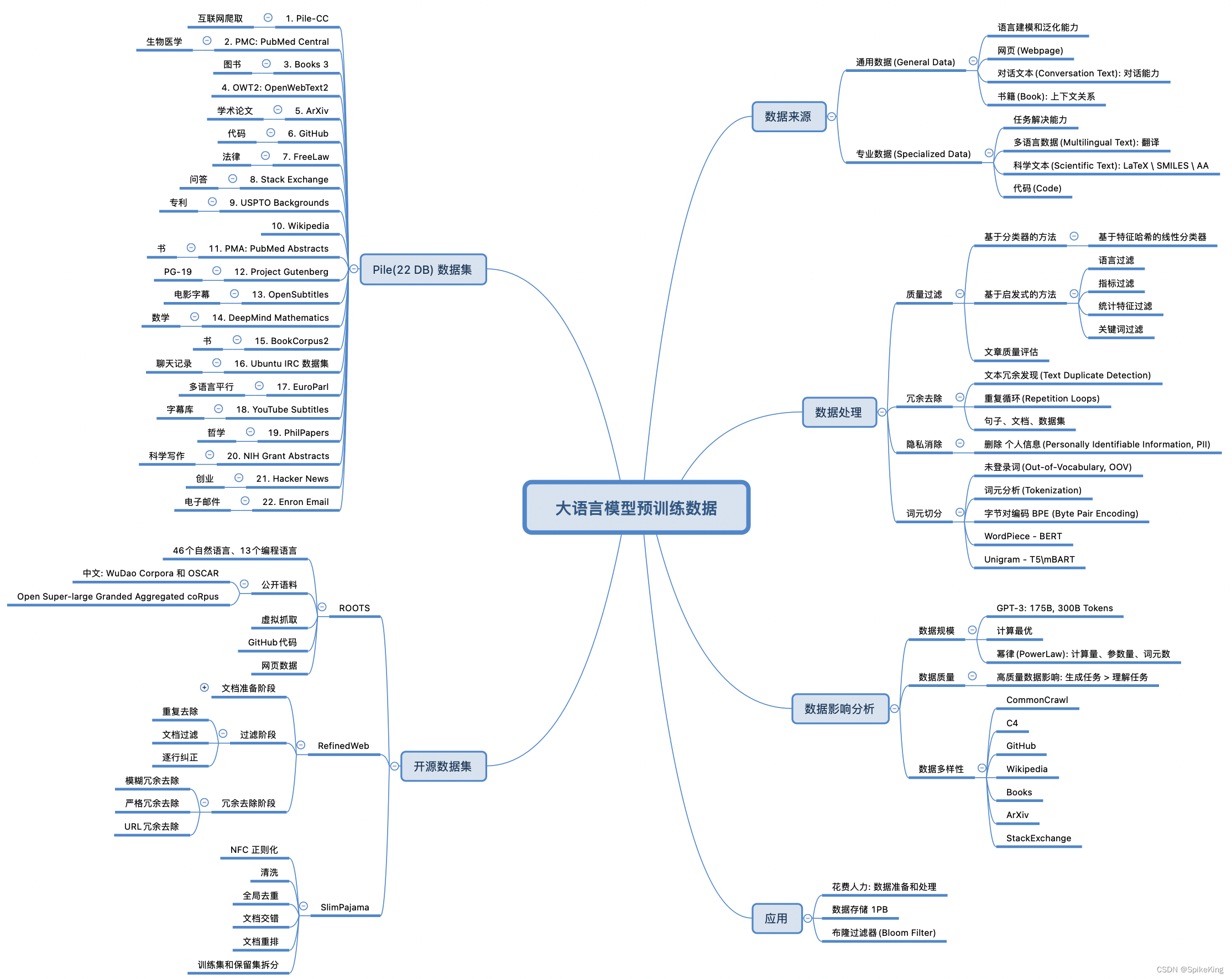

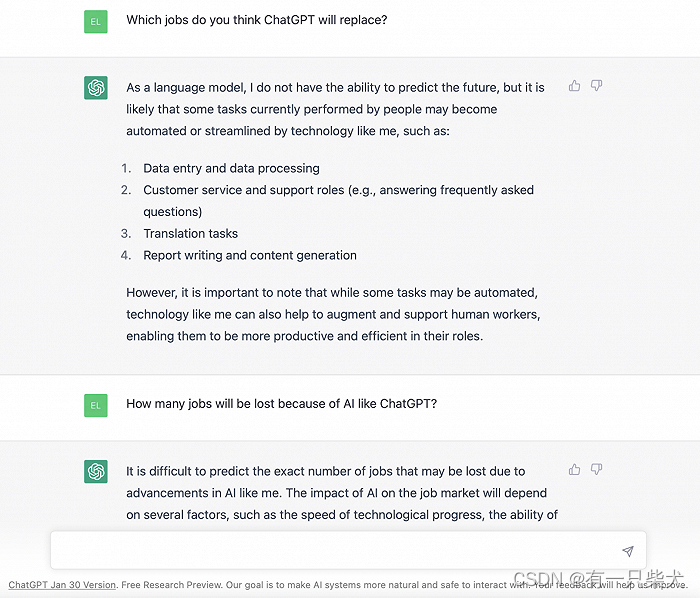

安全研究人员发现,黑客可利用新的数据提取攻击方法从当今主流的大语言模型(包括开源和封闭,对齐和未对齐模型)中大规模提取训练数据。当前绝大多数大语言模型的记忆(训练数据)可被恢复,无论该模型是否进行了所谓的“对齐”。黑客可以通过查询模型来有效提取训练数据,甚至无需事先了解训练数据集。

安全研究者展示了如何从Pythia或GPT-Neo等开源语言模型、LLaMA或Falcon等主流半开放模型以及ChatGPT等封闭模型中提取数以GB计的训练数据。

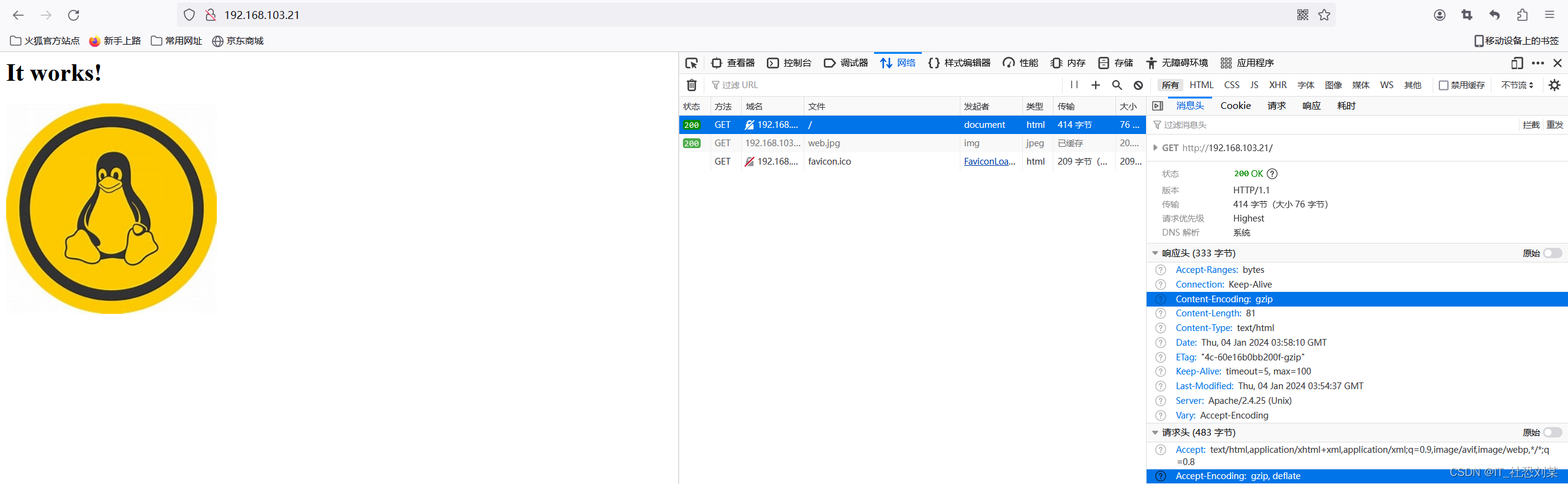

相关研究展现,已有技术足以攻击未对齐的模型,对于已经对齐的ChatGPT,安全研究者开发了一种新的发散数据提取攻击,该攻击会导致大语言模型改变聊天机器人的内容生成方式,以比正常行为高150倍的速率疯狂输出训练数据。

渗透测试结果表明现有的大语言模型安全措施(模型对齐和内容记忆测试)难以发现大语言模型的隐私漏洞,更不用说那些隐藏在模型算法代码中的“休眠漏洞”。如果没有极端的安全措施,现阶段不应训练和部署涉及隐私和敏感信息的大模型应用。

研判认为:

我方应高度关注此事,大语言模型应用于社会的方方面面,不仅可以在文本生成中看到它的身影,还有智能客服、知识问答、文本校对等一些列的智能化产品。对此我方建议相关部门应制定有效政策引导相关企业对大模型应用项目有正确的发展方向。