1. 代码及解读

in_f = open('data.csv')

lines = in_f.readlines()

in_f.close()

dataset = [(line.strip()[:-3], line.strip()[-2:]) for line in lines]

print(dataset[:5])

[('1 december wereld aids dag voorlichting in zuidafrika over bieten taboes en optimisme',

'nl'),

('1 mill贸n de afectados ante las inundaciones en sri lanka unicef est谩 distribuyendo ayuda de emergencia srilanka',

'es'),

('1 mill贸n de fans en facebook antes del 14 de febrero y paty miki dani y berta se tiran en paraca铆das qu茅 har铆as t煤 porunmillondefans',

'es'),

('1 satellite galileo sottoposto ai test presso lesaestec nl galileo navigation space in inglese',

'it'),

('10 der welt sind bei', 'de')]

from sklearn.model_selection import train_test_split

x, y = zip(*dataset)

# 划分训练集、测试集

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=1)

# 训练集样本数

len(x_train) # 6799

import re

def remove_noise(document):

noise_pattern = re.compile("|".join(["http\S+", "\@\w+", "\#\w+"]))

clean_text = re.sub(noise_pattern, "", document)

return clean_text.strip()

remove_noise("Trump images are now more popular than cat gifs. @trump #trends http://www.trumptrends.html")

# 'Trump images are now more popular than cat gifs.'

from sklearn.feature_extraction.text import CountVectorizer

# from sklearn.feature_extraction.text import TfidfVectorizer

vec = CountVectorizer(

lowercase=True, # 英文文本全小写

analyzer='char_wb', # 逐个字母解析

ngram_range=(1,3), # 1=出现的字母以及每个字母出现的次数,2=出现的连续2个字母,和连续2个字母出现的频次

# trump images are now... => 1gram = t,r,u,m,p... 2gram = tr,ru,um,mp...

max_features=1000, # keep the most common 1000 ngrams

preprocessor=remove_noise

)

# vec = TfidfVectorizer(lowercase=True, decode_error='ignore', preprocessor=remove_noise)

vec.fit(x_train)

def get_features(x):

vec.transform(x)

这段代码的目的是使用CountVectorizer类从sklearn.feature_extraction.text模块来转换文本数据为数值向量,这是在文本挖掘和自然语言处理中常见的第一步。向量化是将文本数据转换成数值数据,以便机器学习模型可以处理。以下是代码详细的步骤解释:

导入

CountVectorizer:from sklearn.feature_extraction.text import CountVectorizer这一步导入了

CountVectorizer类,它可以将文本集合转换成词频矩阵。设置

CountVectorizer的参数:vec = CountVectorizer( lowercase=True, # 将文本转换为小写,这有助于统一不同大小写的相同单词 analyzer='char_wb', # 以字符为单位进行分析,'char_wb'表示在单词边界内分析字符,这有助于捕获字符在单词内部的位置信息 ngram_range=(1,3), # 设置n-gram的范围,从1到3,这意味着它会考虑单独的字符、两个连续字符、三个连续字符的组合 max_features=1000, # 只保留最常见的1000个n-grams,这有助于降低模型复杂度和避免过拟合 preprocessor=remove_noise # 使用`remove_noise`函数作为预处理器,它会在向量化前清理文本数据 )这里设置了

CountVectorizer的几个关键参数,包括:- 文本小写化。

- 字符分析器,会考虑字符在单词边界内的n-gram。

- n-gram的范围设置为1到3。

- 仅保留最常见的1000个n-grams。

- 使用预先定义的

remove_noise函数来清理文本数据。

训练

CountVectorizer:vec.fit(x_train)这一步是在训练集

x_train上“训练”CountVectorizer,即建立一个词汇表,并计算n-gram的频率。定义一个获取特征的函数:

def get_features(x): vec.transform(x)这个

get_features函数用于将新的文本数据x转换为先前fit方法计算得到的词汇表对应的向量。这里的transform调用会将文本转换成稀疏的数值向量,这些向量的每一维代表一个n-gram的频率。

代码中注释掉的部分是TfidfVectorizer的导入和设置,这表明原作者可能在选择使用基本的词频方法(即CountVectorizer)与使用词频-逆文档频率(TF-IDF)方法(即TfidfVectorizer)之间进行权衡。TfidfVectorizer通常用于当词的重要性不能仅由频率决定时,它考虑了词在整个数据集中的分布。

2. 知识点

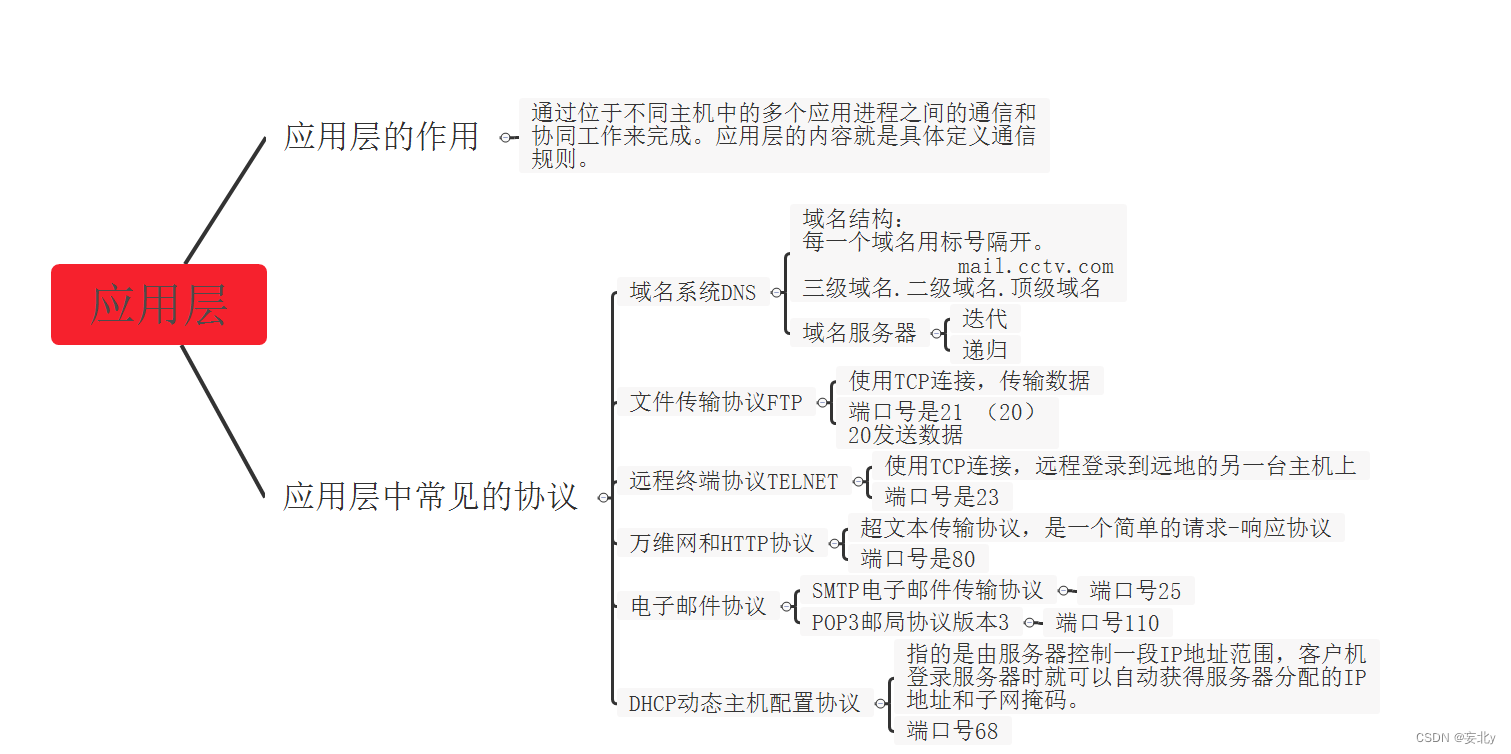

n-grams

当然,让我们通过一个简单的例子来理解n-grams。

假设我们有这样一个句子:

"I love to eat apples"

在这个句子中,我们可以生成不同的n-grams:

1-grams (或 unigrams):

- “I”

- “love”

- “to”

- “eat”

- “apples”

Unigrams是句子中的单个单词。

2-grams (或 bigrams):

- “I love”

- “love to”

- “to eat”

- “eat apples”

Bigrams是句子中相邻的两个单词对。

3-grams (或 trigrams):

- “I love to”

- “love to eat”

- “to eat apples”

Trigrams是句子中相邻的三个单词对。

每当n增加,n-gram就会包含更多的单词。通常,随着n的增加,n-gram能提供更多的上下文信息,但同时它们的出现频率可能会下降,因为更长的词序列在文本中准确出现的次数通常会更少。

在自然语言处理中,n-grams用于建立语言模型,这些模型可以预测下一个单词(在n-1个单词的上下文中),或者用于特征工程,比如在文本分类任务中。不过,要注意,随着n的增加,可能会遇到“维度灾难”,因为可能的n-gram组合的数量会呈指数增长。

仅保留最常见的1000个n-grams。意思是n=1000 ?

不是的。在这个上下文中,“保留最常见的1000个n-grams”并不意味着n=1000。这里的n指的是n-gram中的n,即组成n-gram的单词数量。比如,n=1时是unigrams(单词),n=2时是bigrams(两个单词的组合),n=3时是trigrams(三个单词的组合),以此类推。

“保留最常见的1000个n-grams”是指在对文本进行n-gram分析之后,只保留出现频率最高的1000个n-gram组合。这些n-grams可以是任何长度的(在指定的ngram_range内),而不是指n-gram的长度为1000个单词。例如,如果ngram_range设置为(1,3),那么这1000个n-grams可以包含unigrams、bigrams、trigrams的任意组合,具体取决于它们在文本中出现的频率。

这样做的目的是为了减少特征的数量,这有助于提高模型训练的效率和可能的泛化能力,同时也减少了由于过于稀有的n-grams可能导致的过拟合问题。