xinference

Xorbits Inference(xinference)是一个性能强大且功能全面的分布式推理框架。可用于大语言模型(LLM),语音识别模型,多模态模型等各种模型的推理。通过 Xorbits Inference,你可以轻松地一键部署你自己的模型或内置的前沿开源模型。无论你是研究者,开发者,或是数据科学家,都可以通过 Xorbits Inference 与最前沿的 AI 模型,发掘更多可能。

xinference 内置了多个大语言模型,可以让用户轻松的使用这些模型,包括 CPU(穷人福音)和 GPU 版本。以 chatglm3 为例,以下代码可以运行一个跑在 CPU 上的模型。

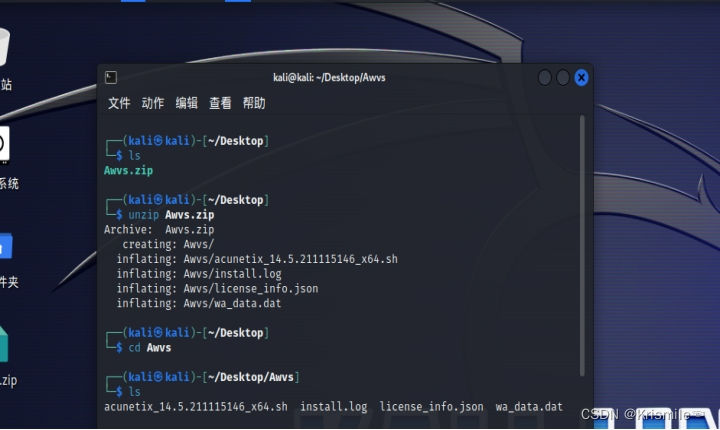

# 使用hugging-face镜像, 能够翻墙的同学可以忽略

export HF_ENDPOINT=https://hf-mirror.com

# 创建python虚拟环境

conda create -n xinference python=3.10

# 安装ggml 让模型可以运行在CPU上

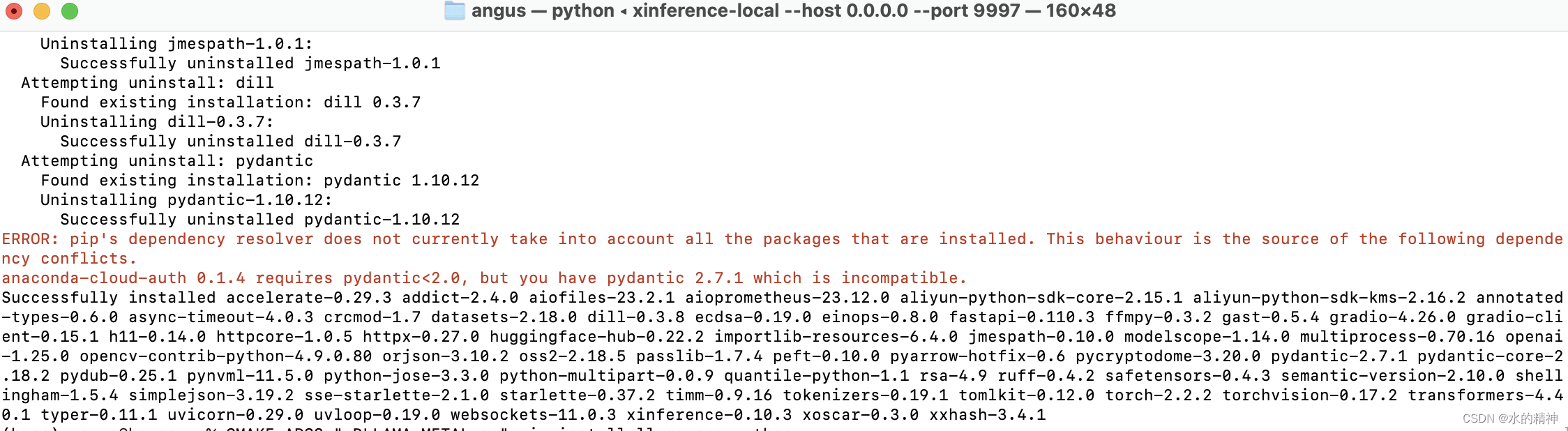

pip install xinference[ggml]>=0.4.3

# 启动xinference, 访问http://127.0.0.1:9997就可以运行不同的模型了

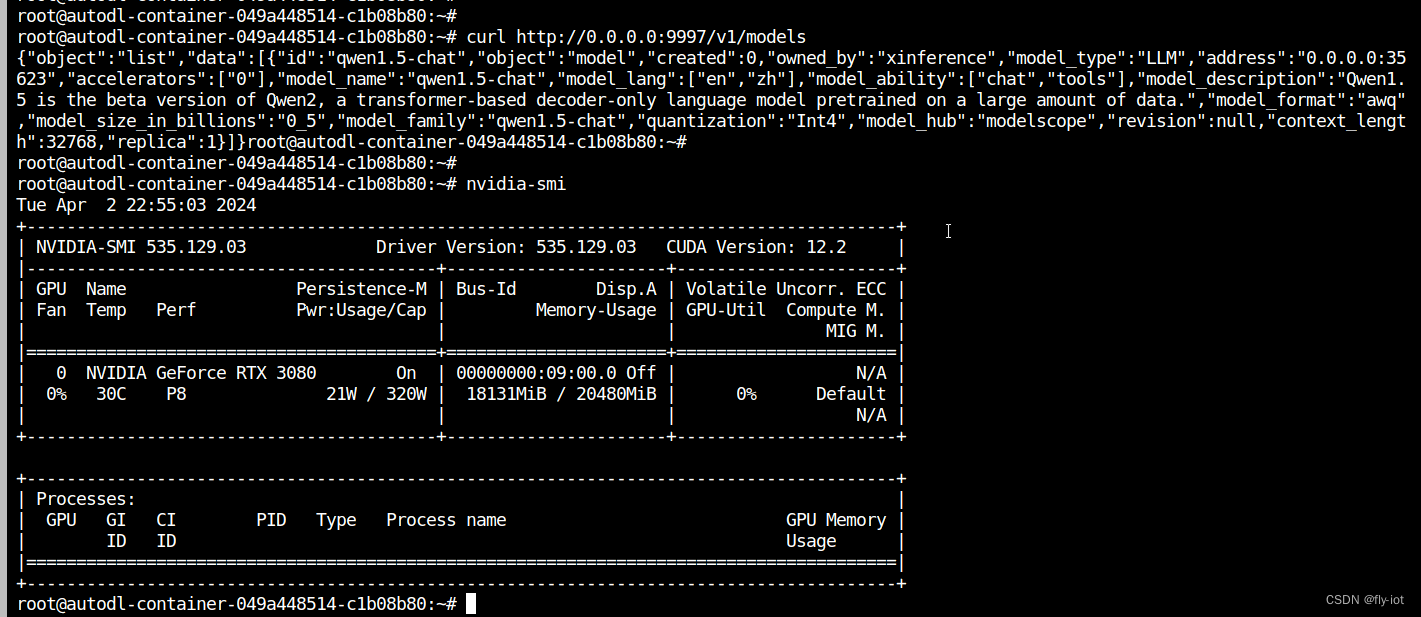

xinference -p 9997

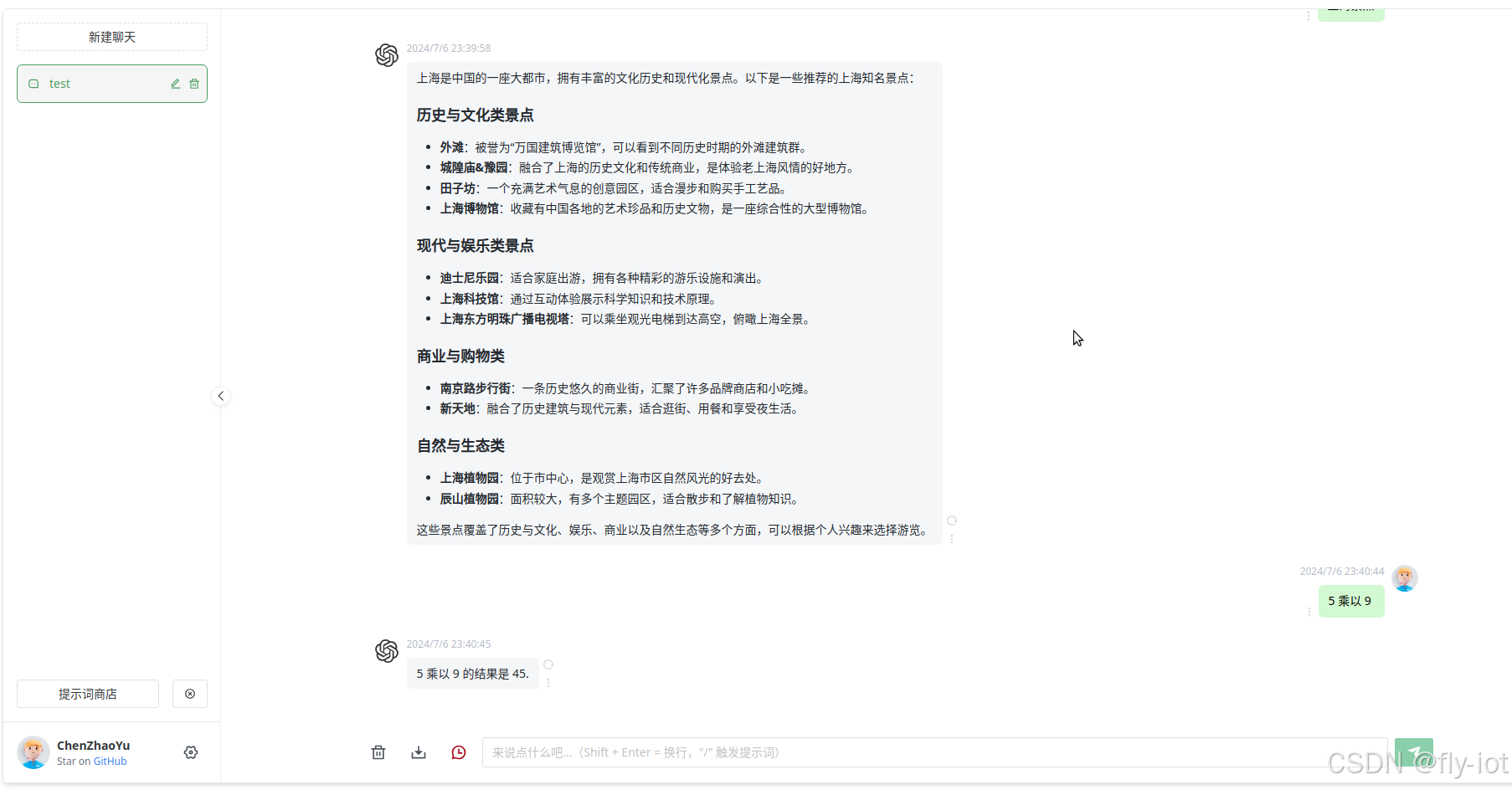

启动模型后使用 python 代码调用

from xinference.client import Client

client = Client("http://localhost:9997")

model_uid = client.launch_model(

model_name="chatglm3",

model_format="ggmlv3",

model_size_in_billions=6,

quantization="q4_0",

)

model = client.get_model(model_uid)

chat_history = []

prompt = "最大的动物是什么?"

model.chat(

prompt,

chat_history,

generate_config={

"max_tokens": 1024}

)