前言:

今天我们来聊一聊Scrapy爬虫中的请求处理与返回策略。你有没有遇到过一个Item需要由多个请求组成的情况?如果是的话,那么对请求的处理和决定是否返回处理过的Item对象就变得格外重要。看一下Scrapy中的相关策略,实现爬虫的`完美康复`。

正文:

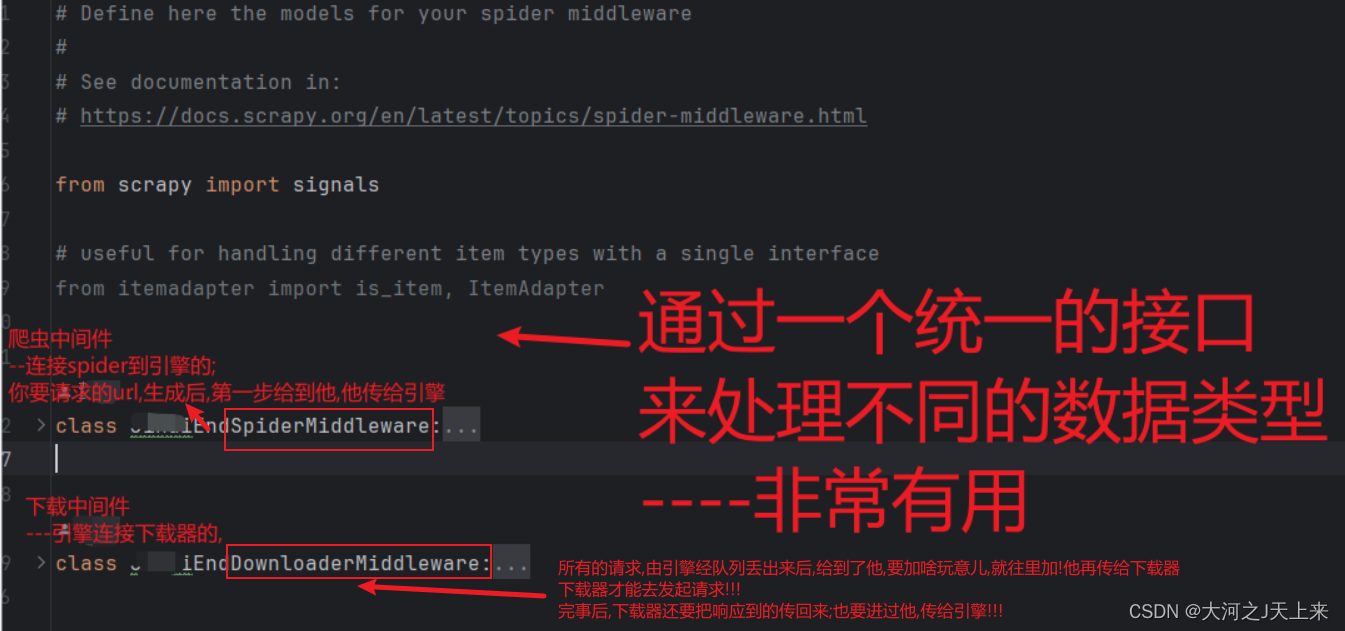

请求处理流程:

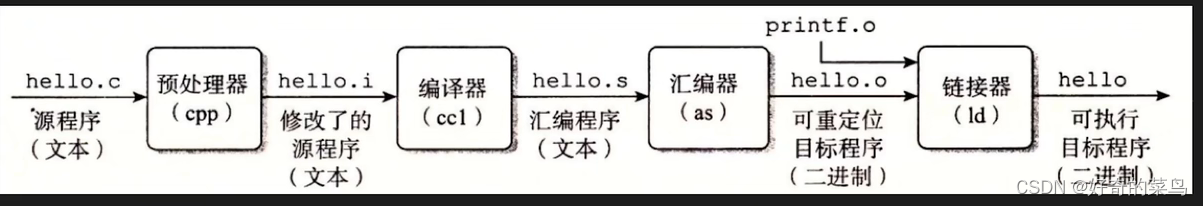

- 发起请求:使用Scrapy的调度器或代码发起网络请求。

- 下载页面:Scrapy将请求发送给下载器,获取页面的响应。

- 回调方法:根据请求的设置,Scrapy将返回的响应传递给合适的回调方法。

- 数据处理:在对应的回调方法中,解析页面并提取所需的数据。

- Item返回:根据实际需求,决定是否返回填充了数据的Item对象。

多请求组装Item:

- 场景描述:我们经常会遇到需要多个HTML请求才能组装出完整Item的情况。

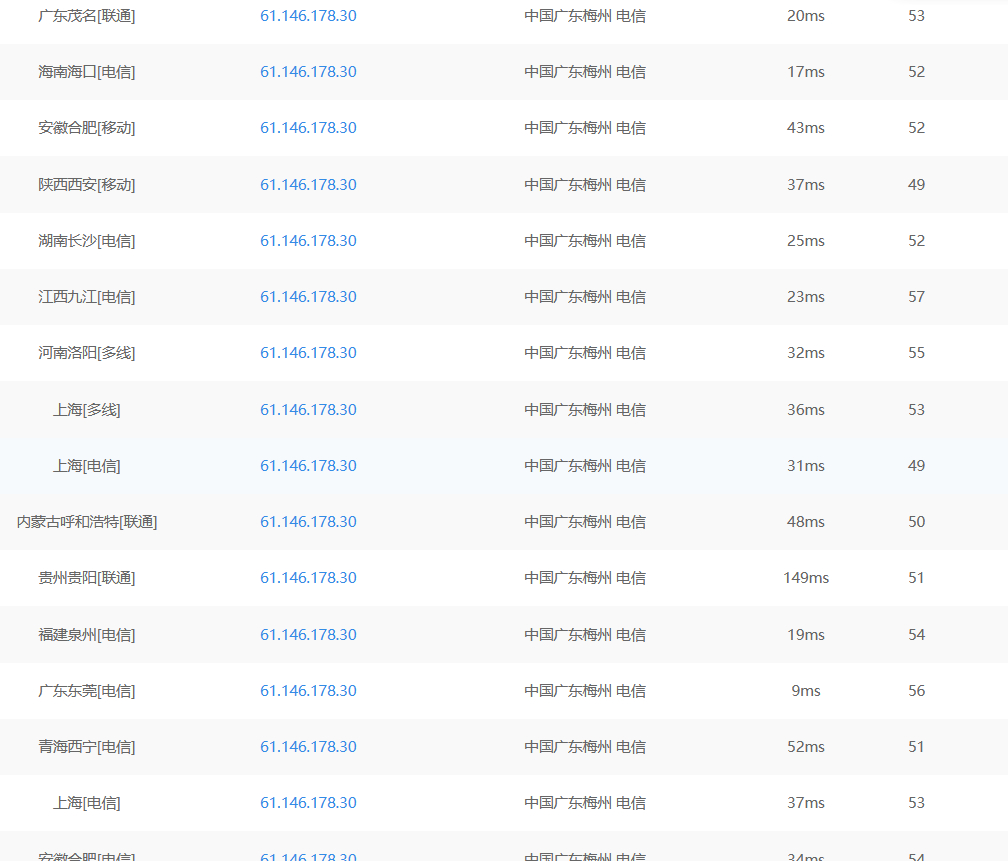

- 请求超时处理:为了稳定性,合理设置请求的超时时间。你可以使用DOWNLOAD_TIMEOUT参数或在请求的meta中设置download_timeout字段。

- 异常处理:在回调方法中,针对请求发生的异常进行处理。要根据具体情况,判断是否成功获取了所需的数据。如超时、状态码、数据为空等情况。

- Item填充与返回:根据需要,设置合适的逻辑来决定是否返回处理过的Item对象。如果Item的字段完整且有效,那么值得返回;否则,可以选择其他处理方式。

请求处理与异常处理:

- 请求处理:在中间件的process_response方法中,我们可以对请求进行处理。根据响应的有效性进行判断和处理,如移除无效的代理IP、设置重试次数等。

- 异常处理:在中间件的process_exception方法中,我们可以处理请求发生的异常。可以对相关的代理IP进行清理、记录日志、重新发送请求等。需要根据不同的异常类型进行相应的处理。

返回处理与决策:

- 返回处理:在回调方法中,我们可以进行返回处理。根据需求,决定是否返回处理过的Item对象,并在处理过程中判断和处理Item的数据。

- 判断条件:我们可以根据字段的有效性、是否为空、类型等进行判断。如果需要返回完整的Item对象,请确保所有字段都被正确填充。

- 失败请求处理:如果请求失败且不需要返回处理过的Item对象,可以进行其他相关处理,如记录日志、抛出异常等。

案例: (理解请求处理和返回策略)

import scrapy

class MySpider(scrapy.Spider):

name = "example"

def start_requests(self):

urls = [

'http://www.example.com/page1',

'http://www.example.com/page2',

'http://www.example.com/page3',

'http://www.example.com/page4',

'http://www.example.com/page5',

]

for url in urls:

yield scrapy.Request(url=url, callback=self.parse, meta={'download_timeout': 3})

def parse(self, response):

# 解析HTML内容,提取数据

data = response.css('.my-class::text').get()

# 创建Item对象

item = {}

item['data'] = data

# 判断是否获取到了完整的Item数据

if item['data']:

yield item

else:

self.logger.warning('Incomplete item: missing data')

# 判断是否所有请求都已处理完毕

if all(response.request.url.endswith(str(i)) for i in range(1, 6)):

self.logger.info('All requests processed')