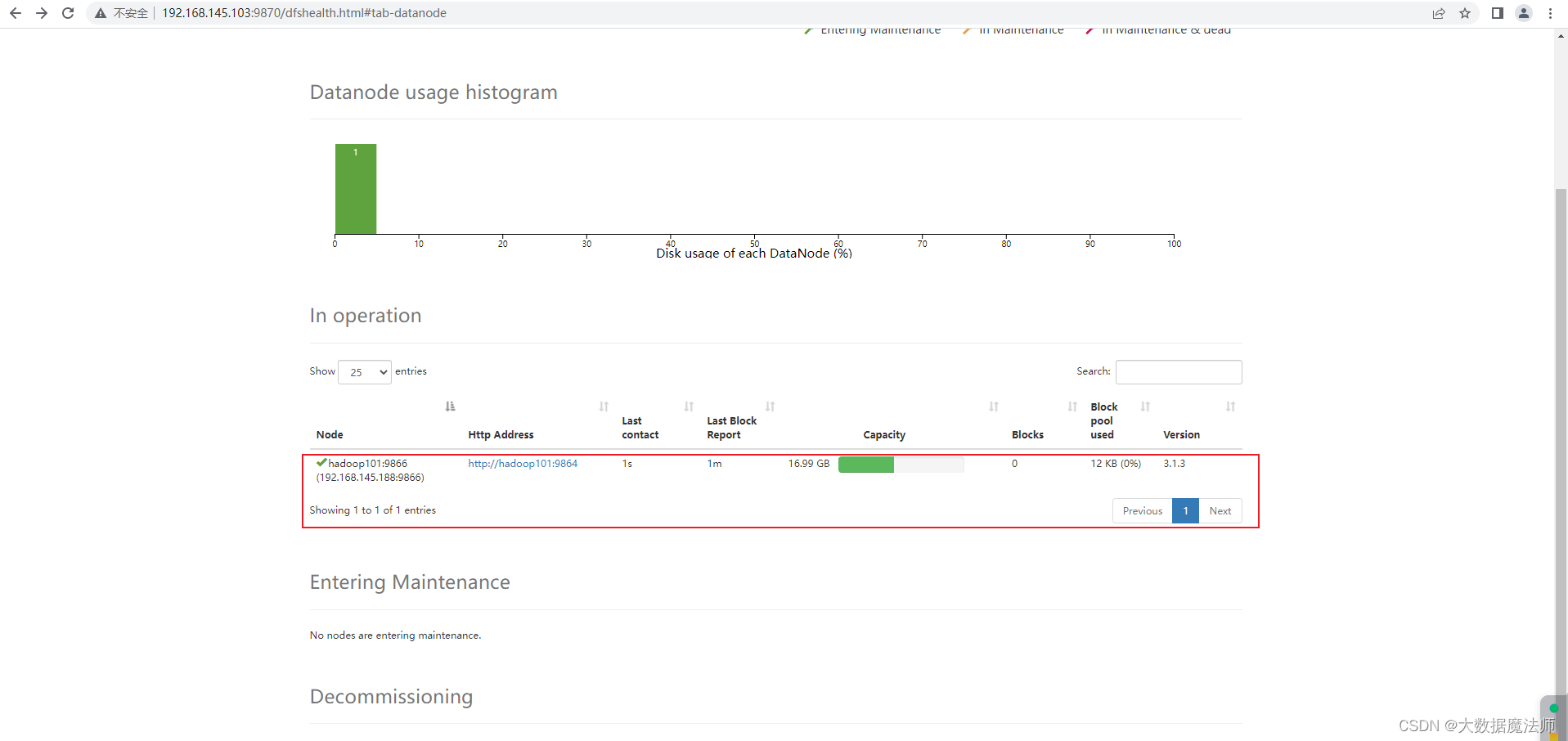

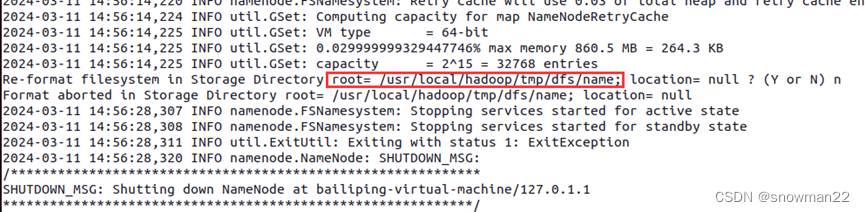

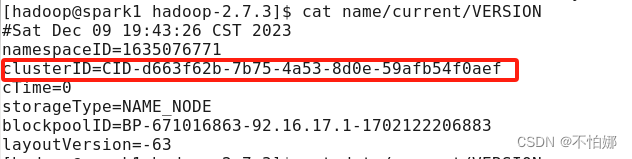

执行start-dfs.sh后,datenode没有启动,很大一部分原因是因为在第一次格式化dfs后又重新执行了格式化命令(hdfs namenode -format),这时主节点namenode的clusterID会重新生成,而从节点datanode的clusterID 保持不变。

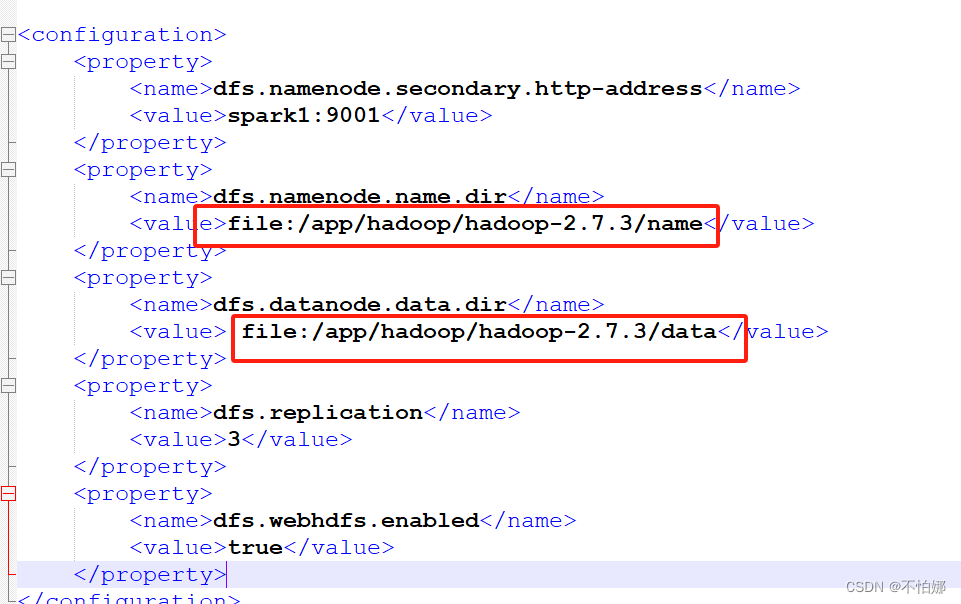

在主节点也就是namenode那个节点上的hdfs-site.xml文件下找到这两个文件路径

打开name目录中current下面的VERSION文件,然后用这个clusterID替换掉datanode节点上的data/current/VERSION里的clusterID

![[最新]CentOS7设置开机自<span style='color:red;'>启动</span><span style='color:red;'>Hadoop</span><span style='color:red;'>集</span><span style='color:red;'>群</span>](https://img-blog.csdnimg.cn/20200809120111313.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3FxXzQ0NDkxNzA5,size_16,color_FFFFFF,t_70)