torch.matmul

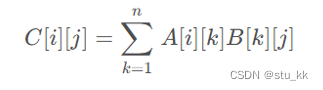

torch.matmul是PyTorch中执行一般矩阵乘法的函数,它接受两个矩阵作为输入,并返回它们的乘积。它适用于任何两个矩阵,无论是密集矩阵还是稀疏矩阵。

import torch

# 创建两个 2x2 矩阵

mat1 = torch.tensor([[1, 2], [3, 4]])

mat2 = torch.tensor([[5, 6], [7, 8]])

# 使用torch.matmul进行矩阵乘法

result = torch.matmul(mat1, mat2)

print(result)

torch.mm

torch.mm是PyTorch中用于密集矩阵乘法的函数。它接受两个密集矩阵作为输入,并返回它们的乘积。与torch.matmul相比,torch.mm在处理密集矩阵时具有更高的性能和更简单的语法。

import torch

# 创建两个 2x2 矩阵

mat1 = torch.Tensor([[1, 2], [3, 4]])

mat2 = torch.Tensor([[5, 6], [7, 8]])

# 使用torch.mm进行矩阵乘法

result = torch.mm(mat1, mat2)

print(result)

torch.spmm

torch.spmm是PyTorch中用于稀疏矩阵乘法的函数。它接受两个稀疏矩阵作为输入,并返回它们的乘积。与torch.matmul和torch.mm相比,torch.spmm更适用于处理包含大量零值元素的矩阵,因为它可以有效地处理稀疏结构并减少计算量。

import torch

import torch.sparse_coo_tensor as coo_tensor

# 创建两个稀疏矩阵

row_0 = [0, 1, 2]

col_0 = [0, 2, 1]

value_0 = [1, 2, 3]

sparse_mat1 = coo_tensor.from_sparse((torch.tensor(row_0), torch.tensor(col_0), torch.tensor(value_0)))

row_1 = [0, 2, 3]

col_1 = [1, 0, 2]

value_1 = [4, 5, 6]

sparse_mat2 = coo_tensor.from_sparse((torch.tensor(row_1), torch.tensor(col_1), torch.tensor(value_1)))

# 使用torch.spmm进行矩阵乘法

result = torch.spmm(sparse_mat1, sparse_mat2)

print(result)

![[英语学习][3][Word Power Made Easy]的精读与翻译优化](https://img-blog.csdnimg.cn/41847e348d994568a735902656c981be.jpeg)