本地大模型:把各大厂(如Meta,阿里)开源的模型放到自己的电脑上去运行,不需要联网,不需要收费,隐私也不会泄露

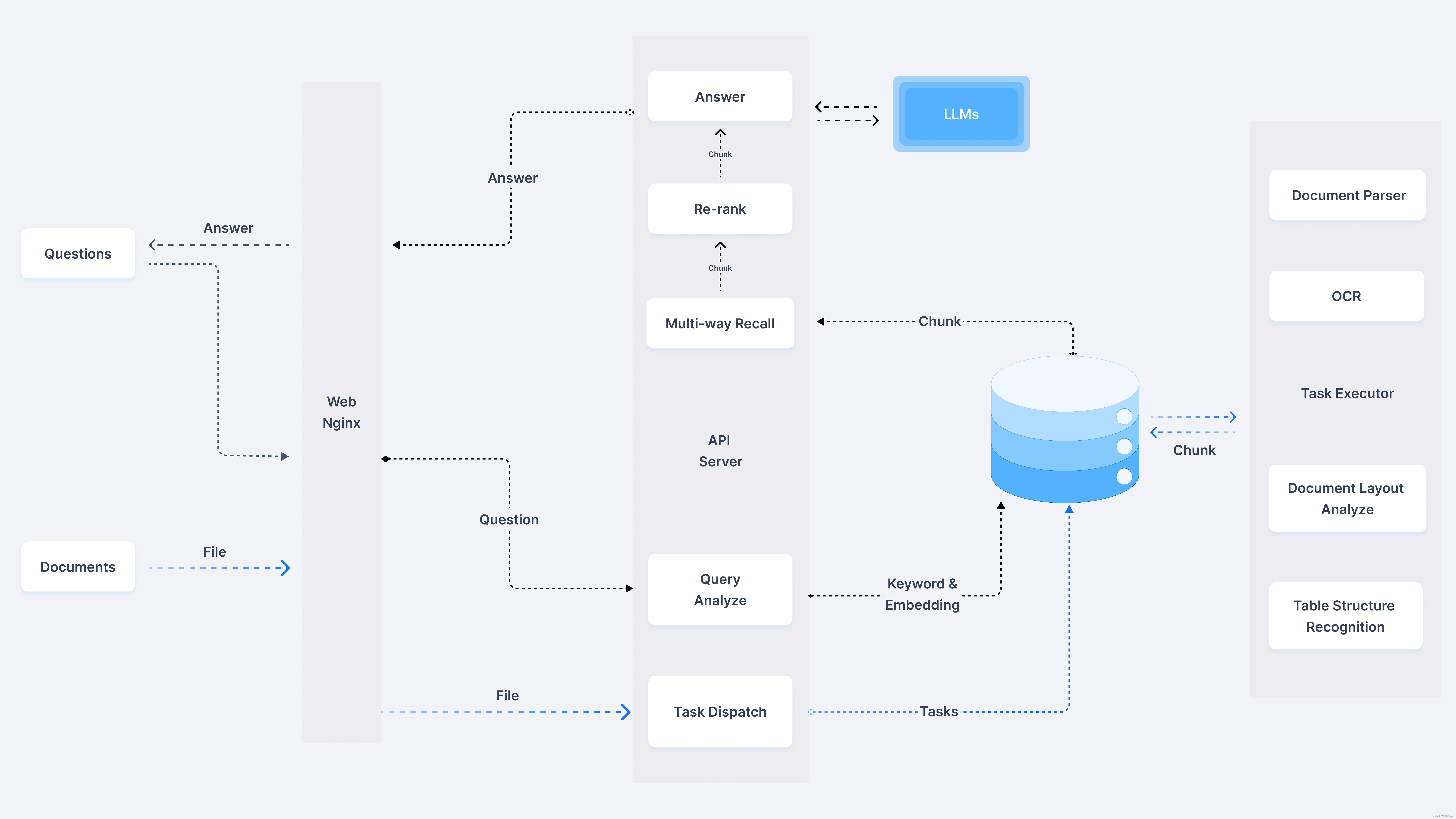

知识库:给大模型开卷考试,每次回答问题之前去知识库里查答案,根据查出来的事实回答你

1、部署本地大模型

1.1 Ollama官网下载

Ollama官网 (https://ollama.com/)下载

安装好后,在任务栏或[运行],或直接win+R,输入cmd,打开命令提示符

输入:ollama run 模型名(qwen2/llama3等等)

看到对话界面即可

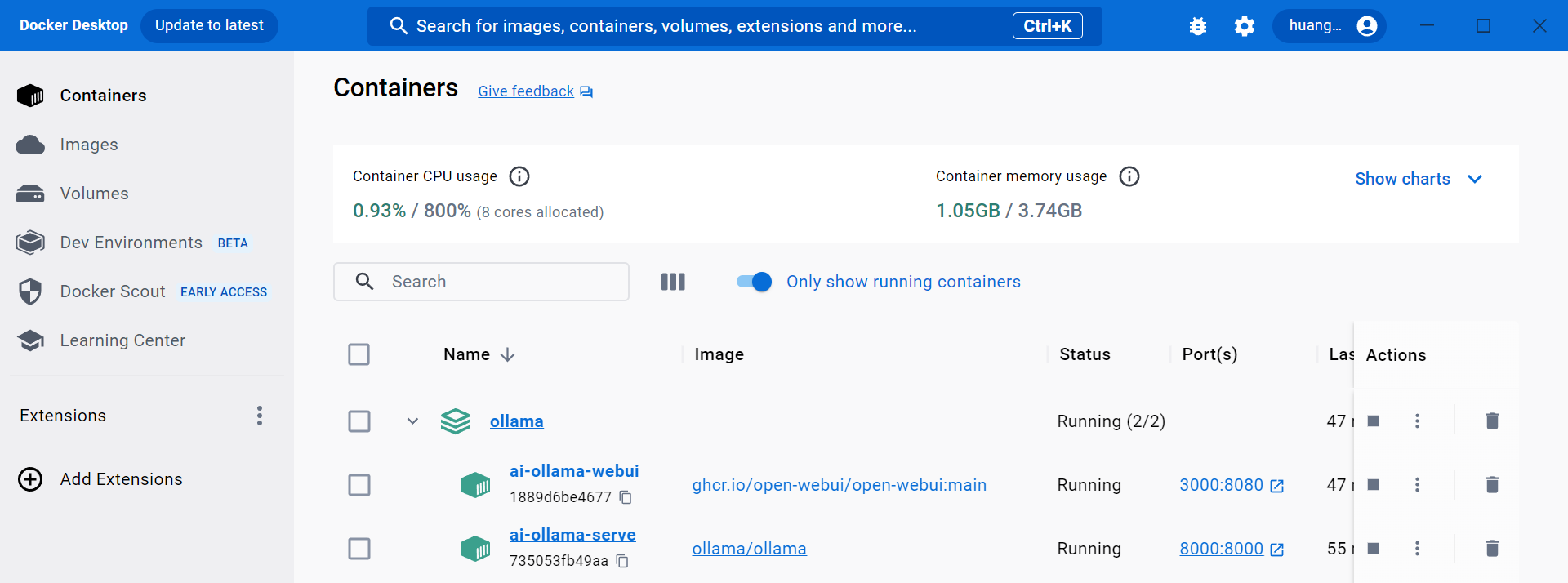

换成后台服务模式(知识库调用),输入Ollama server,

1.2 知识库anything LLM

开源本地知识库工具

1.2.1 安装anything LLM

可以直接在它的界面里面对话,也可以把知识库和大模型做成API,在企业应用里调用。</

![World of Warcraft [CLASSIC] Dalaran](https://i-blog.csdnimg.cn/direct/1c24f09e45d945dc9ff6a990414d9b3d.png)

![算法:[递归/搜索/回溯]递归](https://i-blog.csdnimg.cn/direct/c4e2467876704dbaad2d31d10906e868.png)