- 去官网下载安装 Ollama ,然后运行, windows和mac只要右下角或者标题栏有图标即可。

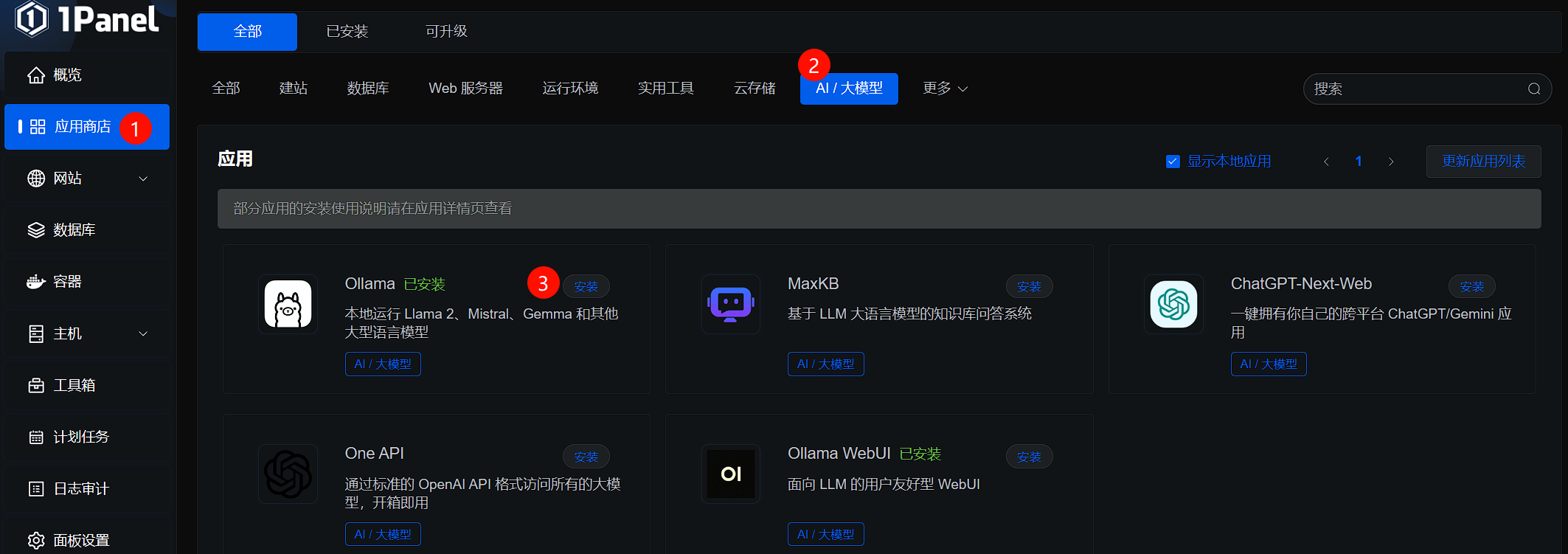

- 安装ollama-gui

用python安装:

python -m pip install ollama_gui

python -m ollama_gui

或者没有python可以下载安装:

https://github.com/chyok/ollama-gui/releases/tag/v1.2.0

3.打开上面的GUI程序, 选择想部署在本地的模型:library模型列表 ,如qwen2:0.5b, ,进入模型管理,输入qwen2:0.5b,点击download:

4.开始对话

参考自

https://zhuanlan.zhihu.com/p/706279041