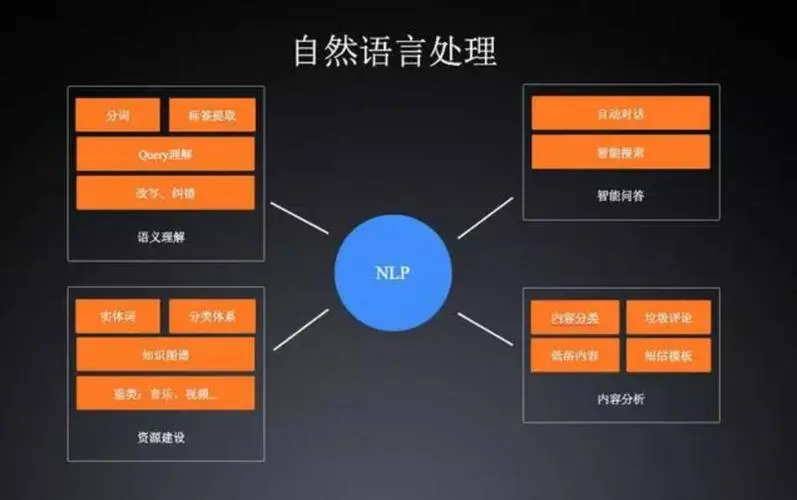

在自然语言处理中,注意力模型(Attention Model)被广泛应用以聚焦于输入序列的不同部分。

以基于 Transformer 的自然语言处理模型为例,注意力机制允许模型在处理每个位置时动态地为输入序列的不同位置分配权重,从而捕捉长距离的依赖关系和重要信息。

以下是一个简单的示例,展示如何在 Python 中使用 torch 库实现一个简单的注意力机制:

import torch

def scaled_dot_product_attention(q, k, v, d_k):

# 计算得分

scores = torch.bmm(q, k.transpose(1, 2)) / torch.sqrt(d_k)

# 应用 Softmax 进行归一化

attn_weights = torch.nn.Softmax(dim=-1)(scores)

# 计算注意力输出

attn_output = torch.bmm(attn_weights, v)

return attn_output

# 示例输入

q = torch.randn(1, 5, 16) # 查询向量

k = torch.randn(5, 5, 16) # 键向量

v = torch.randn(5, 16, 32) # 值向量

d_k = 16 # 键的维度

attn_output = scaled_dot_product_attention(q, k, v, d_k)

print(attn_output.shape)

![[AIGC] Doris:一款高效的MPP数据仓库引擎](https://i-blog.csdnimg.cn/direct/b933b43756e24a1283807fa1288ad880.png)