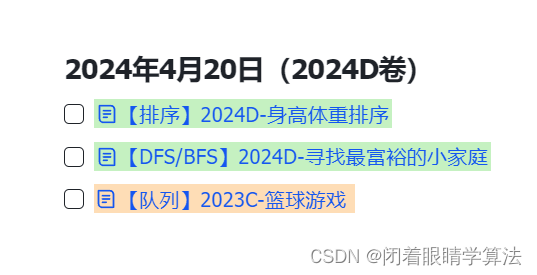

文章目录~

- 1.AnyTaskTune: Advanced Domain-Specific Solutions through Task-Fine-Tuning

- 2.Lookback Lens: Detecting and Mitigating Contextual Hallucinations in Large Language Models Using Only Attention Maps

- 3.Metron: Holistic Performance Evaluation Framework for LLM Inference Systems

- 4.Segment-Based Interactive Machine Translation for Pre-trained Models

- 5.Divine LLaMAs: Bias, Stereotypes, Stigmatization, and Emotion Representation of Religion in Large Language Models

- 6.Richelieu: Self-Evolving LLM-Based Agents for AI Diplomacy

- 7.Using Pretrained Large Language Model with Prompt Engineering to Answer Biomedical Questions

- 8.FinCon: A Synthesized LLM Multi-Agent System with Conceptual Verbal Reinforcement for Enhanced Financial Decision Making

- 9.Combining Knowledge Graphs and Large Language Models

- 10.LETS-C: Leveraging Language Embedding for Time Series Classification

- 11.Towards Understanding Multi-Task Learning (Generalization) of LLMs via Detecting and Exploring Task-Specific Neurons

- 12.A Single Transformer for Scalable Vision-Language Modeling

- 13.Using Grammar Masking to Ensure Syntactic Validity in LLM-based Modeling Tasks

- 14.Artificial Intuition: Efficient Classification of Scientific Abstracts

- 15.LLaMAX: Scaling Linguistic Horizons of LLM by Enhancing Translation Capabilities Beyond 100 Languages

- 16.Is GPT-4 Alone Sufficient for Automated Essay Scoring?: A Comparative Judgment Approach Based on Rater Cognition

- 17.Open-world Multi-label Text Classification with Extremely Weak Supervision

- 18.Faux Polyglot: A Study on Information Disparity in Multilingual Large Language Models

- 19.Enhancing Computer Programming Education with LLMs: A Study on Effective Prompt Engineering for Python Code Generation

- 20.LTLBench: Towards Benchmarks for Evaluating Temporal Logic Reasoning in Large Language Models

- 21.A Study of Test-time Contrastive Concepts for Open-world, Open-vocabulary Semantic Segmentation

- 22.How do you know that? Teaching Generative Language Models to Reference Answers to Biomedical Questions

- 23.EVA-Score: Evaluation of Long-form Summarization on Informativeness through Extraction and Validation

- 24.MMSci: A Multimodal Multi-Discipline Dataset for PhD-Level Scientific Comprehension

- 25.Towards Enhancing Coherence in Extractive Summarization: Dataset and Experiments with LLMs

- 26.Entity Decomposition with Filtering: A Zero-Shot Clinical Named Entity Recognition Framework

- 27.Using LLMs to label medical papers according to the CIViC evidence model

- 28.MAPO: Boosting Large Language Model Performance with Model-Adaptive Prompt Optimization

- 29.Systematic Task Exploration with LLMs: A Study in Citation Text Generation

- 30.LLMAEL: Large Language Models are Good Context Augmenters for Entity Linking

- 31.Unlocking the Potential of Model Merging for Low-Resource Languages

- 32.From Data to Commonsense Reasoning: The Use of Large Language Models for Explainable AI

- 33.GPT-4 vs. Human Translators: A Comprehensive Evaluation of Translation Quality Across Languages, Domains, and Expertise Levels

1.AnyTaskTune: Advanced Domain-Specific Solutions through Task-Fine-Tuning

标题:AnyTaskTune:通过任务微调实现先进的特定领域解决方案

author:Jiaxi Cui, Wentao Zhang, Jing Tang, Xudong Tong, Zhenwei Zhang, Amie, Jing Wen, Rongsheng Wang, Pengfei Wu

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.07094v1

摘要:

各行各业普遍部署的大型语言模型(Large Language Models-LLMs)往往忽视了个人和小型组织的细微需求,这些组织更受益于针对其特定业务环境精确定制的模型,而不是那些具有广泛卓越通用能力的模型。这项工作介绍了 \textbf{AnyTaskTune},这是一种新颖的微调方法,被称为 \textbf{Task-Fine-Tune},专门用于提升模型在各种特定领域任务中的性能。这种方法涉及一个细致的过程,即在一个领域内识别和定义目标子任务,然后创建专门的增强数据集进行微调,从而优化特定任务的模型性能。我们不仅在法律领域的关键词提取和句子预测等任务中进行了全面的微调实验,还在金融、医疗保健、法律、心理学、消费者服务和人力资源等领域的 20 多个不同子任务中进行了微调实验。为了证实我们的方法并促进社区参与,我们将开源这些双语任务数据集。我们的研究结果表明,使用 \textbf{Task-Fine-Tune} 方法进行微调的模型不仅在这些特定任务上取得了优异的性能,而且在各自的领域中也明显优于通用能力更强的模型。我们的研究成果已在 \url{https://github.com/PandaVT/DataTager} 上公开发表。

2.Lookback Lens: Detecting and Mitigating Contextual Hallucinations in Large Language Models Using Only Attention Maps

标题:回视透镜:在大型语言模型中仅使用注意图检测和减轻语境幻觉

author:Yung-Sung Chuang, Linlu Qiu, Cheng-Yu Hsieh, Ranjay Krishna, Yoon Kim, James Glass

publish:The source code is available at

https://github.com/voidism/Lookback-Lens

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.07071v1

摘要:

当被要求总结文章或回答给定段落中的问题时,大型语言模型(LLM)可能会对细节产生幻觉,并给出与输入上下文不准确的、未经证实的答案。本文介绍了一种检测这种语境幻觉的简单方法。我们假设,语境幻觉与 LLM 对所提供语境中的信息的关注程度有关,而不是与它自己的世代有关。基于这一直觉,我们提出了一个简单的幻觉检测模型,其输入特征由上下文与新生成标记(每个注意头)的注意权重之比给出。我们发现,基于这些回视比率特征的线性分类器与利用 LLM 或基于文本的关联模型的整个隐藏状态的更丰富检测器一样有效。我们发现,基于回视率的检测器–回视透镜–可以跨任务甚至跨模型转移,从而使在 7B 模型上训练的检测器可以应用于(无需重新训练的)更大的 13B 模型。我们进一步将这种检测器应用于减少上下文幻觉,并发现一种简单的分类器引导解码方法能够减少幻觉的数量,例如在 XSum 总结任务中减少了 9.6%。

3.Metron: Holistic Performance Evaluation Framework for LLM Inference Systems

标题:Metron:LLM 推理系统的整体性能评估框架

author:Amey Agrawal, Anmol Agarwal, Nitin Kedia, Jayashree Mohan, Souvik Kundu, Nipun Kwatra, Ramachandran Ramjee, Alexey Tumanov

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.07000v1

摘要:

为生产中的大型语言模型(LLM)提供服务会产生大量成本,这促使推理系统优化工作取得了最新进展。如今,人们根据传统的延迟和吞吐量指标(如 TTFT、TBT、归一化延迟和 TPOT)对这些系统进行评估。然而,这些指标未能完全捕捉到 LLM 推理的细微差别,导致对聊天和翻译等实时应用至关重要的面向用户的性能评估不全面。在本文中,我们首先指出了当前评估 LLM 推断系统的性能指标存在的缺陷。然后,我们提出了 Metron,这是一个全面的性能评估框架,其中包括流畅度指数(fluidity-index),这是一个新颖的指标,旨在反映 LLM 推断过程的复杂性及其对实时用户体验的影响。最后,我们使用 Metron 评估了现有的各种开源平台和模型即服务产品,并讨论了它们的优缺点。Metron可在https://github.com/project-metron/metron。

4.Segment-Based Interactive Machine Translation for Pre-trained Models

标题:基于分段的预训练模型交互式机器翻译

author:Angel Navarro, Francisco Casacuberta

publish:10 pages, 4 figures

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06990v1

摘要:

预训练的大型语言模型(LLM)已开始在许多应用中广泛使用。在这项工作中,我们探索了这些模型在交互式机器翻译(IMT)环境中的应用。我们特别选择了 mBART(多语言双向和自动回归转换器)和 mT5(多语言文本到文本转换器)作为 LLM 来进行实验。该系统利用用户在每次迭代时提供的反馈,以交互方式生成完美的翻译。神经机器翻译 (NMT) 模型根据反馈生成初步假设,用户验证新的正确片段并进行单词修正–重复这一过程,直到句子翻译正确为止。我们在一个基准数据集上比较了 mBART、mT5 和最先进(SoTA)机器翻译模型在用户努力程度、单词笔画比(WSR)、按键笔画比(KSR)和鼠标动作比(MAR)方面的性能。实验结果表明,mBART 的性能可与 SoTA 模型相媲美,这表明它是 IMT 这一领域的可行选择。这一发现的意义延伸到为交互环境开发新的机器翻译模型,因为它表明一些新颖的预训练模型在这一领域表现出了 SoTA 性能,突出了根据特定需求调整这些模型的潜在好处。

5.Divine LLaMAs: Bias, Stereotypes, Stigmatization, and Emotion Representation of Religion in Large Language Models

标题:神圣的 LLaMAs:大型语言模型中宗教的偏见、成见、污名化和情感表征

author:Flor Miriam Plaza-del-Arco, Amanda Cercas Curry, Susanna Paoli, Alba Curry, Dirk Hovy

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06908v1

摘要:

情绪在我们的生活中发挥着重要的认识论和认知作用,揭示我们的价值观并指导我们的行动。以往的研究表明,法学硕士在情感归因方面存在性别偏见。然而,与性别不同的是,宗教作为一种社会文化体系,为其信徒规定了一套信仰和价值观。因此,宗教会培养特定的情感。而且,这些规则是由宗教领袖明确制定和解释的。通过情感归因,我们探究了不同宗教在 LLM 中的表现形式。我们发现美国和欧洲国家的主要宗教在表现上更加细微,其信仰模式也更加模糊。东方宗教(如印度教和佛教)被严重刻板化。犹太教和伊斯兰教被污名化–模型的拒绝率直线上升。我们将这些归因于法学硕士的文化偏见,以及有关宗教的NLP文献的稀缺。在极少数讨论宗教的情况下,往往是在有毒语言的背景下进行的,从而使人们认为这些宗教本身就是有毒的。这一发现强调了解决和纠正这些偏见的迫切需要。我们的研究强调了情感在我们生活中的关键作用,以及我们的价值观如何影响情感。

6.Richelieu: Self-Evolving LLM-Based Agents for AI Diplomacy

标题:黎塞留:用于人工智能外交的基于 LLM 的自进化代理

author:Zhenyu Guan, Xiangyu Kong, Fangwei Zhong, Yizhou Wang

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06813v1

摘要:

外交是人类社会最复杂的活动之一。多方/代理之间的复杂互动涉及社会推理、谈判艺术和长期战略规划等各种能力。以往的人工智能代理肯定已经证明,它们有能力处理涉及多个代理的任务中的多步骤游戏和更大的行动空间。然而,外交涉及的决策空间之大令人咋舌,特别是考虑到所需的谈判阶段。最近,LLM 代理在一些应用中显示出其扩展先前代理边界的潜力,但是,它仍然不足以在复杂的多代理环境中处理很长的规划期。借助最前沿的 LLM 技术,我们结合了基于 LLM 的社会代理的三种核心和基本能力,首次尝试探索人工智能的上界,以实现类似人类代理的高度综合性多代理任务:1) 具有记忆和反思能力的战略规划者;2) 具有社会推理能力的目标导向谈判;3) 通过自我游戏来增强记忆,从而在没有人类参与的情况下实现自我进化。

7.Using Pretrained Large Language Model with Prompt Engineering to Answer Biomedical Questions

标题:利用预训练大语言模型和提示工程回答生物医学问题

author:Wenxin Zhou, Thuy Hang Ngo

publish:Submitted to Conference and Labs of the Evaluation Forum (CLEF) 2024

CEUR-WS

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06779v1

摘要:

我们的团队参加了 BioASQ 2024 任务12b 和 Synergy 任务,目的是建立一个系统,通过检索 PubMed 数据库中的相关文章和片段来回答生物医学问题,并生成准确和理想的答案。我们提出了一种基于预训练大语言模型(LLM)的两级信息检索和问题解答系统,重点是 LLM 提示工程和回复后处理。我们用上下文中的少量实例构建提示,并利用重采样和畸形回应检测等后处理技术。我们比较了各种预训练 LLM 模型在这项挑战中的表现,包括 Mixtral、OpenAI GPT 和 Llama2。在任务 12b 中,我们表现最好的系统在文档检索中取得了 0.14 的 MAP 分数,在片段检索中取得了 0.05 的 MAP 分数,在是/否问题中取得了 0.96 的 F1 分数,在事实类问题中取得了 0.38 的 MRR 分数,在列表问题中取得了 0.50 的 F1 分数。

8.FinCon: A Synthesized LLM Multi-Agent System with Conceptual Verbal Reinforcement for Enhanced Financial Decision Making

标题:FinCon:具有概念语言强化功能的合成 LLM 多智能体系统,用于增强财务决策能力

author:Yangyang Yu, Zhiyuan Yao, Haohang Li, Zhiyang Deng, Yupeng Cao, Zhi Chen, Jordan W. Suchow, Rong Liu, Zhenyu Cui, Denghui Zhang, Zhaozhuo Xu, Koduvayur Subbalakshmi, Guojun Xiong, Yueru He, Jimin Huang, Dong Li, Qianqian Xie

publish:LLM Applications, LLM Agents, Financial Technology, Quantitative

Finance, Algorithmic Trading, Cognitive Science

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06567v1

摘要:

大型语言模型(LLM)在执行复杂任务方面已展现出显著的潜力,并越来越多地应用于各种金融应用中。然而,高质量的连续金融投资决策仍然具有挑战性。这些任务的每一个决策都需要与多变的环境进行多次互动,需要足够的智能来实现收益最大化并管理风险。虽然 LLM 已被用于开发超越人类团队并产生可观投资回报的代理系统,但通过及时的经验提炼来加强多源信息合成和优化决策结果的机会仍有待探索。在此,我们介绍一种基于 LLM 的多代理框架 FinCon,该框架采用 CONceptual 语言强化技术,专为各种 FINancial 任务而量身定制。受到现实世界中有效的投资公司组织结构的启发,FinCon 采用了经理-分析师沟通层次结构。这种结构允许跨职能代理通过自然语言交互为实现统一目标进行同步协作,并为每个代理配备了比人类更强的记忆能力。此外,FinCon 中的风险控制组件通过偶发启动自我批判机制来更新系统投资信念,从而提高决策质量。概念化的信念可作为未来代理行为的口头强化,并可选择性地传播到需要知识更新的适当节点。这一功能大大提高了性能,同时减少了不必要的点对点通信成本。此外,FinCon 还在各种金融任务(包括单一股票交易和投资组合管理)中展示了强大的泛化能力。

9.Combining Knowledge Graphs and Large Language Models

标题:将知识图谱与大型语言模型相结合

author:Amanda Kau, Xuzeng He, Aishwarya Nambissan, Aland Astudillo, Hui Yin, Amir Aryani

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06564v1

摘要:

近年来,自然语言处理(NLP)在聊天机器人、文本生成和语言翻译等各种人工智能(AI)应用中发挥了重要作用。大型语言模型(LLM)的出现大大提高了这些应用的性能,在语言理解和生成方面取得了惊人的成果。然而,它们仍然存在一些缺点,如幻觉和缺乏特定领域的知识,影响了它们在实际任务中的表现。知识图谱(KG)以结构化的格式组织信息,以多功能和可解释的方式捕捉实体之间的关系,可以有效缓解这些问题。同样,知识图谱的构建和验证也提出了挑战,而 LLM 可以帮助解决这些挑战。LLMs 和 KGs 之间的互补关系导致了将这些技术结合起来以实现可信结果的趋势。这项工作收集了 28 篇论文,概述了由 KG 驱动的 LLM、基于 LLM 的 KG 以及 LLM-KG 混合方法。我们对这些方法进行了系统分析和比较,从而提供了一份全面的综述,突出了主要趋势、创新技术和共同挑战。这篇综述将使该领域的新研究人员和那些希望加深了解如何将 KG 与 LLM 有效结合以增强人工智能应用能力的研究人员受益匪浅。

10.LETS-C: Leveraging Language Embedding for Time Series Classification

标题:LETS-C:利用语言嵌入进行时间序列分类

author:Rachneet Kaur, Zhen Zeng, Tucker Balch, Manuela Veloso

publish:22 pages, 5 figures, 10 tables

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06533v1

摘要:

语言建模领域的最新进展表明,将语言建模应用于时间序列数据时,会取得很好的效果。特别是,针对时间序列分类任务的预训练大型语言模型(LLM)的微调在标准基准上达到了最先进(SOTA)的性能。然而,这些基于 LLM 的模型由于模型规模庞大,可训练参数数以百万计,因此存在很大的缺陷。在本文中,我们提出了另一种方法来利用语言建模在时间序列领域的成功经验。我们不对 LLM 进行微调,而是利用语言嵌入模型来嵌入时间序列,然后将嵌入与由卷积神经网络(CNN)和多层感知器(MLP)组成的简单分类头配对。我们在成熟的时间序列分类基准数据集上进行了大量实验。我们证明,LETS-C 不仅在分类准确性上优于当前的 SOTA,而且还提供了一种轻量级解决方案,与 SOTA 模型相比,平均只使用了 14.5% 的可训练参数。我们的研究结果表明,利用语言编码器嵌入时间序列数据,结合简单而有效的分类头,为实现高性能时间序列分类同时保持轻量级模型架构提供了一个很有前景的方向。

11.Towards Understanding Multi-Task Learning (Generalization) of LLMs via Detecting and Exploring Task-Specific Neurons

标题:通过检测和探索特定任务神经元来理解 LLM 的多任务学习(泛化

author:Yongqi Leng, Deyi Xiong

date Time:2024-07-09

paper pdf:http://arxiv.org/pdf/2407.06488v1

摘要:

虽然大型语言模型(LLMs)已经展示出卓越的多任务能力,但理解其背后的学习机制仍然是一个具有挑战性的问题。在本文中,我们试图从神经元的角度来理解这种机制。具体来说,我们通过对特定任务数据的梯度归因来检测 LLM 中对任务敏感的神经元。通过广泛的去激活和微调实验,我们证明检测到的神经元与给定任务高度相关,我们称之为任务特异性神经元。通过这些已识别的特定任务神经元,我们深入研究了多任务学习和持续学习中的两个常见问题:泛化和灾难性遗忘。我们发现,任务特异性神经元的重叠与跨任务的泛化和特化密切相关。有趣的是,在 LLM 的某些层,不同任务特异性神经元的参数具有高度相似性,而这种相似性与泛化性能高度相关。受这些发现的启发,我们提出了一种神经元级持续微调方法,该方法在持续学习过程中只对当前任务特定神经元进行微调,大量实验证明了所提方法的有效性。我们的研究为多任务学习中 LLM 的可解释性提供了启示。

12.A Single Transformer for Scalable Vision-Language Modeling

标题:用于可扩展视觉语言建模的单一变换器

author:Yangyi Chen, Xingyao Wang, Hao Peng, Heng Ji

publish:Code and data are available at https://github.com/Yangyi-Chen/SOLO

date Time:2024-07-08

paper pdf:http://arxiv.org/pdf/2407.06438v1

摘要:

我们提出了可扩展视觉语言模型的单一转换器 SOLO。目前的大型视觉语言模型(LVLM),如 LLaVA,大多采用异构架构,将预先训练好的视觉编码器与大型语言模型(LLM)连接起来,以促进视觉识别和复杂推理。虽然通过相对轻量级的训练实现了出色的性能,但我们发现了四个主要的可扩展性限制:(1)视觉容量受到预先训练的视觉编码器的限制,而视觉编码器通常比 LLM 小一个数量级。(2) 异构架构使使用现有硬件和软件基础设施变得复杂。(3) 在这种架构上研究缩放规律必须考虑三个独立的组件–视觉编码器、连接器和 LLM,这使得分析变得复杂。(4) 使用现有的视觉编码器通常需要按照预定义的图像输入规范进行预处理,例如,将输入图像重塑为固定分辨率的正方形图像,这给高分辨率图像或具有不寻常长宽比的图像的处理和训练带来了困难。统一的单一变换器架构(如 SOLO)可有效解决 LVLMs 中的这些可扩展性问题;然而,它在现代环境中的应用有限,可能是因为缺乏可靠的训练方法来平衡两种模式并确保十亿规模模型的稳定训练。在本文中,我们介绍了首个开源训练方法,用于利用中等学术资源开发开源 7B LVLM SOLO。训练方法包括从 LLM 初始化、在 ImageNet 和网络规模数据上进行顺序预训练,以及在我们策划的高质量数据集上进行指令微调。在广泛的评估中,SOLO 的性能可与 LLaVA-v1.5-7B 相媲美,尤其是在视觉数学推理方面表现出色。

13.Using Grammar Masking to Ensure Syntactic Validity in LLM-based Modeling Tasks

标题:在基于 LLM 的建模任务中使用语法屏蔽确保句法有效性

author:Lukas Netz, Jan Reimer, Bernhard Rumpe

publish:Preprint to be published in the MODELS Workshop “MDE Intelligence”

date Time:2024-07-08

paper pdf:http://arxiv.org/pdf/2407.06146v2

摘要:

我们介绍并评估了一种称为语法遮蔽的方法,这种方法用于引导大型语言模型(LLM)为给定的无上下文语法生成语法正确的模型。提示工程方法(如少量学习或引物法)可用于提高 LLM 生成正确语法的几率,但语法越复杂,这些方法就越耗时,而且前景越暗淡。以往的工作主要集中在语言模型训练或提示工程的使用上。在这项工作中,我们提出了一种方法,利用约束解码将输出限制在给定的语法中,以确保输出符合有效的语法。我们使用了使用 MontiCore 构建的多个 DSL,并让多个 LLM 在有约束解码和无约束解码的情况下生成模型。相应的解析器用于确认每个模型的语法正确性。我们的研究表明,语法屏蔽可以显著提高多个 LLM 的建模能力,减少对精细提示的需求,同时提高生成正确模型的几率。

14.Artificial Intuition: Efficient Classification of Scientific Abstracts

标题:人工直觉科学摘要的高效分类

author:Harsh Sakhrani, Naseela Pervez, Anirudh Ravi Kumar, Fred Morstatter, Alexandra Graddy Reed, Andrea Belz

date Time:2024-07-08

paper pdf:http://arxiv.org/pdf/2407.06093v1

摘要:

对科学短文(如拨款或出版物摘要)进行粗略分类,以用于战略洞察或研究组合管理,是非常可取的。这些文本能将密集的信息有效地传递给拥有丰富知识的专家,帮助他们进行解读。然而,由于篇幅简短且缺乏上下文,这项任务很难实现自动化。为了弥补这一不足,我们开发了一种新颖的方法来生成和适当分配粗略的特定领域标签。我们表明,大语言模型(LLM)可以提供对这项任务至关重要的元数据,这一过程类似于代表人类直觉的补充知识的增强,我们还提出了一个工作流程。作为试点研究,我们使用了美国国家航空航天局(NASA)的获奖摘要语料库。我们结合既定的性能指标开发了新的评估工具。

15.LLaMAX: Scaling Linguistic Horizons of LLM by Enhancing Translation Capabilities Beyond 100 Languages

标题:LLaMAX:通过增强 100 多种语言的翻译能力来扩展 LLM 的语言视野

author:Yinquan Lu, Wenhao Zhu, Lei Li, Yu Qiao, Fei Yuan

date Time:2024-07-08

paper pdf:http://arxiv.org/pdf/2407.05975v1

摘要:

大型语言模型(LLMs)在高资源语言任务中表现出卓越的翻译能力,但其在低资源语言中的表现却受到预训练期间多语言数据不足的阻碍。为了解决这个问题,我们投入了 35,000 个 A100-SXM4-80GB GPU 小时,对 LLaMA 系列模型进行了广泛的多语言持续预训练,从而实现了对 100 多种语言的翻译支持。通过对词汇扩展和数据增强等训练策略的全面分析,我们开发出了 LLaMAX。值得注意的是,在不牺牲泛化能力的前提下,LLaMAX 的翻译性能明显高于现有的开源 LLMs(高出 10 spBLEU 点以上),在 Flores-101 基准测试中的表现与专业翻译模型 M2M-100-12B 不相上下。大量实验表明,LLaMAX 可以作为一种稳健的多语言基础模型。代码/footnote{/url{https://github.com/CONE-MT/LLaMAX/.}}和模型/footnote{/url{https://huggingface.co/LLaMAX/.}}均可公开获取。

16.Is GPT-4 Alone Sufficient for Automated Essay Scoring?: A Comparative Judgment Approach Based on Rater Cognition

标题:单凭 GPT-4 是否足以实现作文自动评分?基于评分者认知的比较判断方法

author:Seungju Kim, Meounggun Jo

publish:16 pages, 3 figures, Learning @ Scale 2024

date Time:2024-07-08

paper pdf:http://arxiv.org/pdf/2407.05733v1

摘要:

大语言模型(LLMs)在自动作文评分(AES)中大有可为,但与最先进的模型和人类评分员相比,它们的零分和少分性能往往不尽如人意。然而,由于实际教育环境中使用的作文提示和评分标准多种多样,针对每项具体任务对 LLM 进行微调是不切实际的。本研究针对 AES 提出了一种结合 LLMs 和比较判断 (CJ) 的新方法,使用零枪提示在两篇作文中做出选择。我们证明,在使用 LLMs 进行作文评分时,CJ 方法超越了传统的基于评分标准的评分方法。

17.Open-world Multi-label Text Classification with Extremely Weak Supervision

标题:极弱监督下的开放世界多标签文本分类

author:Xintong Li, Jinya Jiang, Ria Dharmani, Jayanth Srinivasa, Gaowen Liu, Jingbo Shang

publish:Preprint

date Time:2024-07-08

paper pdf:http://arxiv.org/pdf/2407.05609v1

摘要:

我们研究的是极端弱监督(XWS)下的开放世界多标签文本分类,在这种情况下,用户只需提供对分类目标的简要描述,而无需任何标签或地面真实标签空间。最近,人们探索了类似的单标签 XWS 设置,然而,这些方法并不容易适用于多标签。我们注意到:(1) 大多数文档都有一个覆盖大部分内容的主要类别;(2) 长尾标签会作为主要类别出现在某些文档中。因此,我们首先利用用户描述来提示原始文档子集的主导关键词大语言模型(LLM),然后通过聚类构建(初始)标签空间。我们进一步应用零点多标签分类器,找出预测得分最高的小文档,这样我们就可以重新查看它们的主导关键词,以获得更多的长尾标签。我们通过迭代这一过程来发现一个全面的标签空间,并构建一个多标签分类器作为一种新方法–X-MLClass。X-MLClass 在各种数据集上的地面实况标签空间覆盖率都有显著提高,例如在 AAPD 数据集上比主题建模和关键词提取方法提高了 40%。此外,X-MLClass 还实现了最佳的端到端多标签分类准确率。

18.Faux Polyglot: A Study on Information Disparity in Multilingual Large Language Models

标题:假多语种:多语种大语言模型中的信息差异研究

author:Nikhil Sharma, Kenton Murray, Ziang Xiao

date Time:2024-07-07

paper pdf:http://arxiv.org/pdf/2407.05502v1

摘要:

随着检索增强生成(RAG)技术的发展,大语言模型(LLM)在信息搜索中发挥着举足轻重的作用,并在全球范围内得到广泛应用。虽然大型语言模型的多语言能力为消除语言障碍提供了新的机遇,但在现实生活中,多语言资源之间的语言鸿沟和知识冲突是否会发生?在本文中,我们研究了在基于 RAG 的信息搜索环境中 LLM 的语言偏好。我们发现,在信息检索和答案生成过程中,LLM 都表现出系统性的偏好,即偏好与查询语言相同的信息。此外,在查询语言信息很少的情况下,语言学者更倾向于使用高资源语言的文档,从而强化了主流观点。这种偏见既存在于事实性查询,也存在于观点性查询。我们的研究结果凸显了信息搜索系统中多语言 LLM 的语言分歧。多语种 LLMs 的多语能力看似有益,但可能会强化特定语言的信息茧或过滤泡沫,进一步边缘化低资源观点,从而对信息均等产生反作用。

19.Enhancing Computer Programming Education with LLMs: A Study on Effective Prompt Engineering for Python Code Generation

标题:利用法学硕士加强计算机编程教育:Python 代码生成的有效提示工程研究

author:Tianyu Wang, Nianjun Zhou, Zhixiong Chen

publish:18 pages, 9 figures

date Time:2024-07-07

paper pdf:http://arxiv.org/pdf/2407.05437v1

摘要:

大型语言模型(LLM)和提示工程在通过个性化教学推进计算机编程教育方面具有巨大潜力。本文通过研究三个关键的研究问题来探索这一潜力:针对不同教育需求的提示工程策略的系统分类、增强 LLM 解决超出其固有能力的复杂问题的能力,以及建立评估和实施这些策略的强大框架。我们的方法包括根据教育要求对编程问题进行分类,应用各种提示工程策略,以及评估 LLM 生成的回复的有效性。在 LeetCode 和 USACO 等数据集上使用 GPT-4、GPT-4o、Llama3-8b 和 Mixtral-8x7b 模型进行的实验表明,GPT-4o 始终优于其他模型,尤其是在使用 "多步骤 "提示策略时。研究结果表明,量身定制的提示策略能显著提高 LLM 的成绩,并为基础学习、竞赛准备和高级问题解决推荐了特定策略。这项研究强调了提示工程在最大限度地提高 LLM 教育效益方面的关键作用。通过系统地分类和测试这些策略,我们为教育工作者和学生提供了一个全面的框架,以优化基于 LLM 的学习体验。未来的研究应侧重于完善这些策略和解决当前 LLM 的局限性,以进一步提高计算机编程教学的教育成果。

20.LTLBench: Towards Benchmarks for Evaluating Temporal Logic Reasoning in Large Language Models

标题:LTLBench:为评估大型语言模型中的时态逻辑推理建立基准

author:Weizhi Tang, Vaishak Belle

date Time:2024-07-07

paper pdf:http://arxiv.org/pdf/2407.05434v1

摘要:

时间推理(TR)是人工智能的一个重要组成部分,包括理解和处理时间信息以及事件之间的关系。为了发现和研究大型语言模型(LLM)的时间推理能力,人们以不同的方式构建了各种数据集,用于评估时间推理能力的各个方面。我们的研究提出了一种新方法,即利用随机有向图生成、LTL 公式和 NuSMV 模型检查器,设计和开发一种用于构建数据集的管道,以评估 LLM 的 TR 能力。基于该流程,我们还构建了一个基准数据集,即 LTLBench,其中包含 2,000 个 TR 挑战,并用它评估了六个 LLM。此外,我们还进行了额外的实验,以发现增加事件和公式运算符的数量对 TR 问题的复杂性和 LLM 性能的影响。我们已经证明,尽管 LLM 在处理 TR 挑战方面表现出了一定的前景,但它们在处理复杂 TR 时仍然很吃力。我们希望这项工作能让我们深入了解 LLM 的 TR 能力,同时为未来的 TR 评估提供有价值的工具。

21.A Study of Test-time Contrastive Concepts for Open-world, Open-vocabulary Semantic Segmentation

标题:开放世界、开放词汇语义分割的测试时间对比概念研究

author:Monika Wysoczańska, Antonin Vobecky, Amaia Cardiel, Tomasz Trzciński, Renaud Marlet, Andrei Bursuc, Oriane Siméoni

date Time:2024-07-06

paper pdf:http://arxiv.org/pdf/2407.05061v1

摘要:

最近的 VLM 在大量图像-文本对上进行了预先训练,使两种模式保持一致,为开放词汇语义分割开辟了道路。给定一组任意的文本查询,图像区域将被分配给特征空间中最接近的查询。然而,通常的设置要求用户列出图像中可能出现的所有视觉概念,通常是基准数据集中的所有类别,这些概念互为否定。我们在此考虑的是更具挑战性的情况,即在没有其他任何信息的情况下,根据文字提示分割出单一概念。为了取得好的结果,除了与通用 "背景 "文本进行对比外,我们还研究了生成特定测试时间对比文本概念的不同方法,这些方法可以利用 VLM 训练集中的文本分布,也可以利用精心制作的 LLM 提示。我们使用一种新的特定指标来展示我们方法的相关性。

22.How do you know that? Teaching Generative Language Models to Reference Answers to Biomedical Questions

标题:您是如何知道的?教生成语言模型参考生物医学问题的答案

author:Bojana Bašaragin, Adela Ljajić, Darija Medvecki, Lorenzo Cassano, Miloš Košprdić, Nikola Milošević

publish:Accepted at BioNLP Workshop 2024, colocated with ACL 2024

date Time:2024-07-06

paper pdf:http://arxiv.org/pdf/2407.05015v1

摘要:

大型语言模型(LLM)最近已成为用户在线问题解答的主要来源。尽管 LLMs 能够提供掷地有声的答案,但其准确性和可靠性也是一个巨大的挑战。这对于生物医学等敏感领域尤其如此,因为这些领域更需要符合事实的正确答案。本文介绍了一种生物医学检索增强生成(RAG)系统,旨在提高生成回答的可靠性。该系统基于经过微调的 LLM,用于参考问题的回答,其中从 PubMed 检索到的相关摘要通过提示作为输入传递给 LLM 的上下文。它的输出是基于 PubMed 摘要的答案,其中每个语句都有相应的引用,允许用户验证答案。与 PubMed 搜索引擎相比,我们的检索系统绝对提高了 23%。根据对小样本的人工评估,我们的微调 LLM 组件在引用相关摘要方面取得了与 GPT-4 Turbo 相当的效果。我们公开了用于微调模型的数据集以及基于 Mistral-7B-instruct-v0.1 和 v0.2 的微调模型。

23.EVA-Score: Evaluation of Long-form Summarization on Informativeness through Extraction and Validation

标题:EVA-Score:通过提取和验证评估长篇摘要的信息量

author:Yuchen Fan, Xin Zhong, Chengsi Wang, Gaoche Wu, Bowen Zhou

publish:16 pages, 3 figures, submitted to EMNLP

date Time:2024-07-06

paper pdf:http://arxiv.org/pdf/2407.04969v1

摘要:

摘要是自然语言处理(NLP)中的一项基本任务,自 GPT-4 和 Claude 等大型语言模型(LLM)问世以来,人们越来越关注输入序列更长、包含信息更多的长式摘要。 目前的评价指标要么使用基于相似性的指标,如 ROUGE 和 BERTScore,这些指标依赖于相似性,而没有考虑信息量;要么使用基于 LLM 的指标,这些指标缺乏对信息丰富度的定量分析,而且比较主观。 在本文中,我们提出了一种名为 EVA-Score 的新评价指标,利用原子事实链生成和文档级关系提取来自动计算信息量,并给出一个确定的数字作为信息得分。实验结果表明,我们的指标与人类的相关性达到了一流水平。我们还从信息方面重新全面评估了 LLM 在长篇摘要中的表现,并预测了未来使用 LLM 进行长篇摘要的方法。

24.MMSci: A Multimodal Multi-Discipline Dataset for PhD-Level Scientific Comprehension

标题:MMSci:用于博士级科学理解的多模态多学科数据集

author:Zekun Li, Xianjun Yang, Kyuri Choi, Wanrong Zhu, Ryan Hsieh, HyeonJung Kim, Jin Hyuk Lim, Sungyoung Ji, Byungju Lee, Xifeng Yan, Linda Ruth Petzold, Stephen D. Wilson, Woosang Lim, William Yang Wang

publish:Code and data are available at https://github.com/Leezekun/MMSci

date Time:2024-07-06

paper pdf:http://arxiv.org/pdf/2407.04903v1

摘要:

大型语言模型(LLMs)和大型多模态模型(LMMs)的快速发展提高了对能够理解科学文章和图表的人工智能科学助手的需求。尽管取得了进展,但在评估模型对专业级、研究生级甚至博士级科学内容的理解能力方面仍存在巨大差距。目前的数据集和基准主要集中在相对简单的科学任务和图表上,缺乏对不同高级科学学科的全面评估。为了弥补这一不足,我们从《自然-通讯》期刊上发表的开放获取科学文章中收集了一个多模式、多学科的数据集。该数据集横跨 72 个科学学科,确保了多样性和质量。我们创建了具有各种任务和设置的基准,以全面评估 LMM 在理解科学数字和内容方面的能力。我们的评估结果表明,这些任务具有很高的挑战性:许多开源模型都非常吃力,甚至 GPT-4V 和 GPT-4o 也面临困难。我们还探索了将我们的数据集作为训练资源,通过构建视觉指令跟踪数据,使 7B LLaVA 模型在我们的基准测试中取得了与 GPT-4V/o 相当的性能。此外,我们还研究了使用交错文章文本和图表图像对 LMM 进行预训练,从而改进了材料生成任务。源数据集(包括文章、图表、构建的基准和视觉指令跟踪数据)已开源。

25.Towards Enhancing Coherence in Extractive Summarization: Dataset and Experiments with LLMs

标题:在提取式总结中加强一致性:数据集和 LLM 实验

author:Mihir Parmar, Hanieh Deilamsalehy, Franck Dernoncourt, Seunghyun Yoon, Ryan A. Rossi, Trung Bui

publish:10 pages

date Time:2024-07-05

paper pdf:http://arxiv.org/pdf/2407.04855v1

摘要:

抽取式摘要在自然语言处理中起着举足轻重的作用,因为它应用广泛,既能高效地摘要各种内容,又能忠实于原始内容。尽管大语言模型(LLM)在提取式摘要方面取得了重大进展,但这些摘要经常表现出不连贯。一致性摘要的一个重要方面是其对目标用户的可读性。虽然已经有很多数据集和基准被提出来用于创建连贯的摘录式摘要,但目前还没有一个数据集和基准结合用户意图来提高摘录式摘要的连贯性。受此启发,我们提出了一个系统创建的人类注释数据集,该数据集由五个公开数据集的一致性摘要和自然语言用户反馈组成,为如何提高提取摘要的一致性提供了宝贵的见解。我们利用这个数据集,通过监督微调和自然语言用户反馈来调整 LLM,以提高其生成摘要的一致性。使用 Falcon-40B 和 Llama-2-13B 进行的初步实验表明,在生成一致性摘要方面,性能有了显著提高(约为 10% Rouge-L)。我们进一步利用人体反馈,对经过指令调整的模型(如 FLAN-T5)的结果进行了基准测试,得出了一些有趣的发现。数据和源代码请访问 https://github.com/Mihir3009/Extract-AI。

26.Entity Decomposition with Filtering: A Zero-Shot Clinical Named Entity Recognition Framework

标题:带有过滤功能的实体分解:零镜头临床命名实体识别框架

author:Reza Averly, Xia Ning

publish:Preprint

date Time:2024-07-05

paper pdf:http://arxiv.org/pdf/2407.04629v1

摘要:

临床命名实体识别(NER)旨在检索临床叙述中的重要实体。最近的研究表明,大型语言模型(LLMs)可以在这项任务中取得优异的性能。以前的工作主要集中在专有 LLM 上,而我们则研究了专门为实体识别而训练的开放式 NER LLM 在临床 NER 中的表现。在本文中,我们旨在通过一种新颖的框架–带过滤的实体分解或 EDF–来改进它们。我们的主要想法是将实体识别任务分解为若干子实体类型的检索。我们还引入了一种过滤机制来去除不正确的实体。我们的实验结果证明了我们的框架在所有指标、模型、数据集和实体类型上的功效。我们的分析表明,实体分解可以识别以前遗漏的实体,而且效果显著。我们还进一步对我们的框架进行了全面评估,并进行了深入的误差分析,为今后的工作铺平了道路。

27.Using LLMs to label medical papers according to the CIViC evidence model

标题:根据 CIViC 证据模型使用 LLM 标签医学论文

author:Markus Hisch, Xing David Wang

date Time:2024-07-05

paper pdf:http://arxiv.org/pdf/2407.04466v1

摘要:

我们将序列分类问题 CIViC Evidence 引入医学 NLP 领域。CIViC Evidence 是一个多标签分类问题,即为研究了各种基因组变异、癌症类型和治疗方法组合的科学论文摘要分配临床证据标签。我们使用不同的语言模型来处理 CIViC Evidence:我们在 CIViC Evidence 数据集上对 BERT 和 RoBERTa 的预训练检查点进行了微调,并将它们的性能与在特定领域文本上经过预训练的相同架构的模型进行了比较。在这种情况下,我们发现 BiomedBERT 和 BioLinkBERT 在 CIViC Evidence 数据集上的表现优于 BERT(类支持加权 F1 分数的绝对改进率分别为 +0.8% 和 +0.9%)。与基于 bigram tf-idf 分数训练的逻辑回归相比,所有基于变换器的模型都显示出明显的性能优势(F1 分数提高 +1.5 - 2.7%)。我们将上述类似于 BERT 的模型与 OpenAI 的 GPT-4 进行了比较(在原始测试数据集的一小部分上),结果表明,在没有额外的提示工程或微调的情况下,GPT-4 在 CIViC 证据上的表现不如我们的六个微调模型(加权 F1 分数为 66.1%,而最佳微调模型为 71.8%)。不过,GPT-4 的表现相当接近基于 bigram tf-idf 分数训练的逻辑回归模型的基准(67.7% 的加权 F1 分数)。

28.MAPO: Boosting Large Language Model Performance with Model-Adaptive Prompt Optimization

标题:MAPO:通过模型自适应提示优化提升大型语言模型性能

author:Yuyan Chen, Zhihao Wen, Ge Fan, Zhengyu Chen, Wei Wu, Dayiheng Liu, Zhixu Li, Bang Liu, Yanghua Xiao

publish:Accepted to EMNLP 2023 (Findings)

date Time:2024-07-04

paper pdf:http://arxiv.org/pdf/2407.04118v1

摘要:

提示工程作为利用大型语言模型(LLM)的一种高效和有效的方法,已经引起了研究界的广泛关注。现有的研究主要强调根据特定任务而不是特定 LLM 调整提示的重要性。然而,一个好的提示不仅取决于其措辞,还与相关 LLM 的性质息息相关。在这项工作中,我们首先从数量上证明了不同的提示语应适应不同的 LLM,以增强其在 NLP 中各种下游任务中的能力。然后,我们新颖地提出了一种模型自适应提示优化器(MAPO)方法,该方法可针对下游任务中的每个特定 LLM 优化原始提示。广泛的实验表明,所提出的方法可以有效地改进 LLM 的提示,从而在各种下游任务中取得显著的改进。

29.Systematic Task Exploration with LLMs: A Study in Citation Text Generation

标题:使用 LLM 进行系统任务探索:引文文本生成研究

author:Furkan Şahinuç, Ilia Kuznetsov, Yufang Hou, Iryna Gurevych

publish:Accepted to ACL 2024 (Main)

date Time:2024-07-04

paper pdf:http://arxiv.org/pdf/2407.04046v1

摘要:

大型语言模型(LLM)在定义和执行复杂、创造性的自然语言生成(NLG)任务方面具有前所未有的灵活性。然而,这种灵活性也带来了新的挑战,因为它为制定任务输入和指令以及评估模型性能带来了新的自由度。为了促进对创造性 NLG 任务的探索,我们提出了一个由系统输入操作、参考数据和输出测量三部分组成的研究框架。我们利用这一框架来探索引文文本的生成–这是一项流行的学术 NLP 任务,在任务定义和评估指标方面缺乏共识,而且尚未在 LLM 范式中得到解决。我们的结果强调了在提示 LLM 时系统地研究任务指令和输入配置的重要性,并揭示了用于引文文本生成的不同评价指标之间的非微妙关系。更多的人类生成和人类评估实验为任务提供了新的定性见解,为今后的引文文本生成研究提供了指导。我们公开我们的代码和数据。

30.LLMAEL: Large Language Models are Good Context Augmenters for Entity Linking

标题:LLMAEL:大型语言模型是实体链接的良好语境增强器

author:Amy Xin, Yunjia Qi, Zijun Yao, Fangwei Zhu, Kaisheng Zeng, Xu Bin, Lei Hou, Juanzi Li

date Time:2024-07-04

paper pdf:http://arxiv.org/pdf/2407.04020v1

摘要:

实体链接(EL)模型在根据给定上下文将提及映射到相应实体方面训练有素。然而,由于其训练数据有限,EL 模型在消除长尾实体的歧义方面举步维艰。与此同时,大语言模型(LLM)在解释不常见的提及方面更为强大。然而,由于缺乏专门的训练,LLM 在生成正确的实体 ID 方面存在缺陷。此外,训练 LLM 来执行 EL 需要大量成本。基于这些见解,我们推出了 LLM 增强实体链接 LLMAEL,这是一种即插即用的方法,可通过 LLM 数据增强来增强实体链接。我们利用 LLM 作为知识上下文增强器,生成以提及为中心的描述作为额外输入,同时保留传统的 EL 模型用于特定任务处理。在 6 个标准数据集上进行的实验表明,普通 LLMAEL 在大多数情况下都优于基准 EL 模型,而经过微调的 LLMAEL 在所有 6 个基准中都取得了新的一流成绩。

31.Unlocking the Potential of Model Merging for Low-Resource Languages

标题:释放低资源语言模型合并的潜力

author:Mingxu Tao, Chen Zhang, Quzhe Huang, Tianyao Ma, Songfang Huang, Dongyan Zhao, Yansong Feng

date Time:2024-07-04

paper pdf:http://arxiv.org/pdf/2407.03994v2

摘要:

让大型语言模型(LLM)适应新语言通常需要持续的预训练(CT),然后再进行有监督的微调(SFT)。然而,在低资源语言背景下,这种先预训练再微调的方法在有限的数据面前举步维艰,无法兼顾语言建模和任务解决能力。因此,我们提出了模型合并作为低资源语言的替代方法,将具有不同能力的模型合并为一个模型,而无需额外的训练。我们利用模型合并技术,在没有目标语言 SFT 数据的情况下,为低资源语言开发任务解决型 LLM。我们基于 Llama-2-7B 的实验证明,模型合并能有效地赋予低资源语言的 LLMs 任务解决能力,在数据极度匮乏的情况下,其性能优于 CT-then-SFT 模型。我们发现随着训练标记的增加,模型合并的性能会达到饱和,因此我们进一步分析了合并过程,并在模型合并算法中引入了一个松弛变量,以减少重要参数的损失,从而提高性能。我们希望模型合并能以更高的数据效率造福更多数据匮乏的人类语言。

32.From Data to Commonsense Reasoning: The Use of Large Language Models for Explainable AI

标题:从数据到常识推理:大型语言模型在可解释人工智能中的应用

author:Stefanie Krause, Frieder Stolzenburg

publish:19 pages

date Time:2024-07-04

paper pdf:http://arxiv.org/pdf/2407.03778v1

摘要:

常识推理对计算机来说是一项艰巨的任务,但对人工智能(AI)来说却是一项关键技能。它可以提高人工智能模型的可解释性,使它们能够为自己的决策提供直观的、类似于人类的解释。这在许多领域都是必要的,尤其是在问题解答(QA)领域,这是自然语言处理(NLP)最重要的任务之一。随着时间的推移,出现了许多解决常识推理问题的方法,如使用形式逻辑或语言分析的基于知识的方法。在本文中,我们研究了大型语言模型(LLM)在不同质量保证任务中的有效性,重点关注它们在推理和可解释性方面的能力。我们研究了三种 LLM:GPT-3.5、Gemma 和 Llama 3。我们还通过问卷进一步评估了 LLM 的结果。我们证明了 LLM 利用常识进行推理的能力,因为这些模型在不同数据集上的表现都优于人类。GPT-3.5 在各种质量保证基准上的准确率从 56% 到 93% 不等,而 Llama 3 在所有 11 个数据集上的平均准确率达到了 90%。因此,Llama 3 在所有数据集上的表现都优于人类,在十个数据集上的平均准确率高出 21%。此外,从可解释人工智能(XAI)的角度来看,我们可以评价说,GPT-3.5 为其决策提供了很好的解释。我们的问卷调查显示,66% 的参与者将 GPT-3.5 的解释评为 "良好 "或 “优秀”。总之,这些发现丰富了我们对当前 LLM 的理解,并为未来推理和可解释性的研究铺平了道路。

33.GPT-4 vs. Human Translators: A Comprehensive Evaluation of Translation Quality Across Languages, Domains, and Expertise Levels

标题:GPT-4 与人工翻译:跨语言、跨领域和跨专业水平的翻译质量综合评估

author:Jianhao Yan, Pingchuan Yan, Yulong Chen, Judy Li, Xianchao Zhu, Yue Zhang

date Time:2024-07-04

paper pdf:http://arxiv.org/pdf/2407.03658v1

摘要:

本研究全面评估了大型语言模型(LLM),特别是 GPT-4 的翻译质量,并与多语言对和多领域中不同专业水平的人类译者进行了对比。通过精心设计的注释轮,我们发现 GPT-4 在总错误方面的表现与初级译员相当,但落后于中级和高级译员。我们还观察到不同语言和领域之间的不平衡表现,从资源丰富的方向到资源贫乏的方向,GPT-4 的翻译能力逐渐减弱。此外,我们还对 GPT-4 和人类译员的翻译进行了定性研究,发现 GPT-4 译员在直译方面存在不足,但人类译员有时会过度考虑背景信息。据我们所知,这项研究是首次将 LLM 与人类译者进行对比评估,并分析其产出之间的系统性差异,为了解基于 LLM 的翻译现状及其潜在局限性提供了宝贵的见解。

![[Tensor学习]你不得不知道的知识点-切点-反转](https://i-blog.csdnimg.cn/direct/ae04c7994dc54b18b1f93050b8f81193.png)