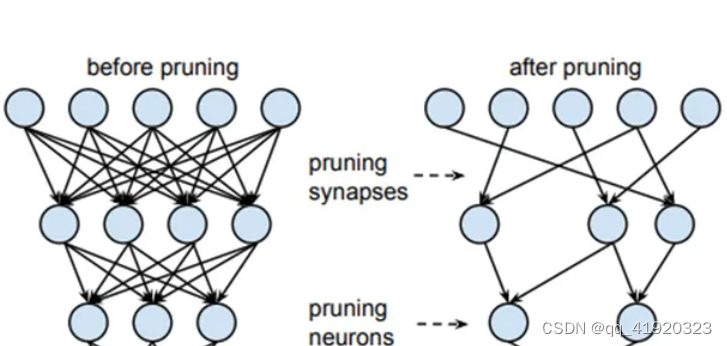

模型剪枝简介

模型剪枝(Model Pruning)是一种通过减少模型参数来降低模型复杂性的方法,从而加快推理速度并减少内存消耗,同时尽量不显著降低模型性能。这种技术特别适用于资源受限的设备,如移动设备和嵌入式系统。模型剪枝通常应用于深度神经网络,尤其是卷积神经网络(CNNs)。

模型剪枝的类型

1. 非结构化剪枝(Unstructured Pruning)

功能

非结构化剪枝是指在模型的权重矩阵中按权重值的绝对值大小进行剪枝。具体过程如下:

- 计算每个权重的绝对值。

- 按照预设的剪枝比例(例如10%)对权重进行排序。

- 将排序后绝对值最小的权重置为零。

这种方法可以在不显著影响模型性能的情况下显著减少模型参数,但由于权重矩阵变得稀疏,硬件加速器可能难以有效利用这种稀疏性。

操作步骤和代码示例

import torch

import torch.nn.utils.prune as prune

import torch.nn as nn

# 定义一个简单的线性层

linear = nn.Linear(5, 3)

# 打印剪枝前的权重

print("Original weights:")

print(linear.weight)

# 按L1范数进行非结构化剪枝

prune.l1_unstructured(linear, name='weight', amount=0.5)

# 打印剪枝后的权重

print("Pruned weights:")

print(linear.weight)

# 打印掩码

print("Weight mask:")

print(linear.weight_mask)

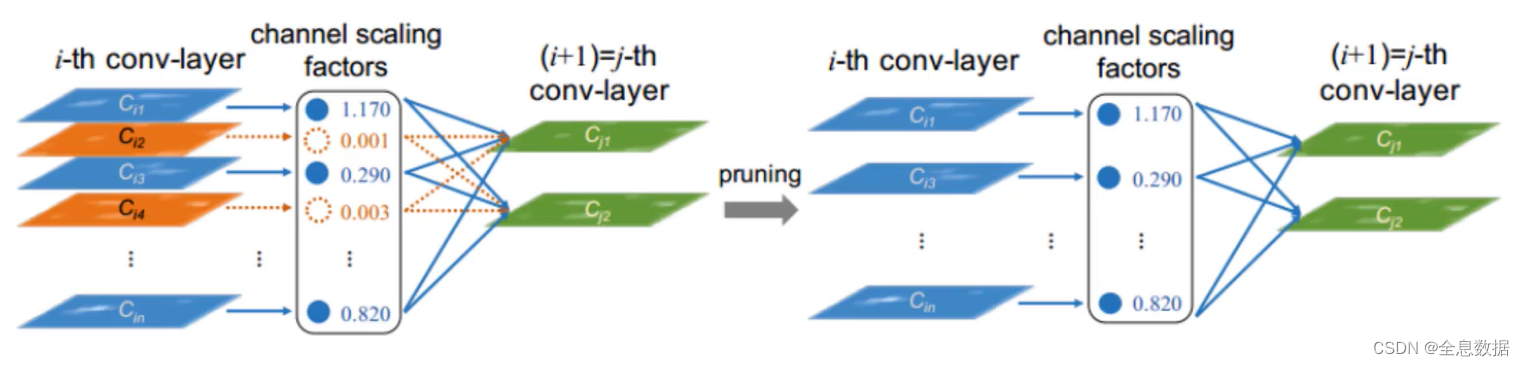

2. 结构化剪枝(Structured Pruning)

功能

结构化剪枝通过剪除整个神经元、滤波器或层来减少模型的计算复杂度。常见的方法包括:

- 剪枝整个神经元:删除网络中的特定神经元及其连接。

- 剪枝卷积滤波器:删除整个卷积核,从而减少整个层的计算需求。

- 剪枝层:删除不重要的网络层。

结构化剪枝可以更有效地利用现有硬件加速器,但剪枝后的模型性能下降可能更显著。

操作步骤和代码示例

import torch

import torch.nn.utils.prune as prune

import torch.nn as nn

# 定义一个简单的卷积层

conv = nn.Conv2d(1, 3, 3)

# 打印剪枝前的权重

print("Original weights:")

print(conv.weight)

# 按L2范数进行结构化剪枝,剪掉50%的过滤器

prune.ln_structured(conv, name='weight', amount=0.5, n=2, dim=0)

# 打印剪枝后的权重

print("Pruned weights:")

print(conv.weight)

# 打印掩码

print("Weight mask:")

print(conv.weight_mask)

3. 微调(Fine-tuning)

剪枝后,模型的性能通常会下降。因此,需要对剪枝后的模型进行微调,以恢复其性能。微调过程与模型训练类似,但通常采用较小的学习率,以防止模型参数剧烈波动。

操作步骤和代码示例

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 定义简单的神经网络

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(28*28, 512)

self.fc2 = nn.Linear(512, 10)

def forward(self, x):

x = x.view(-1, 28*28)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

# 加载MNIST数据集

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))])

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)

# 初始化模型、损失函数和优化器

model = SimpleNet()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练模型

def train(model, train_loader, criterion, optimizer, epochs=5):

model.train()

for epoch in range(epochs):

for data, target in train_loader:

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item():.4f}')

train(model, train_loader, criterion, optimizer)

# 微调模型

train(model, train_loader, criterion, optimizer)

4. 评估和优化

在评估模型性能时,我们可以通过计算模型的准确率、损失等指标来判断剪枝后的模型性能是否满足需求。如果性能下降过多,可以调整剪枝比例或尝试其他剪枝方法。

操作步骤和代码示例

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 定义简单的神经网络

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(28*28, 512)

self.fc2 = nn.Linear(512, 10)

def forward(self, x):

x = x.view(-1, 28*28)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

# 加载MNIST数据集

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))])

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)

test_dataset = datasets.MNIST(root='./data', train=False, download=True, transform=transform)

test_loader = DataLoader(test_dataset, batch_size=1000, shuffle=False)

# 初始化模型、损失函数和优化器

model = SimpleNet()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练模型

def train(model, train_loader, criterion, optimizer, epochs=5):

model.train()

for epoch in range(epochs):

for data, target in train_loader:

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item():.4f}')

train(model, train_loader, criterion, optimizer)

# 评估模型性能

def test(model, test_loader):

model.eval()

correct = 0

with torch.no_grad():

for data, target in test_loader:

output = model(data)

pred = output.argmax(dim=1, keepdim=True)

correct += pred.eq(target.view_as(pred)).sum().item()

print(f'Accuracy: {correct / len(test_loader.dataset):.4f}')

test(model, test_loader)

剪枝接口及其具体参数

在PyTorch中,剪枝通常通过torch.nn.utils.prune模块来实现。这个模块提供了一些通用的剪枝方法和工具,可以用于实现非结构化剪枝和结构化剪枝。

1. torch.nn.utils.prune.l1_unstructured

按L1范数对权重进行非结构化剪枝。

参数

module: 要剪枝的模块(如层)。name: 要剪枝的参数名称(如weight)。amount: 剪枝比例,可以是一个0到1之间的小数(表示剪掉的参数比例)或一个整数(表示剪掉的参数个数)。

代码示例

import torch

import torch.nn.utils.prune as prune

import torch.nn as nn

# 定义一个简单的线性层

linear = nn.Linear(5, 3)

# 打印剪枝前的权重

print("Original weights:")

print(linear.weight)

# 按L1范数进行非结构化剪枝

prune.l1_unstructured(linear, name='weight', amount=0.5)

# 打印剪枝后的权重

print("Pruned weights:")

print(linear.weight)

# 打印掩码

print("Weight mask:")

print(linear.weight_mask)

2. torch.nn.utils.prune.random_unstructured

随机对权重进行非结构化剪枝。

参数

module: 要剪枝的模块(如层)。name: 要剪枝的参数名称(如weight)。amount: 剪枝比例,可以是一个0到1之间的小数(表示剪掉的参数比例)或一个整数(表示剪掉的参数个数)。

代码示例

import torch

import torch.nn.utils.prune as prune

import torch.nn as nn

# 定义一个简单的线性层

linear = nn.Linear(5, 3)

# 打印剪枝前的权重

print("Original weights:")

print(linear.weight)

# 随机进行非结构化剪枝

prune.random_unstructured(linear, name='weight', amount=0.5)

# 打印剪枝后的权重

print("Pruned weights:")

print(linear.weight)

# 打印掩码

print("Weight mask:")

print(linear.weight_mask)

3. torch.nn.utils.prune.ln_structured

按Ln范数对权重进行结构化剪枝,通常用于剪枝整个过滤器或神经元。

参数

module: 要剪枝的模块(如层)。name: 要剪枝的参数名称(如weight)。amount: 剪枝比例,可以是一个0到1之间的小数(表示剪掉的结构化块比例)或一个整数(表示剪掉的结构化块个数)。n: 范数的阶数,如2表示L2范数。dim: 进行结构化剪枝的维度,通常是0(剪掉通道)或1(剪掉过滤器)。

代码示例

import torch

import torch.nn.utils.prune as prune

import torch.nn as nn

# 定义一个简单的卷积层

conv = nn.Conv2d(1, 3, 3)

# 打印剪枝前的权重

print("Original weights:")

print(conv.weight)

# 按L2范数进行结构化剪枝,剪掉50%的过滤器

prune.ln_structured(conv, name='weight', amount=0.5, n=2, dim=0)

# 打印剪枝后的权重

print("Pruned weights:")

print(conv.weight)

# 打印掩码

print("Weight mask:")

print(conv.weight_mask)

4. torch.nn.utils.prune.remove

移除剪枝参数和掩码,恢复参数为剪枝后的状态。

参数

module: 已剪枝的模块(如层)。name: 剪枝的参数名称(如weight)。

代码示例

import torch

import torch.nn.utils.prune as prune

import torch.nn as nn

# 定义一个简单的线性层

linear = nn.Linear(5, 3)

# 执行剪枝

prune.l1_unstructured(linear, name='weight', amount=0.5)

# 移除剪枝参数和掩码

prune.remove(linear, 'weight')

# 打印移除剪枝后的权重

print("Weights after pruning removed:")

print(linear.weight)

5. torch.nn.utils.prune.custom_from_mask

使用自定义掩码进行剪枝。

参数

module: 要剪枝的模块(如层)。name: 要剪枝的参数名称(如weight)。mask: 自定义掩码,与要剪枝的参数形状相同。

代码示例

import torch

import torch.nn.utils.prune as prune

import torch.nn as nn

# 定义一个简单的线性层

linear = nn.Linear(5, 3)

# 自定义掩码

mask = torch.tensor([[1, 0, 1, 0, 1],

[0, 1, 0, 1, 0],

[1, 0, 1, 0, 1]], dtype=torch.uint8)

# 使用自定义掩码进行剪枝

prune.custom_from_mask(linear, name='weight', mask=mask)

# 打印剪枝后的权重

print("Pruned weights with custom mask:")

print(linear.weight)

# 打印掩码

print("Custom weight mask:")

print(linear.weight_mask)

总结

通过本文的讲解和代码示例,您应该对模型剪枝技术有了更全面的了解。模型剪枝是一种有效的模型压缩技术,可以显著减少模型的计算和存储需求。在实际应用中,需要根据具体需求选择合适的剪枝方法和剪枝比例,并通过微调恢复剪枝后的模型性能。通过合理的剪枝策略,可以在保持模型性能的同时,大幅提升模型的运行效率,适应资源受限的环境。PyTorch提供了丰富的剪枝工具和接口,方便开发者在实际项目中灵活应用这些技术。

![[笔记] SKF Enveloping FAQ 用户指南](https://i-blog.csdnimg.cn/direct/41784d03fd7d40c6a38b1c59510ce8dc.png)