在本篇技术博客中,我们将深入探索Apache Kafka 0.10.0.2版本中的消息生产与消费机制。Kafka作为一个分布式消息队列系统,以其高效的吞吐量、低延迟和高可扩展性,在大数据处理和实时数据流处理领域扮演着至关重要的角色。了解如何在这一特定版本中实现消息的高效传输和处理,对于构建健壮的数据管道至关重要。

一、Kafka基础回顾

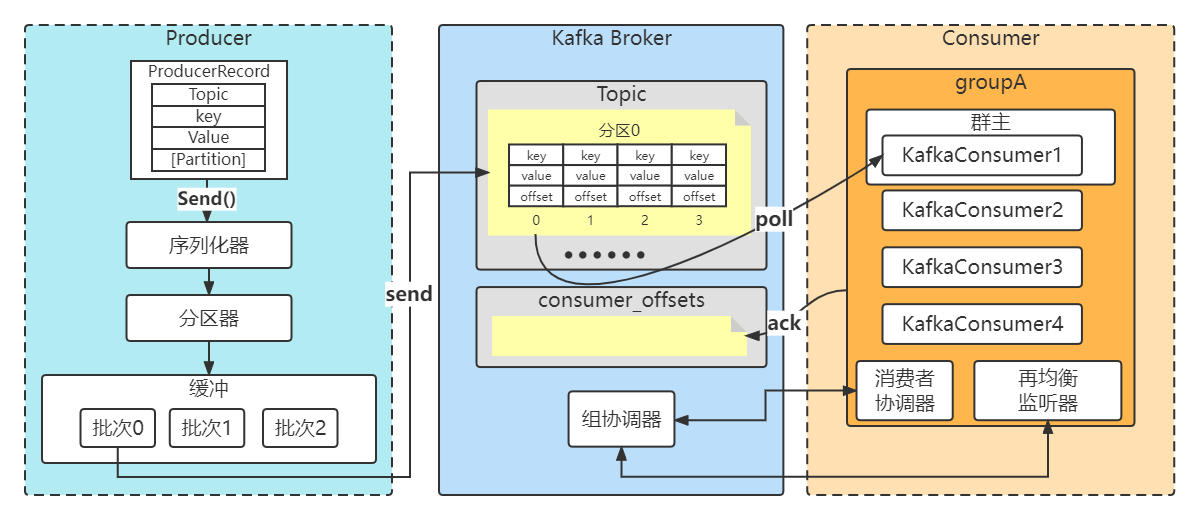

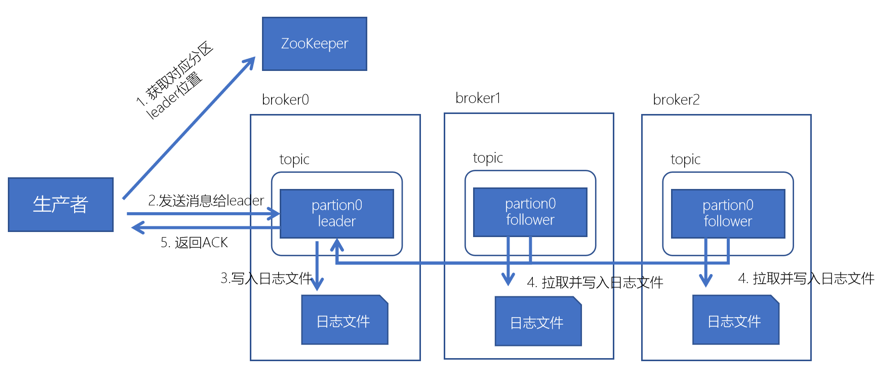

在深入生产与消费之前,让我们快速回顾一下Kafka的核心概念和架构。Kafka由Brokers、Topics、Partitions、Producers和Consumers组成。每个Broker是一个独立的服务器,负责存储和转发消息;Topic是消息的分类,每个Topic可以分为多个Partitions以实现水平扩展;Producer负责向特定的Topic发送消息;Consumer则从Topic中拉取消息进行处理。

二、Kafka 0.10.0.2生产者详解

2.1 生产者配置与初始化

在Kafka 0.10.0.2版本中,生产者配置变得更为灵活。生产者需要配置bootstrap.servers来指定Kafka集群的地址,acks来控制消息确认策略,以及其他如retries、batch.size、linger.ms等参数来优化性能和可靠性。

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

public class KafkaProducerExample {

public static void main(String[] args) {

// 配置生产者

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092"); // Kafka集群地址

props.put("acks", "all"); // 所有副本必须确认接收到消息

props.put("retries", 0); // 重试次数

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// 创建KafkaProducer实例

Producer<String, String> producer = new KafkaProducer<>(props);

// 发送消息

for(int i = 0; i < 100; i++) {

ProducerRecord<String, String> record = new ProducerRecord<>("my-topic", "key-" + i, "message-" + i);

producer.send(record);

}

// 关闭生产者

producer.close();

}

}2.2 消息发送与事务支持

Kafka 0.10.0.2引入了对幂等性和事务的支持,这是生产者端的重大改进。幂等性确保了多次发送相同消息至同一Partition时,只会有一次被写入,这对于网络重试场景特别有用。而事务则允许跨多个Partition或Topic的操作具备原子性,这对于需要严格顺序和一致性的场景至关重要。

producer.initTransactions();

try {

producer.beginTransaction();

producer.send(new ProducerRecord<>("my-topic", "key", "value"));

producer.commitTransaction();

} catch (ProducerFencedException | OutOfOrderSequenceException | AuthorizationException e) {

// 处理异常

} finally {

producer.close();

}三、Kafka 0.10.0.2消费者详解

3.1 新一代消费者API

Kafka 0.10.0.2版本中,消费者API经历了重大重构,引入了新的Consumer API,它摒弃了旧API对ZooKeeper的依赖,转而直接与Kafka Brokers通信,提高了容错性和性能。

3.2 消费者配置与组管理

配置消费者时,需指定group.id来定义消费者所属的消费者组,enable.auto.commit控制自动提交偏移量,以及auto.offset.reset来决定当没有初始偏移量或偏移量无效时如何处理。

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.Arrays;

import java.util.Properties;

public class KafkaConsumerExample {

public static void main(String[] args) {

// 配置消费者

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092"); // Kafka集群地址

props.put("group.id", "test-group"); // 消费者组ID

props.put("enable.auto.commit", "true"); // 开启自动提交偏移量

props.put("auto.commit.interval.ms", "1000"); // 自动提交间隔

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

// 创建KafkaConsumer实例

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 订阅主题

consumer.subscribe(Arrays.asList("my-topic"));

// 消费消息

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100)); // 拉取消息

for (ConsumerRecord<String, String> record : records) {

System.out.printf("offset = %d, key = %s, value = %s%n", record.offset(), record.key(), record.value());

}

}

}

}3.3 消息消费与偏移量管理

消费者通过poll()方法拉取消息,需关注max.poll.records配置来限制每次调用返回的最大记录数。Kafka支持手动和自动两种偏移量提交模式,手动模式给予开发者更多的控制权,自动模式则简化了使用。

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records)

System.out.printf("offset = %d, key = %s, value = %s%n", record.offset(), record.key(), record.value());

consumer.commitAsync();

}四、性能优化与最佳实践

4.1 生产者优化

批处理:通过调整

batch.size和linger.ms参数,可以提高消息发送的效率。压缩:启用消息压缩(如gzip、snappy)可以减少网络传输开销,但需权衡压缩和解压缩的CPU成本。

4.2 消费者优化

合理的分区分配:确保消费者组内的消费者数量与Topic的分区数相匹配,避免资源浪费或负载不均。

偏移量管理:根据业务需求选择合适的偏移量提交策略,确保消息不丢失也不重复消费。

五、总结

在Kafka 0.10.0.2版本中,生产者和消费者的增强功能不仅提高了消息处理的可靠性和效率,也为开发者提供了更多灵活性和控制权。通过深入理解生产消费机制,结合合理的配置和最佳实践,可以构建出高效稳定的数据传输管道。尽管随着时间推移,Kafka有了更先进的版本,但0.10.0.2版本仍被广泛应用于遗留系统和特定场景中,其核心概念和机制的学习对于理解和掌握Kafka的演进路径具有重要意义。