CogVLM & CogAgent 下载地址

CogVLM & CogAgent 的 Github 官方仓库:https://github.com/THUDM/CogVLM

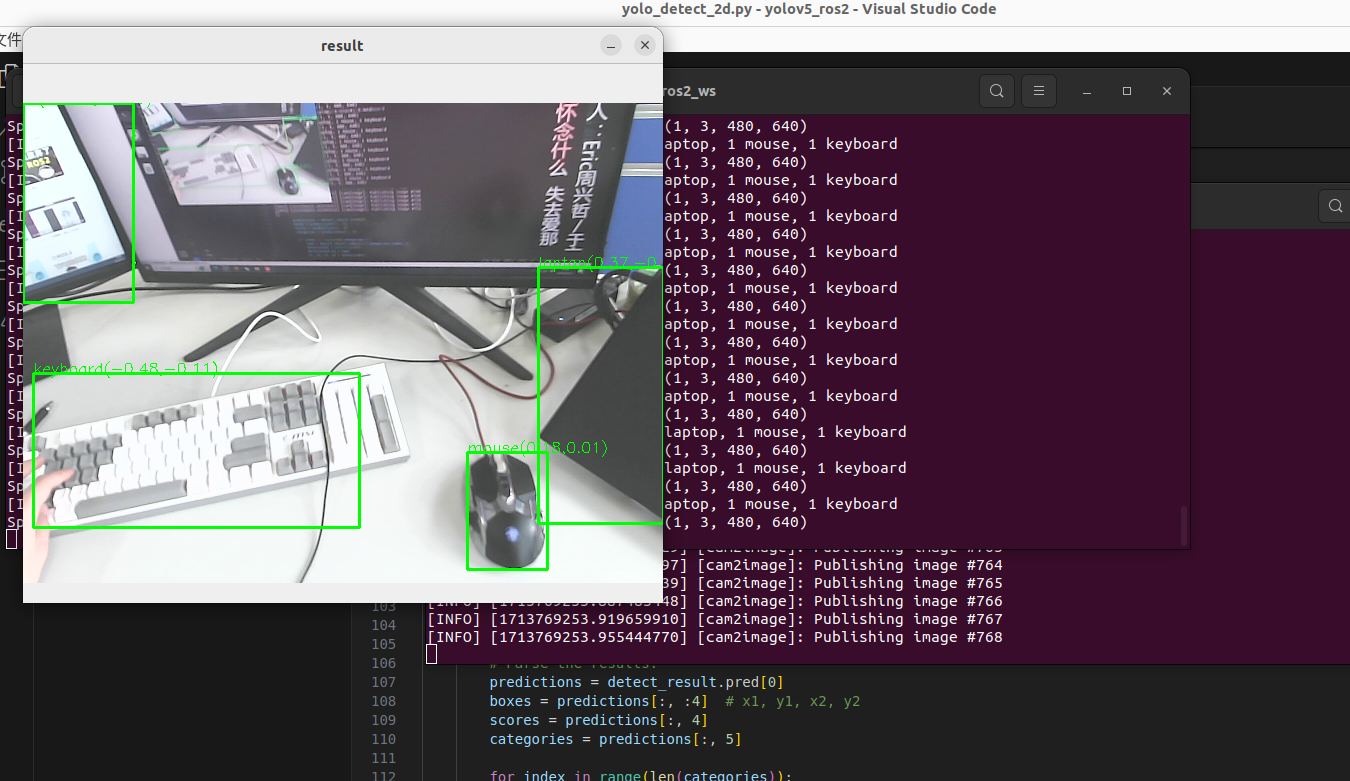

只是完成传统CV任务中例如目标检测,定位, VQA 任务,我们CogVLM模型就可以胜任任务

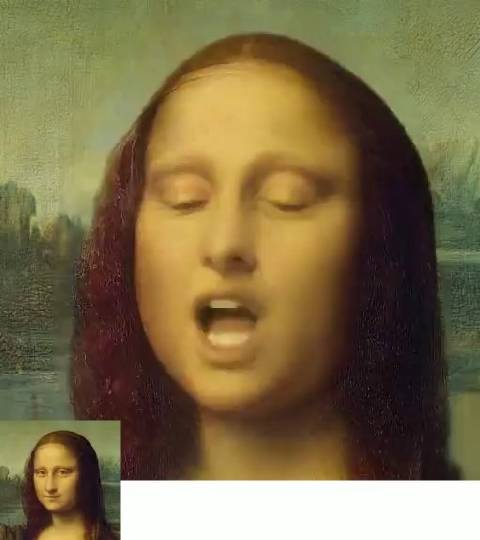

需要完成多模态的指令任务,例如 跨模态指令,图文指导,工具调用任务,我们推荐使用CogAgent模型

如下测试:

OpenXLab 模型下载 ModelScope 魔塔社区

源码安装

从 Swanhub 下载源码

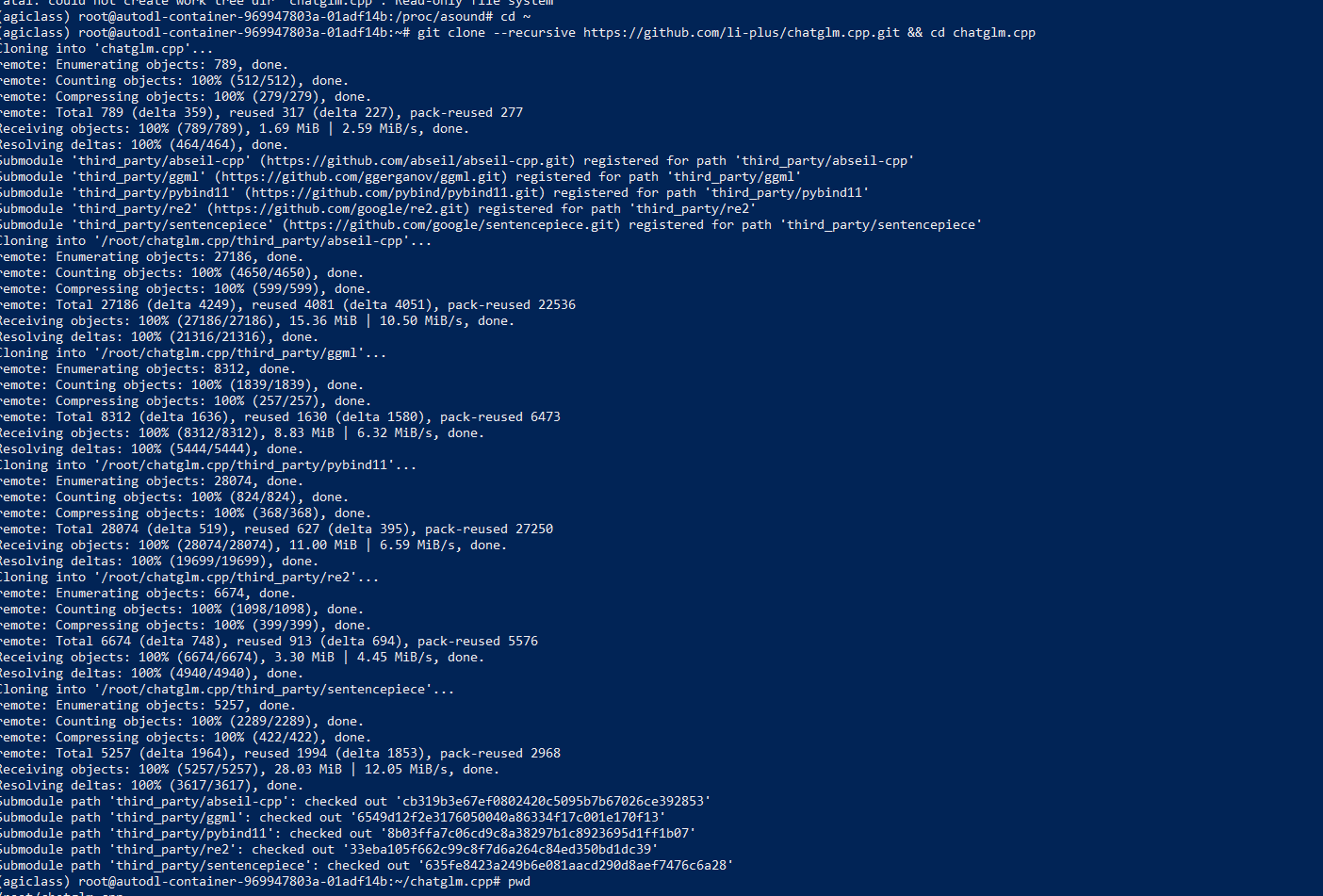

git clone https://swanhub.co/ZhipuAI/CogVLM.git开发者可以通过以下方式下载模型文件

下载模型文件前请先确保`git lfs`命令已安装,安装教程请参考这里。

模型文件已上传至 Huggingface, Modelsope , SwanHub 三个平台,用户可以快速安装模型。

若使用 Modelscope 下载模型

git lfs install

# CogVLM

git clone https://www.modelscope.cn/ZhipuAI/cogvlm-chat.git

# CogAgent

git clone https://www.modelscope.cn/ZhipuAI/cogagent-chat.git若使用 SwanHub 下载模型

git lfs install

# CogVLM

git clone https://swanhub.co/ZhipuAI/cogvlm-chat.git

# CogAgent

git clone https://swanhub.co/ZhipuAI/cogagent-chat-hf.git安装依赖

使用 pip 安装依赖:

cd CogVLM

pip install -r requirements.txt

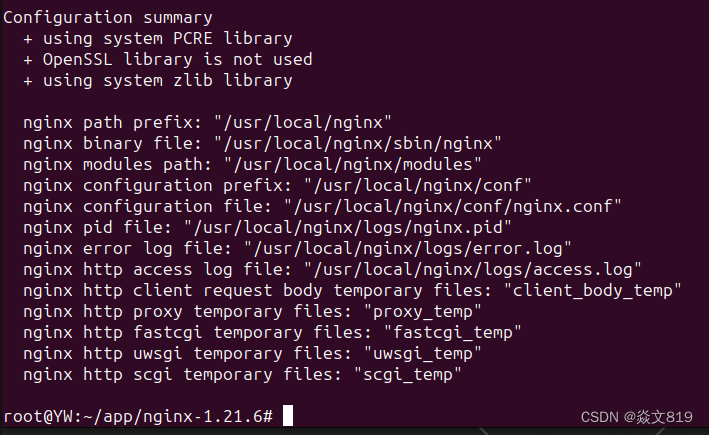

python -m spacy download en_core_web_sm如果配置不满足最低配置,你可以访问环境配置和检查获取更多信息

运行demo

使用我们提供的命令行交互来完成命令行与 CogAgent & CogVLM 的对话。

在python basic_demo/cli_demo_hf.py中运行代码

# CogAgent

python cli_demo_hf.py --from_pretrained THUDM/cogagent-chat-hf --bf16

python cli_demo_hf.py --from_pretrained THUDM/cogagent-vqa-hf --bf16

# CogVLM

python cli_demo_hf.py --from_pretrained THUDM/cogvlm-chat-hf --bf16

python cli_demo_hf.py --from_pretrained THUDM/cogvlm-grounding-generalist --bf16如果你使用的是sat模型,请使用cli_demo_sat.py来完整这个步骤

# CogAgent

python cli_demo_hf.py --from_pretrained THUDM/cogagent-chat-hf --bf16

python cli_demo_hf.py --from_pretrained THUDM/cogagent-vqa-hf --bf16

# CogVLM

python cli_demo_hf.py --from_pretrained THUDM/cogvlm-chat-hf --bf16

python cli_demo_hf.py --from_pretrained THUDM/cogvlm-grounding-generalist --bf16运行 WebDemo (使用官方在线DEMO)

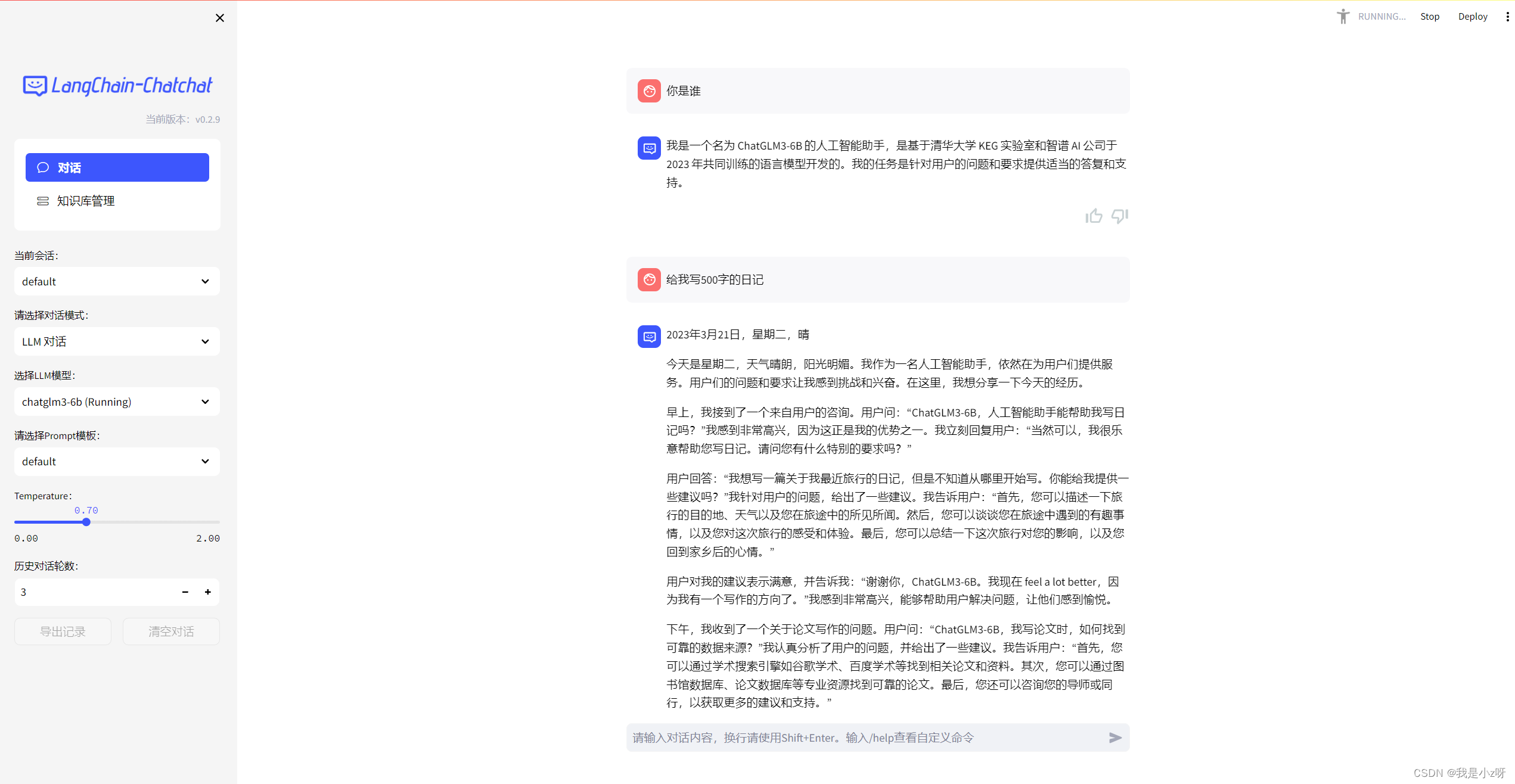

在本仓库中,我们为开发者提供了一个可以直接运行的完整 Web Demo。

用户可以直接在Web Demo中可视化的与模型进行交互。

启动代码

首先,按照要求下载必须的配置。

pip install -r composite_demo/requirements.txt接着,在composite_demo/client.py中将修改以下代码

# 将这两行替换为你模型的实际位置

MODEL_PATH = os.environ.get('MODEL_PATH', 'your cogagent-chat-hf path')

TOKENIZER_PATH = os.environ.get('TOKENIZER_PATH', 'your vicuna-7b-v1.5 path')接着,运行代码

streamlit run composite_demo/main.py