1.创建文件夹

hdfs -dfs -mkdir -p /opt/mydoc

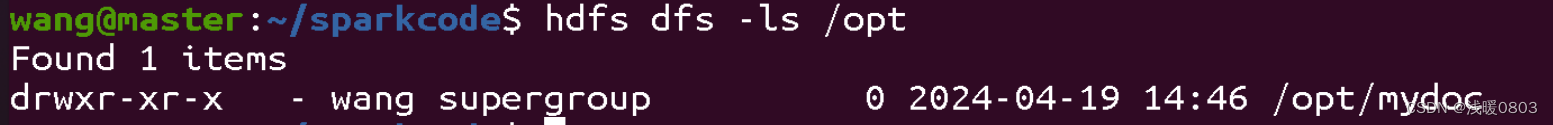

2.查看创建的文件夹

hdfs -dfs -ls /opt

注意改文件夹是创建在hdfs中的,不是本地,查看本地/opt,并没有该文件夹。

3.上传文件

hdfs dfs -put -f file:///usr/local/testspark.txt hdfs://master:9000/opt/mydoc

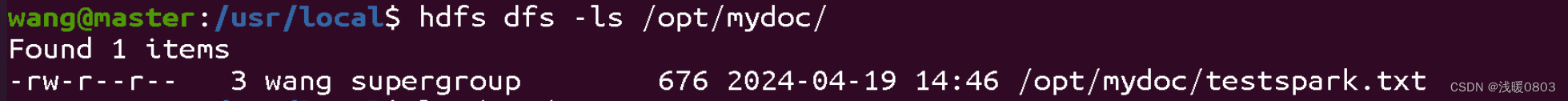

4.查看上传的文件

hdfs dfs -ls /opt/mydoc

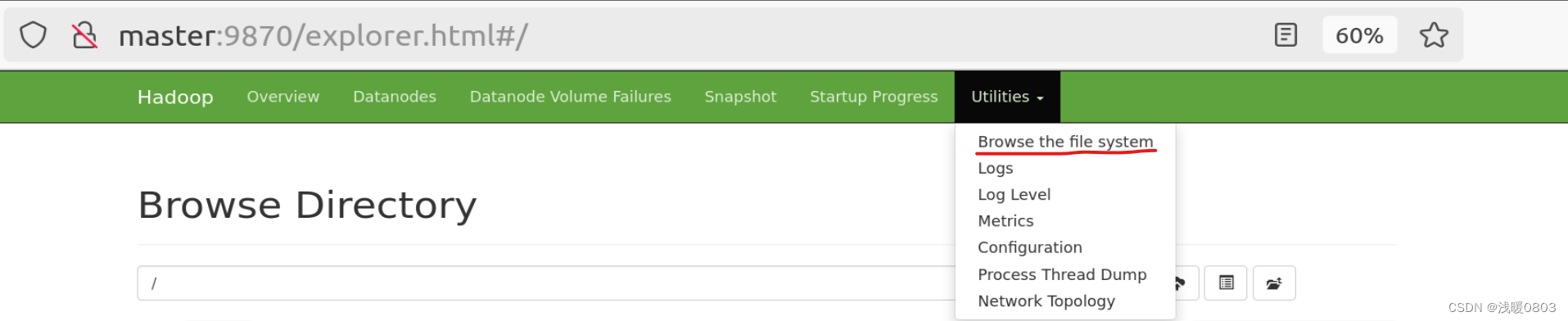

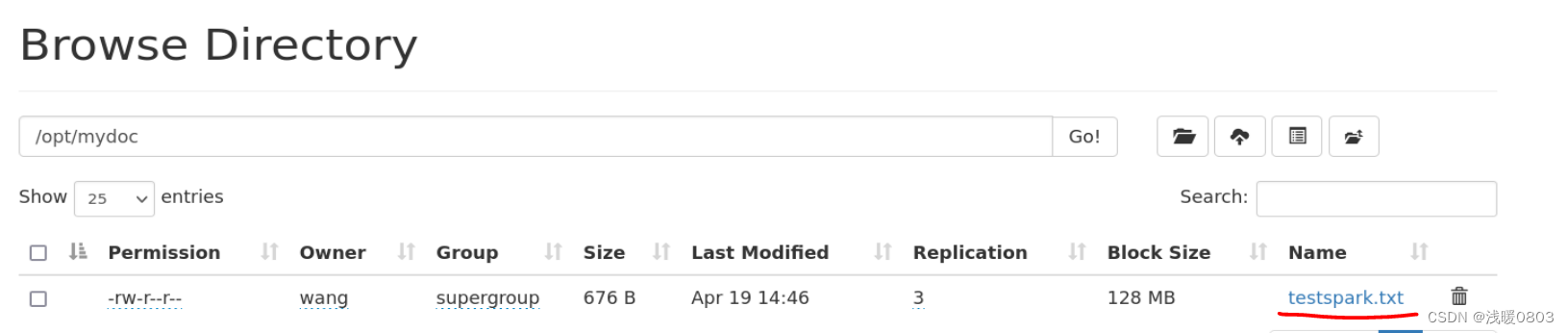

也可以在浏览器中查看

5.遇到的问题

5.遇到的问题

mkdir: ‘/opt/mydoc‘: Input/output error

应该是hdfs配置的问题,一开始在安装spark环境时没有配置hadoop相关文件,参考Spark Standalone模式部署-CSDN博客第三章,安装配置好hadoop并启动,再次执行上述命令时,成功。