【背景】

还是继续致力于实践可以保护数据隐私的本地化LLM部署。

这次用的是Llama 2 + GPT4All + Chroma实现RAG。

【概念】

基于LangChain模板的各个部分的作用:

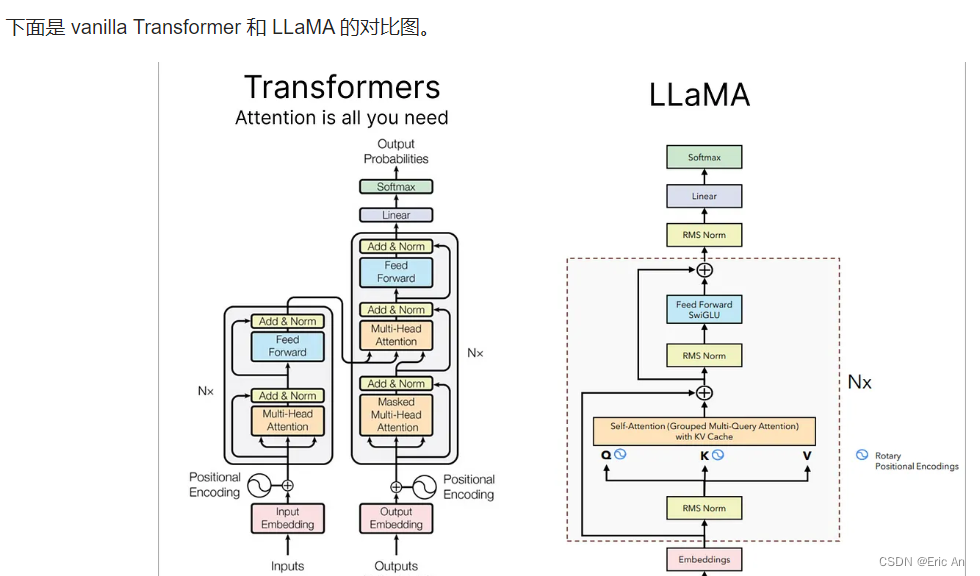

- Llama2-》语言模型管理

- GPT4ALL-》embedding

- Chroma-》文件内容的向量存储,作为内部知识库,不需要网络就可以存储。

【环境构建】

- 安装Ollama

在Linux或Windows的WSL下,使用命令:

curl https://ollama.ai/install.sh | sh

- 利用Ollama下载一款LLM模型

比如,下载一个llama2 7b chat模型:

ollama pull llama2:7b-chat

- 安装LangChain命令行工具CLI:

pip install -U langchain-cli