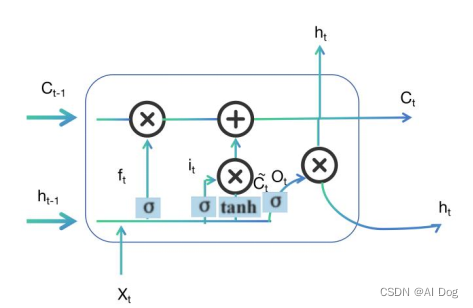

LSTM(Long Short-Term Memory)是一种特殊的循环神经网络(RNN),它能够学习长期依赖关系,非常适合处理和预测时间序列数据。在Python中,可以使用`keras`库(现在是`tensorflow`的一部分)来构建LSTM模型。以下是一个简单的LSTM时间序列预测模型的实现示例:

```python

import numpy as np

import pandas as pd

from keras.models import Sequential

from keras.layers import LSTM, Dense

from sklearn.preprocessing import MinMaxScaler

from sklearn.metrics import mean_squared_error

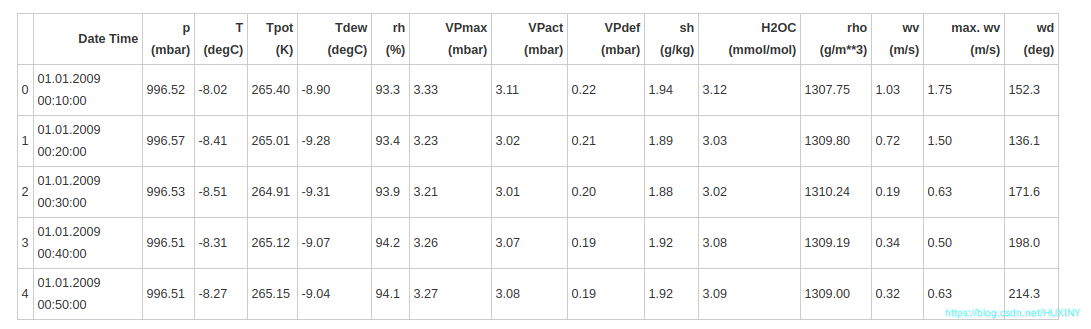

# 假设你有一个Pandas DataFrame,包含一个单一的时间序列数据

# df = pd.read_csv('your_timeseries_data.csv')

# 将数据转换为适合LSTM输入的格式

# 假设我们的目标是预测下一个值,所以我们将数据窗口设置为1

def create_dataset(data, look_back=1):

X, Y = [], []

for i in range(len(data) - look_back - 1):

a = data[i:(i + look_back), 0]

X.append(a)

Y.append(data[i + look_back, 0])

return np.array(X), np.array(Y)

# 确定数据的look_back值,即LSTM的输入窗口大小

look_back = 1

# 准备数据集

train_size = int(len(df) * 0.67)

test_size = len(df) - train_size

train, test = df[0:train_size], df[train_size:len(df)]

# 标准化数据

scaler = MinMaxScaler(feature_range=(0, 1))

train_scaled = scaler.fit_transform(train)

test_scaled = scaler.transform(test)

# 创建LSTM的数据集

X_train, Y_train = create_dataset(train_scaled, look_back)

X_test, Y_test = create_dataset(test_scaled, look_back)

# 重塑X_train和X_test以适应LSTM的输入要求

X_train = np.reshape(X_train, (X_train.shape[0], X_train.shape[1], 1))

X_test = np.reshape(X_test, (X_test.shape[0], X_test.shape[1], 1))

# 创建LSTM模型

model = Sequential()

model.add(LSTM(4, input_shape=(X_train.shape[1], 1)))

model.add(Dense(1))

# 编译模型

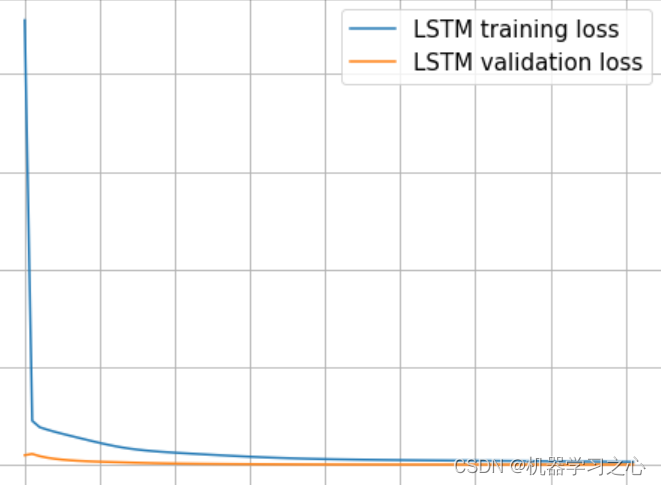

model.compile(loss='mean_squared_error', optimizer='adam')

# 训练模型

model.fit(X_train, Y_train, epochs=100, batch_size=1, verbose=2)

# 进行预测

Y_train_pred = model.predict(X_train)

Y_test_pred = model.predict(X_test)

# 反标准化预测结果

Y_train_pred = scaler.inverse_transform(Y_train_pred)

Y_test_pred = scaler.inverse_transform(Y_test_pred)

# 计算测试集的均方误差

test_loss = mean_squared_error(Y_test, Y_test_pred)

print(f'Test MSE: {test_loss}')

```

在上述代码中,我们首先将时间序列数据转换为LSTM模型可以接受的格式,即创建了一系列的窗口数据。然后,我们使用`MinMaxScaler`对数据进行标准化处理。接下来,我们创建了一个简单的LSTM模型,其中包含一个LSTM层和一个全连接层。我们使用`mean_squared_error`作为损失函数,`adam`作为优化器,并训练了模型。最后,我们对训练集和测试集进行了预测,并计算了测试集上的均方误差。

请注意,这只是一个基本的LSTM模型示例。在实际应用中,可能需要调整LSTM层的神经元数量、增加更多的层、调整学习率和其他超参数,以及进行更复杂的数据预处理和特征工程来提高模型的性能。此外,根据问题的具体情况,可能需要使用更复杂的时间序列分割方法,例如使用滚动窗口或扩展窗口来创建训练和测试集。