今天又来给大家推荐一本大模型方面的书籍<GPT图解:大模型是怎样构建的>本书将以生动活泼的笔触,将枯燥的技术细节化作轻松幽默的故事和缤纷多彩的图画,引领读者穿梭于不同技术的时空,见证自然语言处理技术的传承、演进与蜕变。

在这本书里,黄佳老师将带领读者踏上一段扣人心弦的探索之旅,了解ChatGPT的前世今生,并能动手从0到1搭建语言模型。

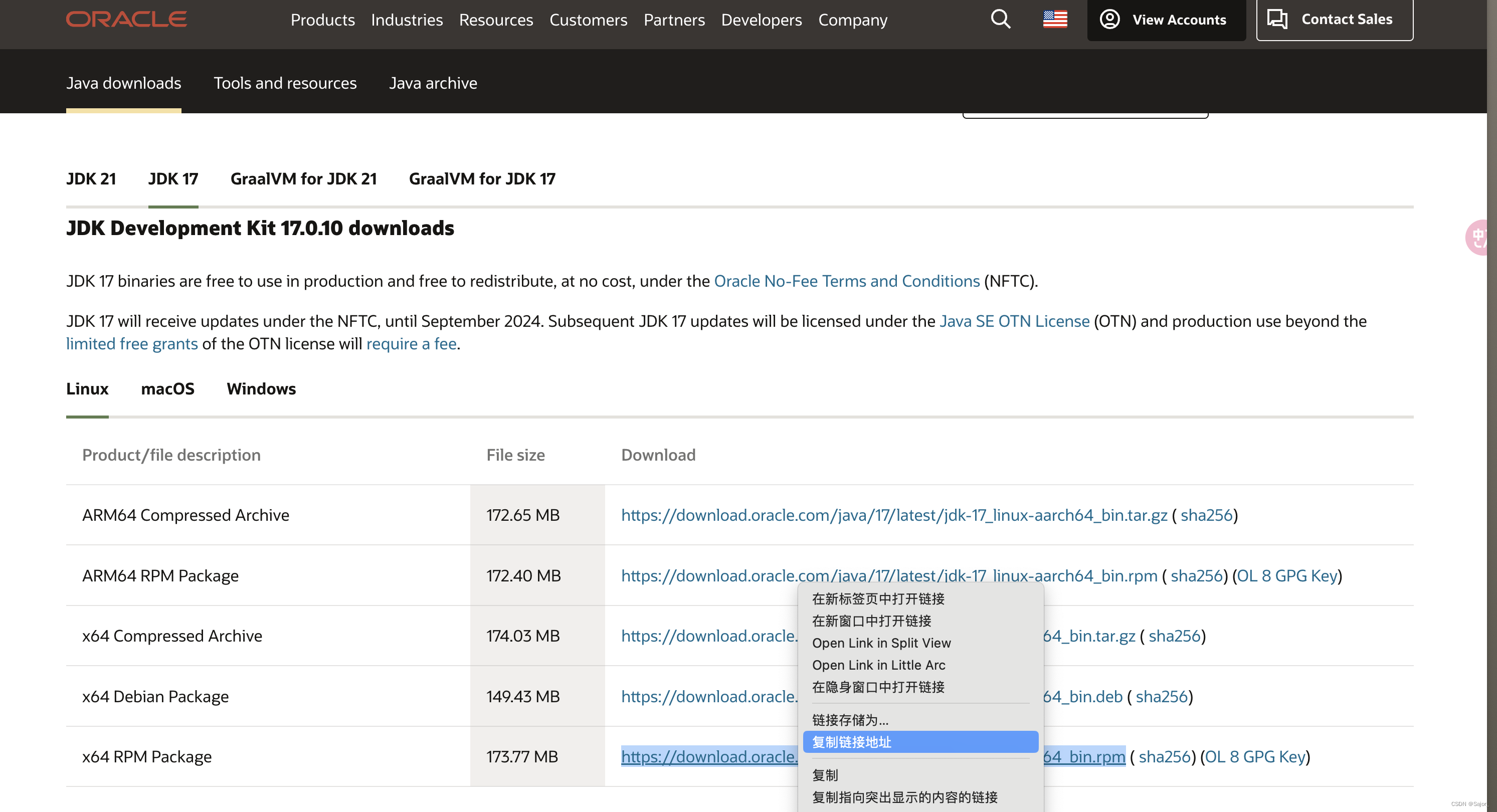

下载当前版本: 完整版本链接获取 地址点击

👉[CSDN大礼包🎁:<GPT图解:大模型是怎样构建的> PDF 免费分享 点击免费获取)]

👈

😝有需要的小伙伴,可以V扫描下方二维码免费领取==🆓

目录:

序章 看似寻常最奇崛,成如容易却艰辛

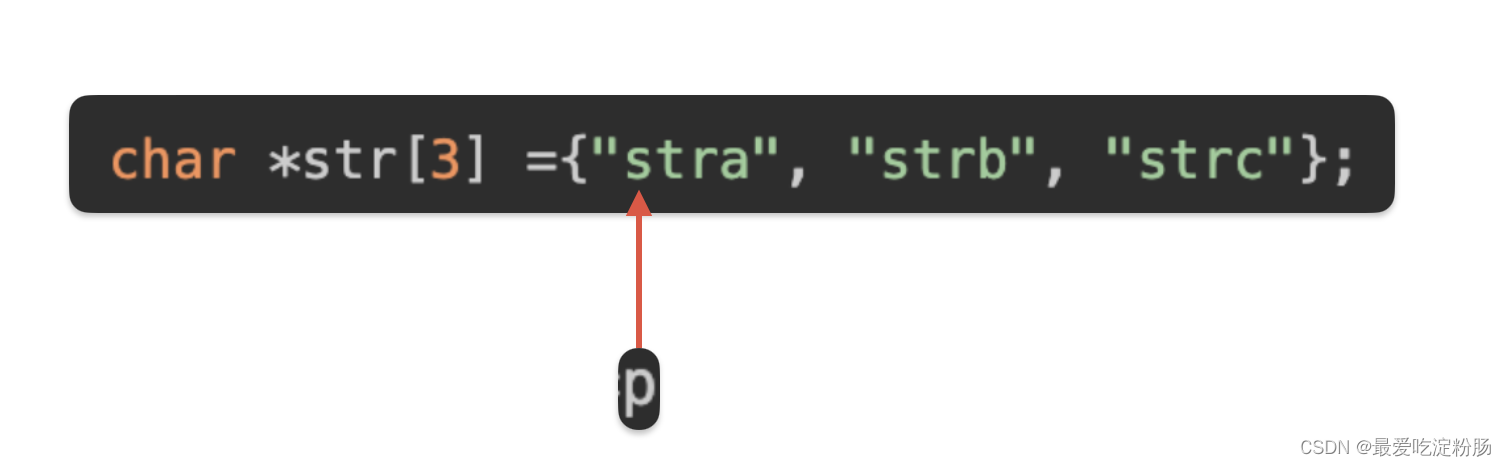

第 1 课 高楼万丈平地起:语言模型的雏形 N-Gram 和简单文本表示 Bag-of-Words

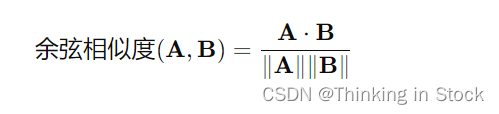

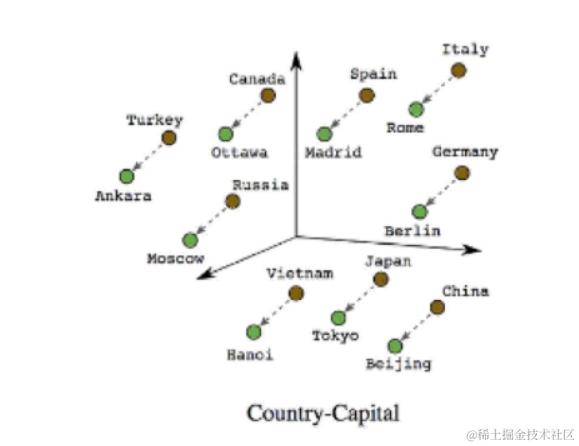

第 2 课 问君文本何所似:词的向量表示 Word2Vec 和 Embedding

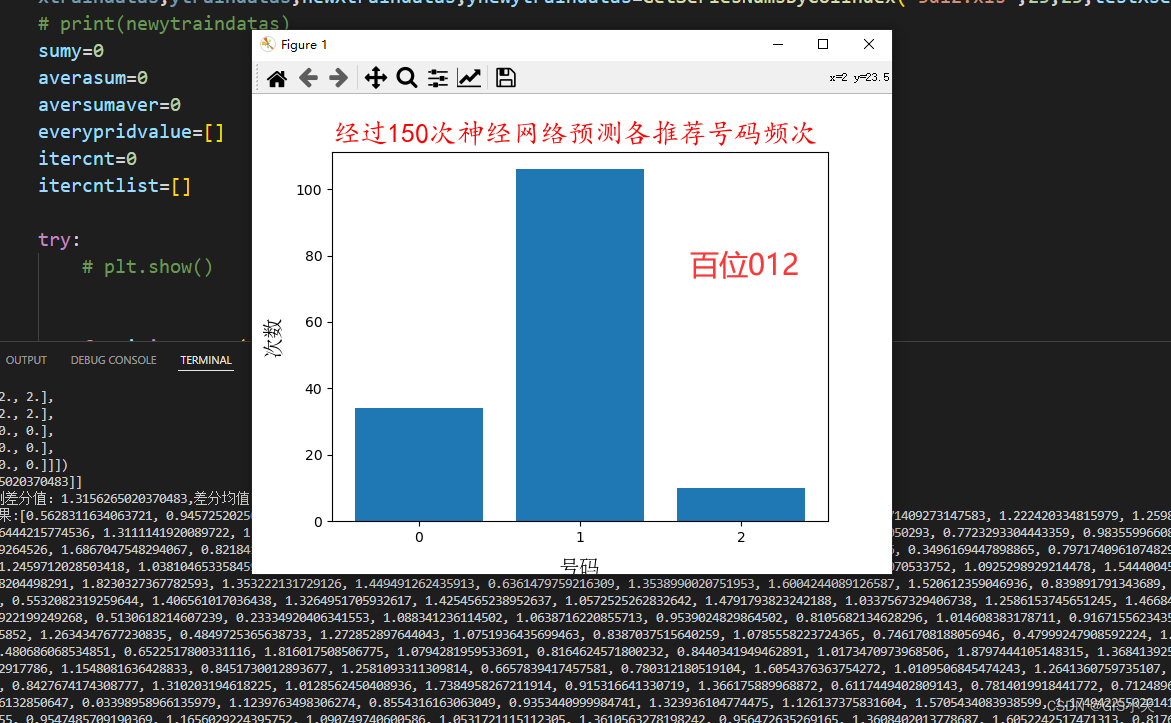

第 3 课 山重水复疑无路:神经概率语言模型和循环神经网络

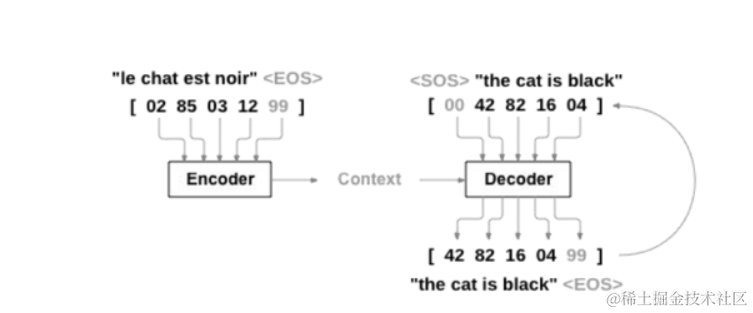

第 4 课 柳暗花明又一村:Seq2Seq 编码器 - 解码器架构

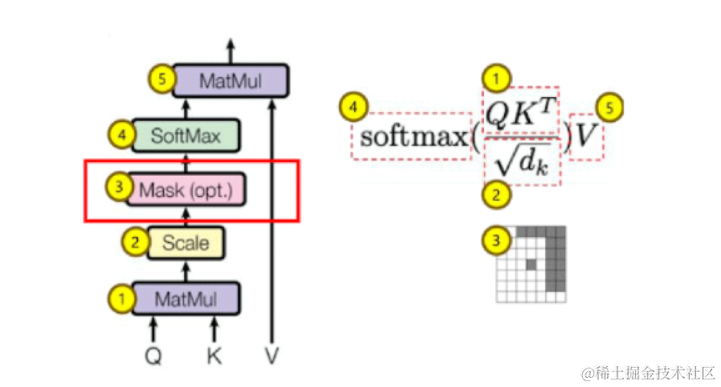

第 5 课 见微知著开慧眼:引入注意力机制

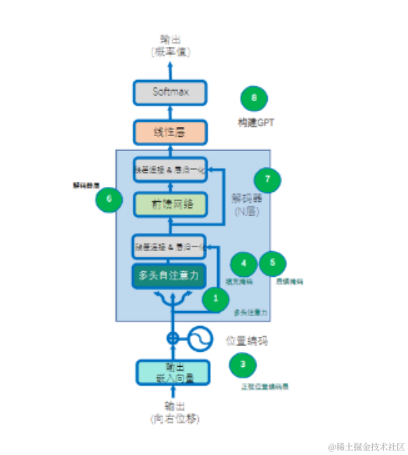

第 6 课 层峦叠翠上青天:搭建 GPT 核心组件 Transformer

第 7 课 芳林新叶催陈叶:训练出你的简版生成式 GPT

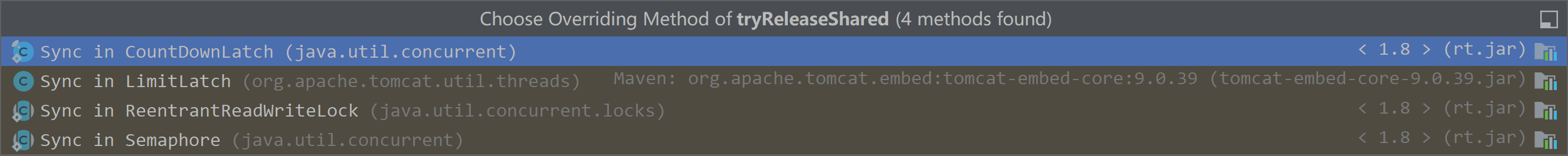

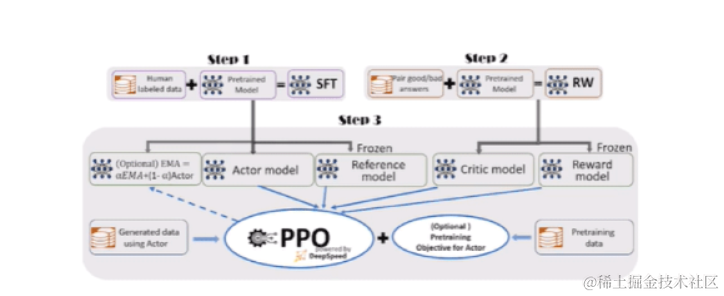

第8课 流水后波推前波:ChatGPT基于人类反馈的强化学习

第9课 生生不息的循环:使用强大的GPT-4 API

后 记 莫等闲,白了少年头

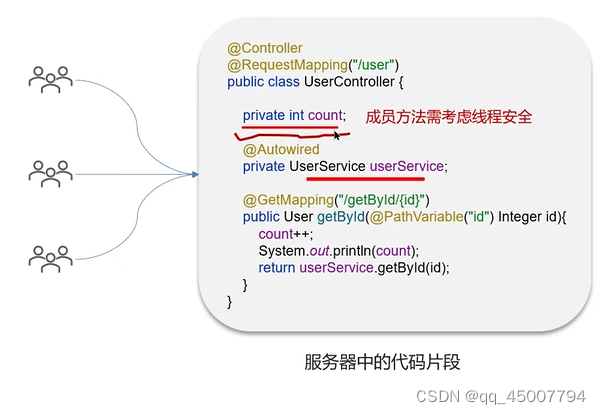

黄佳老师会在书中根据技术发展的脉络讲解多个实战项目,以生动活泼的笔触将枯燥的技术细节化作轻松幽默的故事和缤纷多彩的图画,一步一代码加注释手把手教学读者进行实战。

项目一:N-Gram构建

项目二:Word2Vec构建

项目三:NPLM(Neural Probabilistic Language Model)构建

项目四:Seq2Seq架构

项目五:注意力机制

项目六:Transformer架构

项目七:WikiGPT

项目八:miniChatGPT

下载当前版本: 完整版本链接获取 地址点击

👉[CSDN大礼包🎁:<GPT图解:大模型是怎样构建的> PDF 免费分享 点击免费获取)]

👈

😝有需要的小伙伴,可以V扫描下方二维码免费领取==🆓