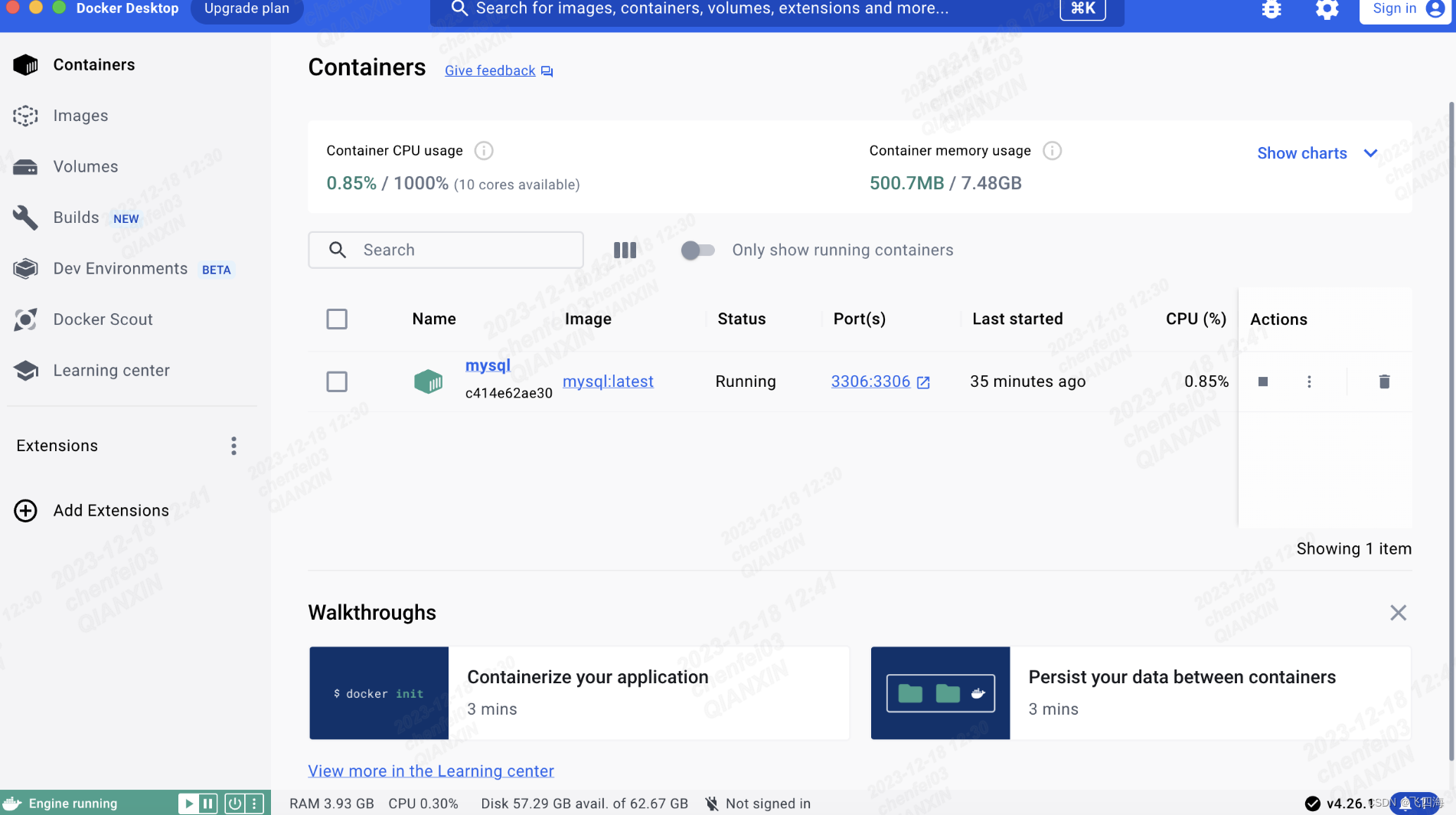

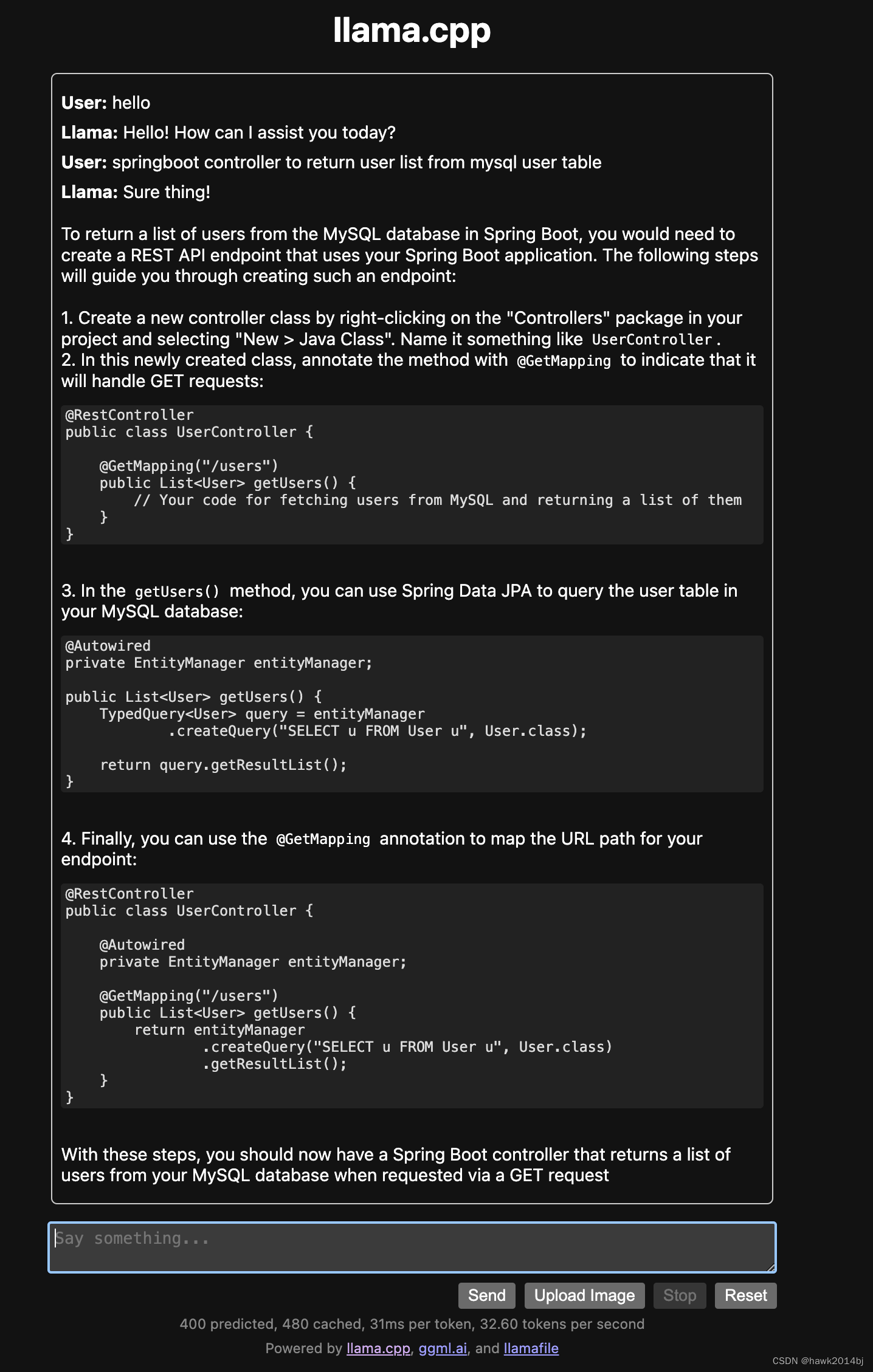

安装llamafile很简单,进入官网,按照步骤安装运行即可。

https://github.com/Mozilla-Ocho/llamafile

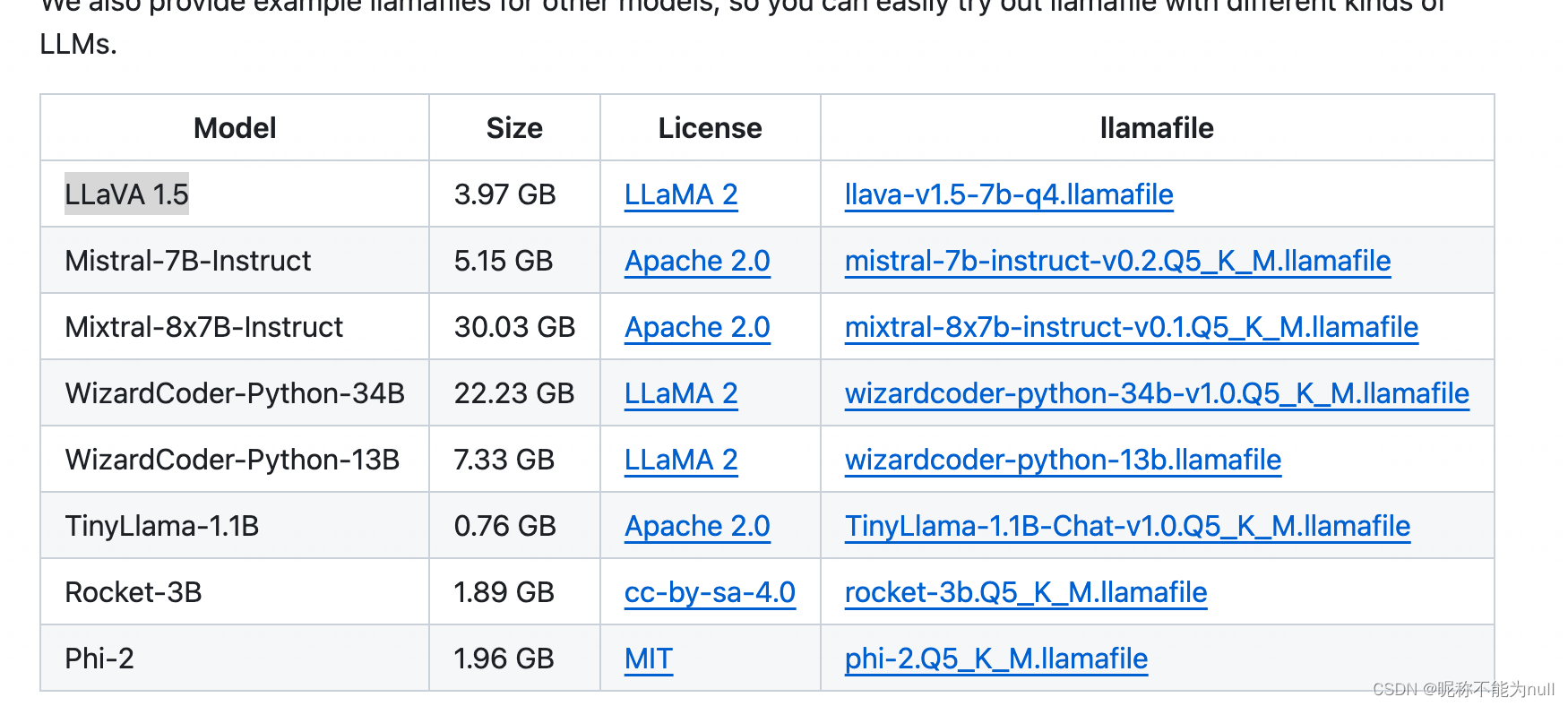

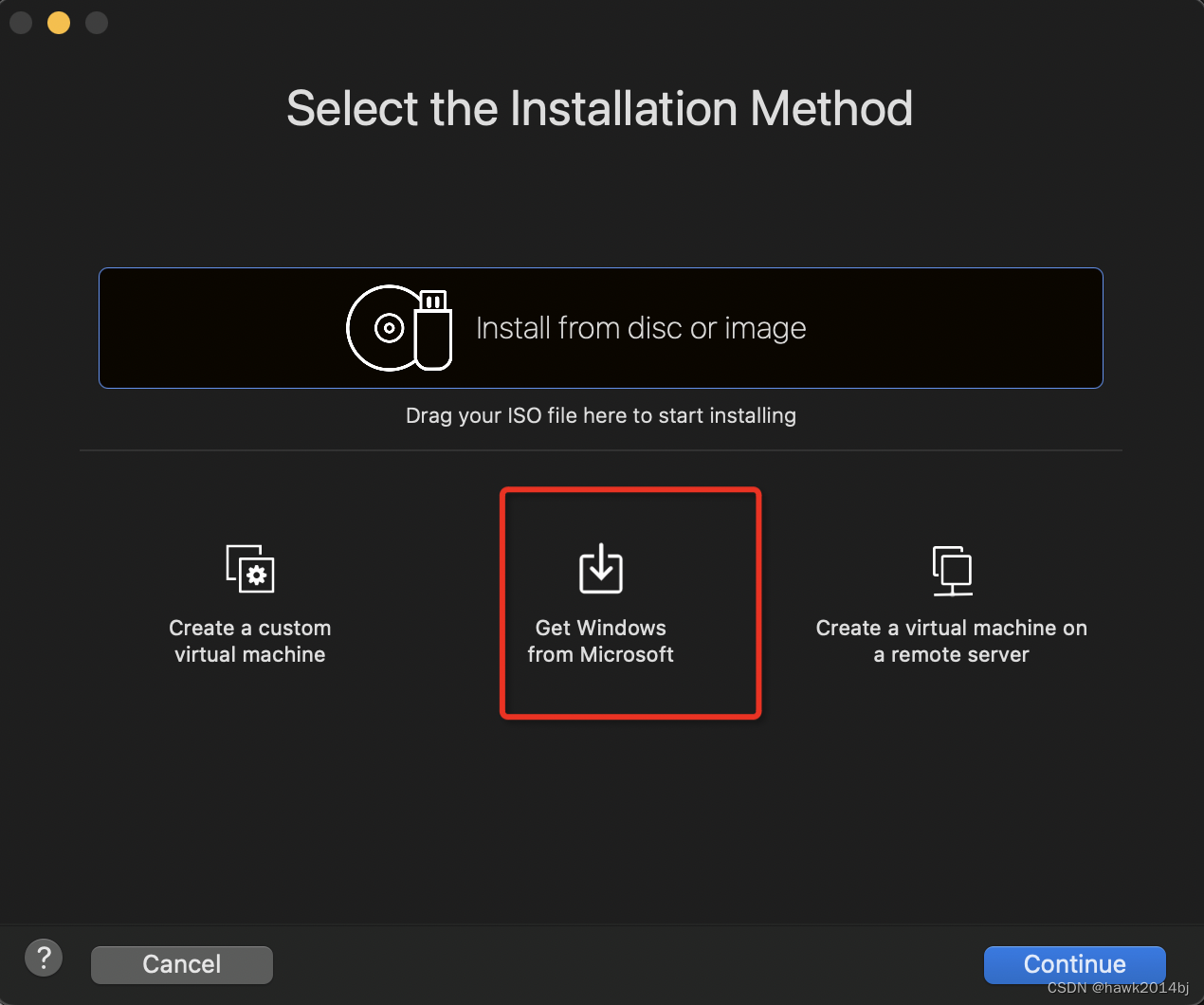

- 下载 llava-v1.5-7b-q4.llamafile

- 赋予运行权限chmod +x llava-v1.5-7b-q4.llamafile

- 运行 ./llava-v1.5-7b-q4.llamafile -ngl 9999

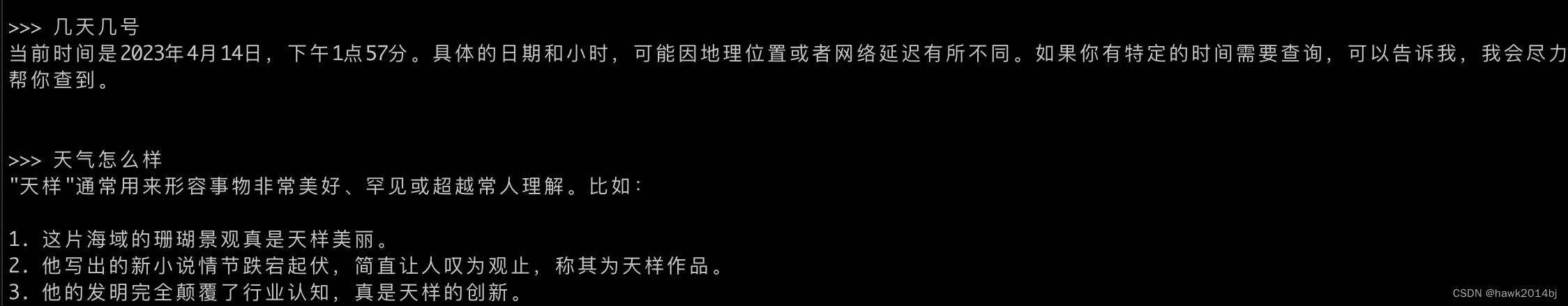

速度确实是比 ollama 快,ollama 用 qwen 1.5 7B 的模型。llamafile运行的是LLaVA 1.5,也是 7B 模型。下次试试能不能把 qwen 模型接入。

运行时遇到了一个问题

the cpu feature AVX was required at build time but isn’t available on this system,解决这个问题,首先用 arm64 的 shell,然后用 root 启动 llamafile。

arch -arm64 sh

su

./llava-v1.5-7b-q4.llamafile -ngl 9999