2024 NVIDIA GTC,发布了地表最强的GPU B200,同时,黄仁勋对谈《Attention is All You Need》论文其中的7位作者,座谈的目的无非就是诉说,Transformer才是今天人工智能成功的核心关键,它上面承载着大模型的运转,下面承载着对训练和推理芯片的要求。

1、Introduction

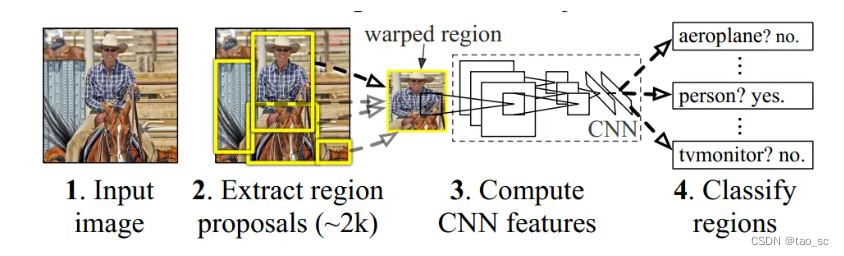

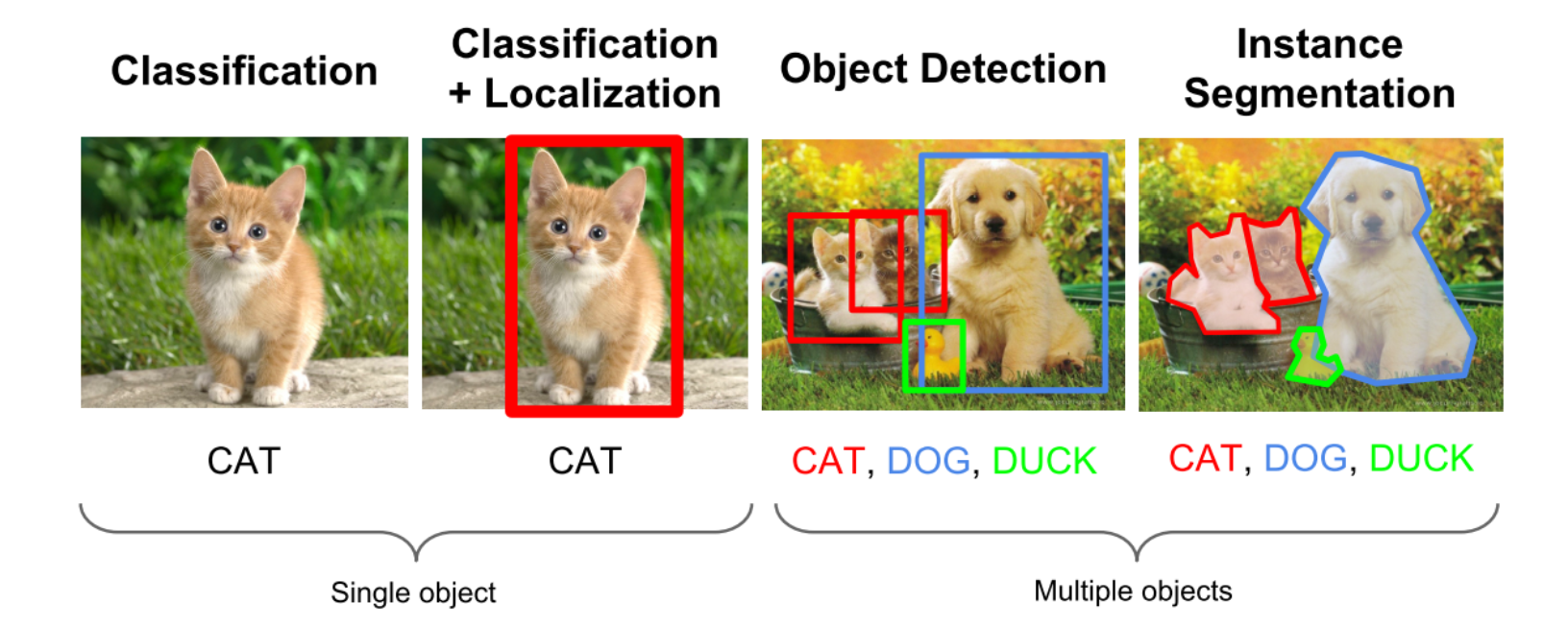

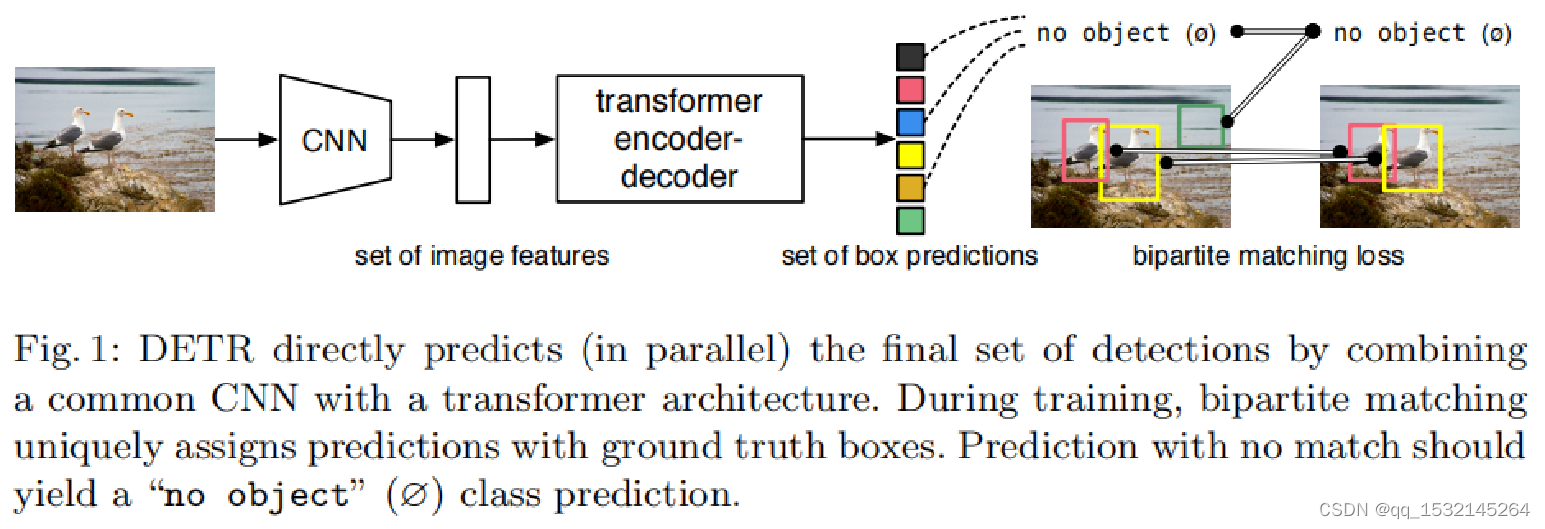

DETR 的开创性主要体现不需要像Faster R-CNN、YOLO等目标检测算法那样,生成大量的预测框,然后再通过NMS非极大值抑制方法处理冗余的预测框。

而是,利用 Transformer 全局建模的能力,把目标检测看成集合预测(给定一张图片,返回一个集合,其中包括每个框的坐标,以及框中物体的类别)的问题。

2、DETR architecture

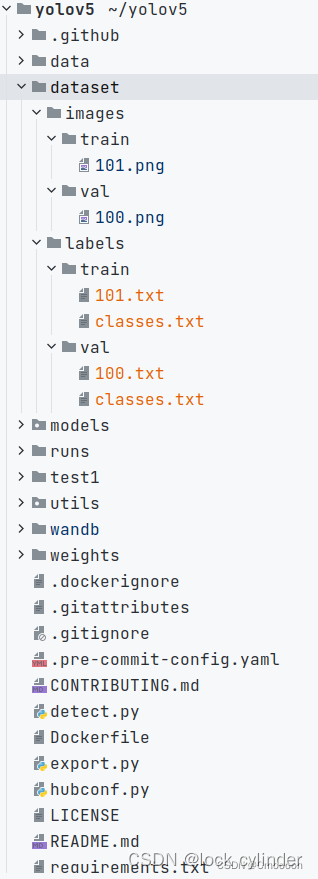

首先,图像经过CNN提取图像特征,再经过 Transformer Encoder 学习全局特征,让 Decoder 预测出检测结果,最后,将置信度大的目标作为检测结果。

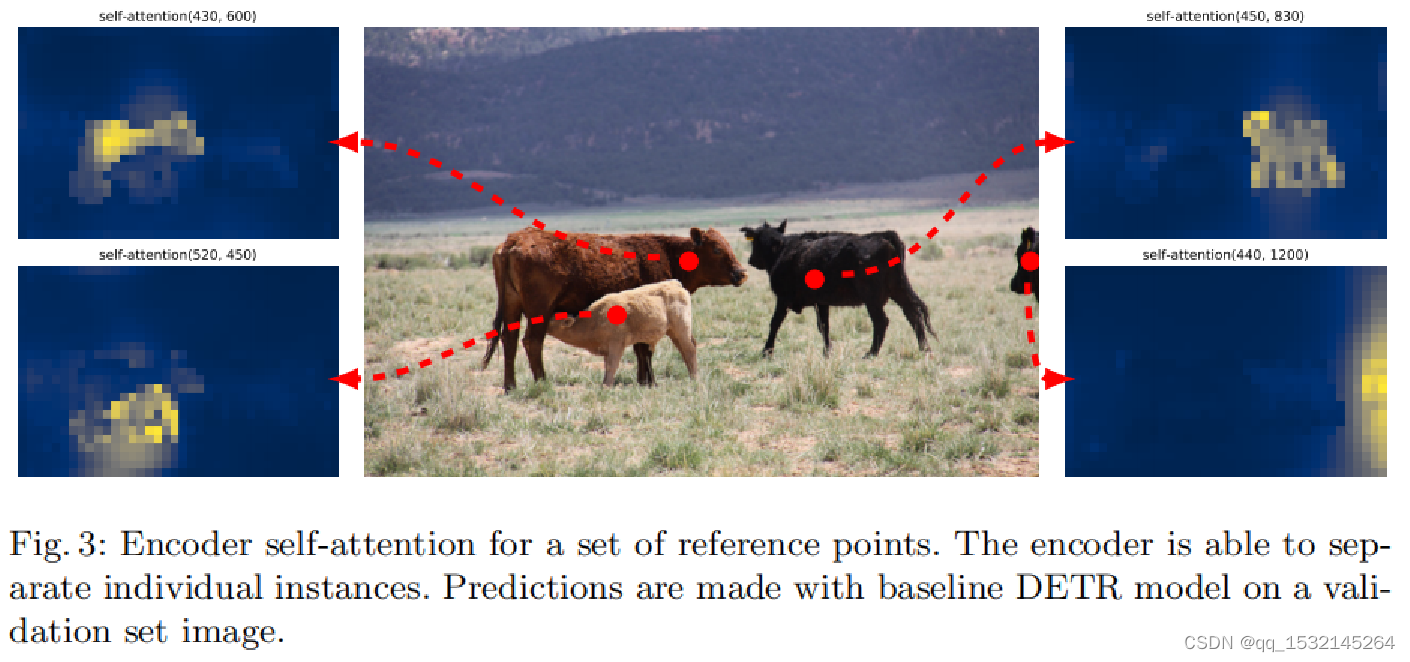

3、Encoder self-attention

作者将编码器注意力可视化,利用对每个物体选一个点计算自注意力,可以发现,经过Transformer Encoder后每个物体都可以很好的区分开来。

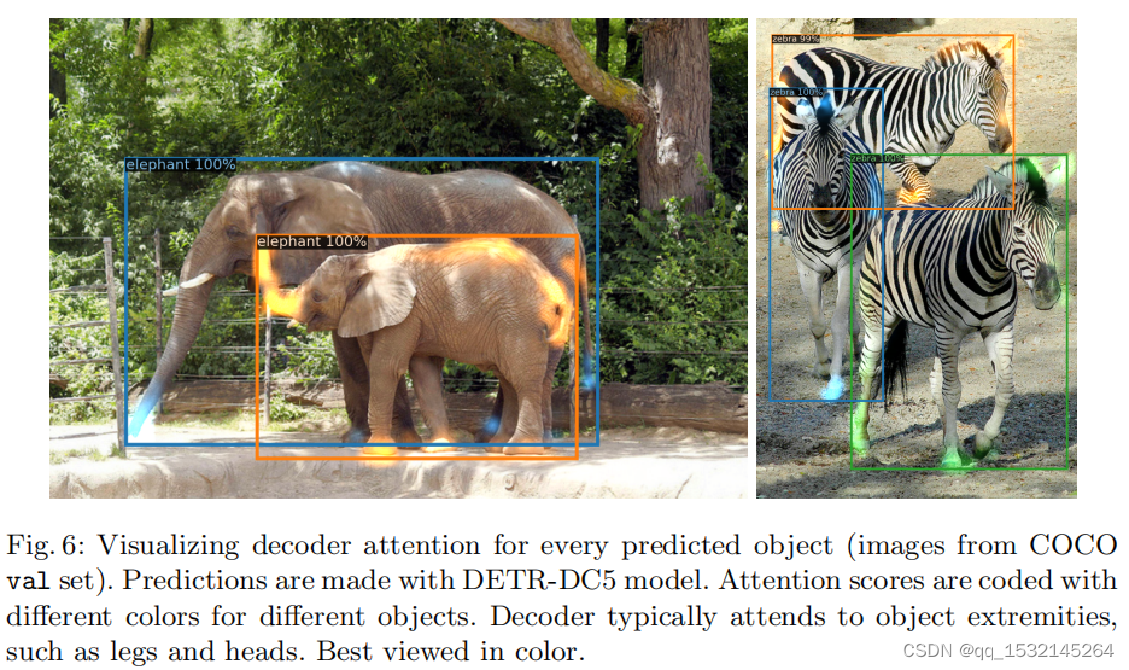

4、Decoder

Encoder是学习全局特征,让物体之间尽可能分得开。但是对于轮廓点这些细节就需要Decoder去做,Decoder可以很好的处理遮挡问题。

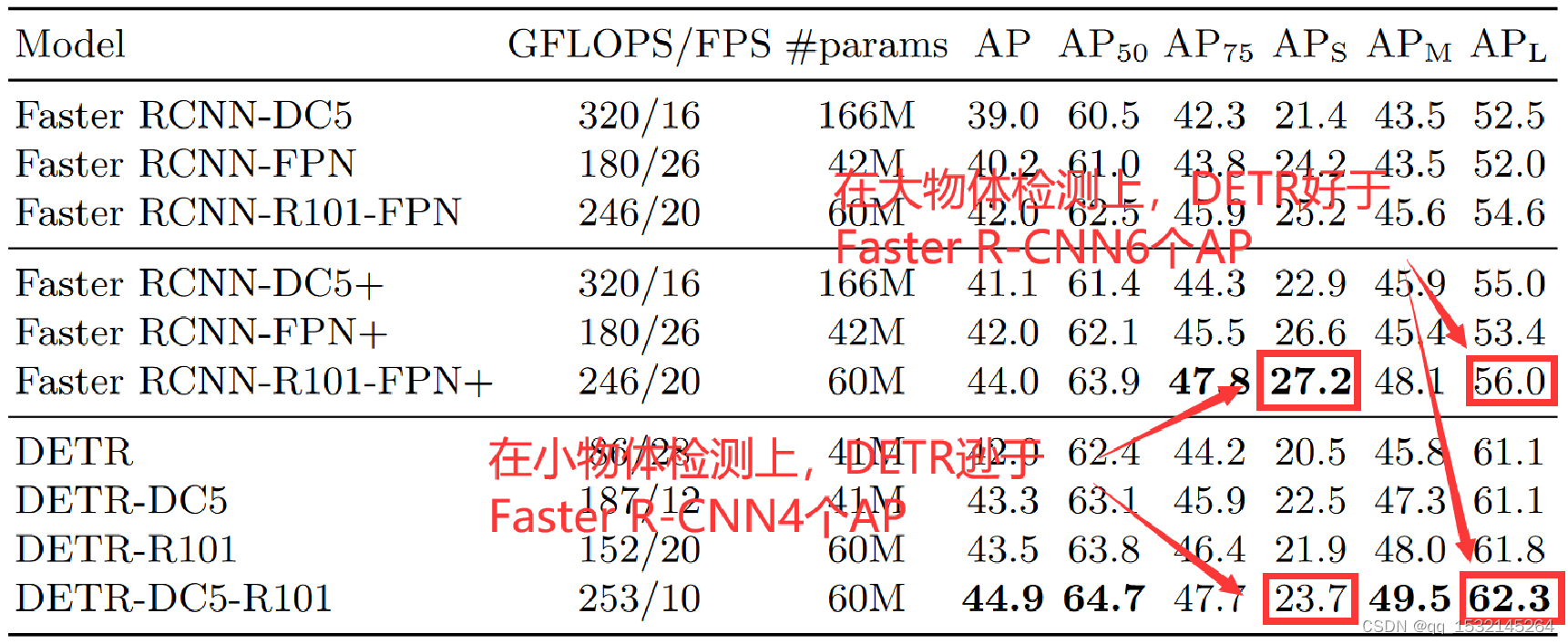

5、Comparison with Faster R-CNN

6、Conclusion

- 文章作者指出DETR的优势在于:

- 对于大物体的检测,性能优于Faster R-CNN;

- 模型结构简单,Pytorch推理代码不到50行;

- 方便拓展到其他任务上,文章也指出DETR在全景分割上表现出不错的效果.

- 文章作者也指出DETR存在的缺点:

- 模型训练时间较长,大概需要500epoch;

- 相对于Faster R-CNN,对于小物体的目标检测性能较差。

查阅文章

【计算机视觉 | 目标检测】Object query的理解

从人脑到Transformer:轻松理解注意力机制中的QKV

DETR哔哩哔哩讲解笔记

DETR哔哩哔哩讲解笔记

DETR哔哩哔哩讲解笔记

DETR哔哩哔哩讲解笔记