C刊级 | Matlab实现DBO-BiTCN-BiGRU-Attention蜣螂算法优化双向时间卷积双向门控循环单元融合注意力机制多变量回归预测

目录

效果一览

基本介绍

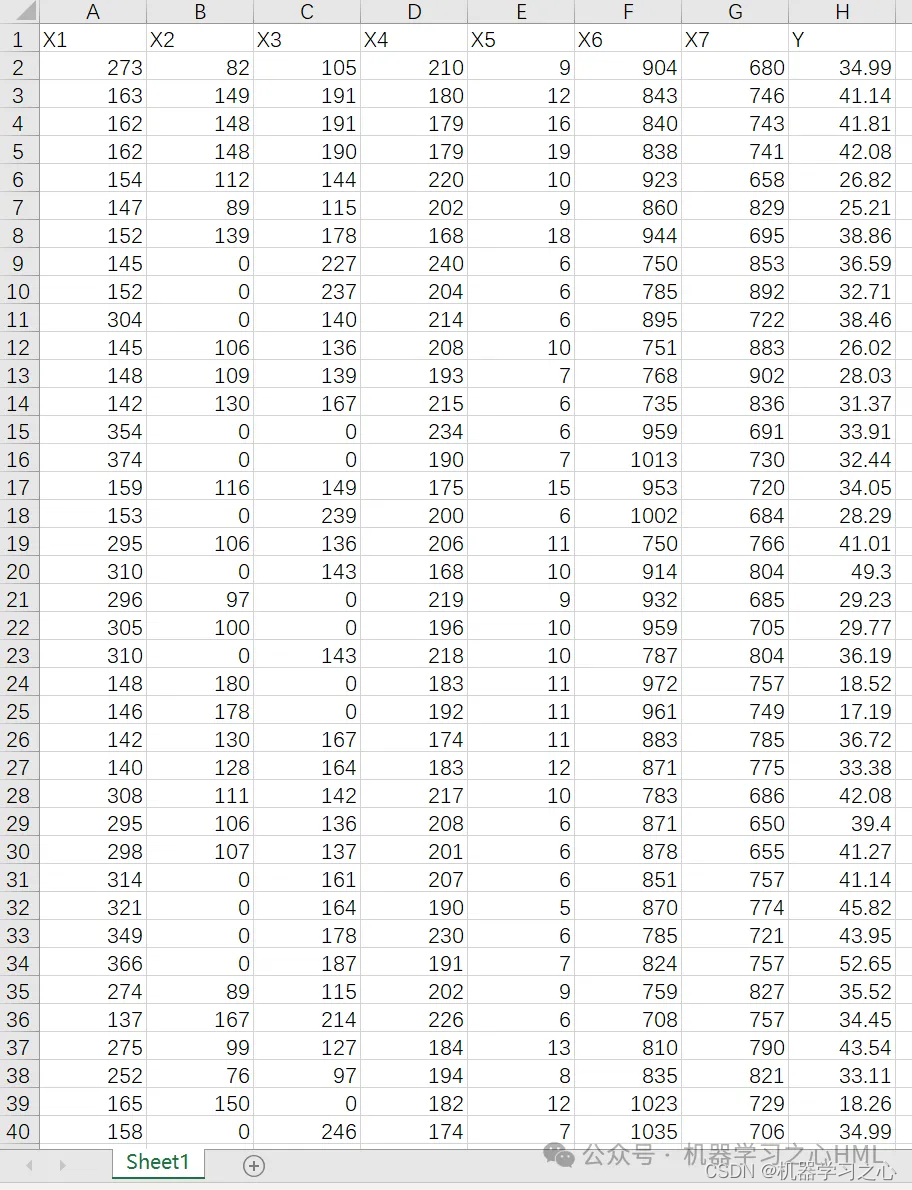

1.Matlab实现DBO-BiTCN-BiGRU-Attention蜣螂算法优化双向时间卷积双向门控循环单元融合注意力机制多变量回归预测(完整源码和数据),优化学习率,BiGRU的神经元个数,滤波器个数, 正则化参数;

2.输入多个特征,输出单个变量,回归预测,自注意力机制层,运行环境matlab2023及以上;

3.命令窗口输出R2、MAE、MAPE、 RMSE多指标评价;

4.代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细。

模型描述

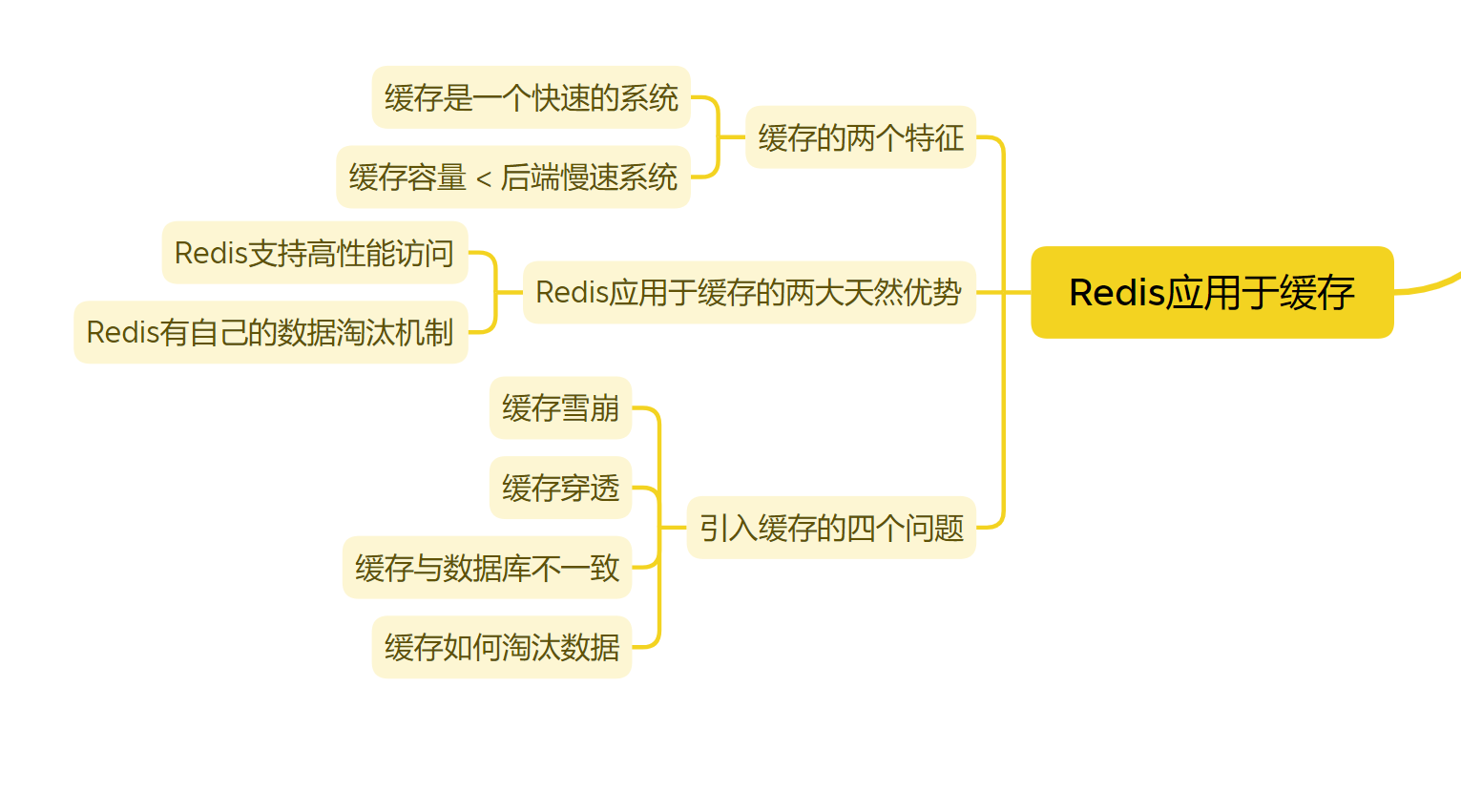

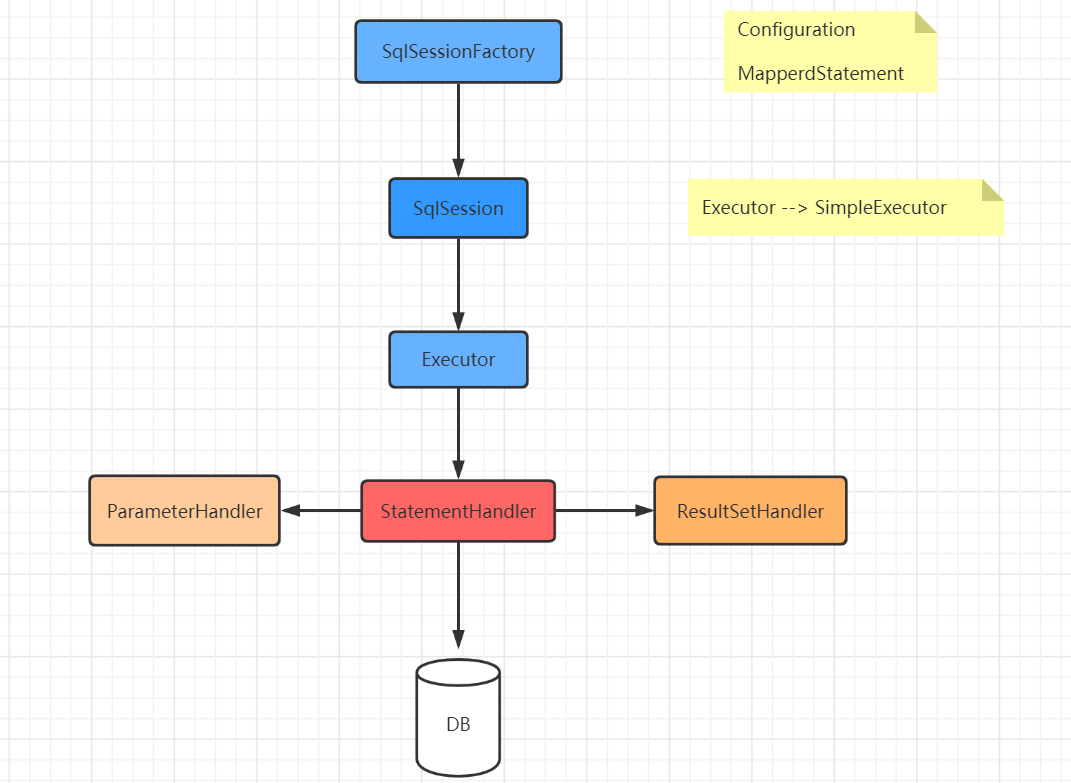

DBO-BiTCN-BiGRU-Attention蜣螂算法是一个用于多变量回归预测的模型,它结合了多个神经网络层和注意力机制来提高预测的准确性。下面是对每个组件的简要解释:

DBO(Double Backtest Optimization)蜣螂算法:这是一种用于优化模型参数的算法,它通过反复进行回测和参数调整来寻找最佳的参数组合,以提高模型在历史数据上的表现。

BiTCN(Bidirectional Temporal Convolutional Network):这是一个双向时间卷积网络,用于从时间序列数据中提取特征。时间卷积层可以捕捉时间序列数据中的长期依赖关系,并生成具有时序信息的特征表示。

BiGRU(Bidirectional Gated Recurrent Unit):这是一个双向门控循环单元网络,用于学习时间序列数据中的时序模式。GRU是一种循环神经网络,可以有效地处理序列数据,并通过门控机制来控制信息的流动。

Attention(注意力机制):这是一种机制,用于在模型中对不同的输入元素分配不同的权重。注意力机制可以帮助模型集中关注对预测有更大贡献的输入元素,从而提高模型的准确性。

综合而言,DBO-BiTCN-BiGRU-Attention蜣螂算法将双向时间卷积、双向门控循环单元和注意力机制结合在一起,以实现对多变量时间序列数据的回归预测。通过优化参数和提取关键特征,该模型可以提高预测准确性,并在实际应用中具有潜力。

程序设计

- 完整源码和数据获取方式私信博主回复Matlab实现DBO-BiTCN-BiGRU-Attention蜣螂算法优化双向时间卷积双向门控循环单元融合注意力机制多变量回归预测。

%% 清空环境变量

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

warning off % 关闭报警信息

%% 导入数据

res = xlsread('data.xlsx');

%% 数据分析

num_size = 0.7; % 训练集占数据集比例

outdim = 1; % 最后一列为输出

num_samples = size(res, 1); % 样本个数

res = res(randperm(num_samples), :); % 打乱数据集(不希望打乱时,注释该行)

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

%% 格式转换

for i = 1 : M

vp_train{i, 1} = p_train(:, i);

vt_train{i, 1} = t_train(:, i);

end

for i = 1 : N

vp_test{i, 1} = p_test(:, i);

vt_test{i, 1} = t_test(:, i);

end

disp('程序运行时间较长,需迭代popsize*maxgen次!可自行调整运行参数')

%% 初始化DBO参数

popsize = 20; % 初始种群规模

maxgen = 10; % 最大进化代数

fobj = @(x)objectiveFunction(x,f_,vp_train,vt_train,vp_test,T_test,ps_output);

%% 优化算法参数设置

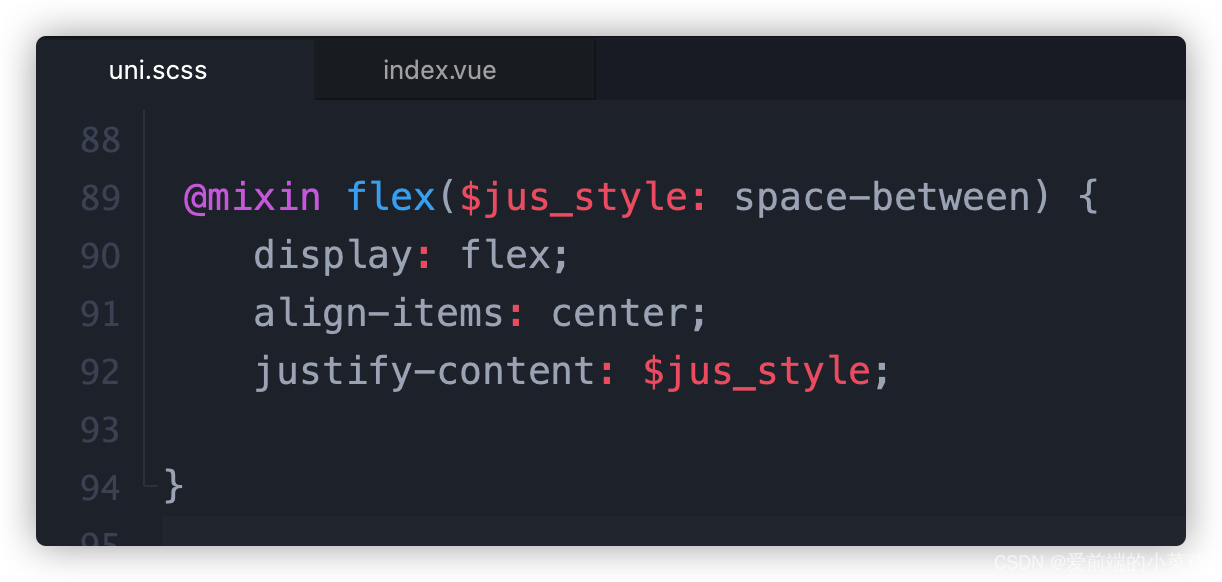

lb = [0.0001 10 20 0.00001]; % 参数的下限。分别是学习率,BiGRU的神经元个数,滤波器个数, 正则化参数

ub = [0.01 100 120 0.005]; % 参数的上限

dim = length(lb);%数量

[Best_score,Best_pos,DBO_curve]=DBO(popsize,maxgen,lb,ub,dim,fobj);

setdemorandstream(pi);

%% 将优化目标参数传进来的值 转换为需要的超参数

learning_rate = Best_pos(1); % 学习率

NumNeurons = round(Best_pos(2)); % BiGRU神经元个数

numFilters = round(Best_pos(3)); % 滤波器个数

L2Regularization = Best_pos(4); % 正则化参数

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

pNum = round( pop * P_percent ); % The population size of the producers

lb= c.*ones( 1,dim ); % Lower limit/bounds/ a vector

ub= d.*ones( 1,dim ); % Upper limit/bounds/ a vector

%Initialization

for i = 1 : pop

x( i, : ) = lb + (ub - lb) .* rand( 1, dim );

fit( i ) = fobj( x( i, : ) ) ;

end

pFit = fit;

pX = x;

XX=pX;

[ fMin, bestI ] = min( fit ); % fMin denotes the global optimum fitness value

bestX = x( bestI, : ); % bestX denotes the global optimum position corresponding to fMin

% Start updating the solutions.

for t = 1 : M

[fmax,B]=max(fit);

worse= x(B,:);

r2=rand(1);

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

for i = 1 : pNum

if(r2<0.9)

r1=rand(1);

a=rand(1,1);

if (a>0.1)

a=1;

else

a=-1;

end

x( i , : ) = pX( i , :)+0.3*abs(pX(i , : )-worse)+a*0.1*(XX( i , :)); % Equation (1)

else

aaa= randperm(180,1);

if ( aaa==0 ||aaa==90 ||aaa==180 )

x( i , : ) = pX( i , :);

end

theta= aaa*pi/180;

x( i , : ) = pX( i , :)+tan(theta).*abs(pX(i , : )-XX( i , :)); % Equation (2)

end

x( i , : ) = Bounds( x(i , : ), lb, ub );

fit( i ) = fobj( x(i , : ) );

end

[ fMMin, bestII ] = min( fit ); % fMin denotes the current optimum fitness value

bestXX = x( bestII, : ); % bestXX denotes the current optimum position

R=1-t/M; %

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%

Xnew1 = bestXX.*(1-R);

Xnew2 =bestXX.*(1+R); %%% Equation (3)

Xnew1= Bounds( Xnew1, lb, ub );

Xnew2 = Bounds( Xnew2, lb, ub );

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/129215161

[2] https://blog.csdn.net/kjm13182345320/article/details/128105718