PPO:推动语言模型对齐的关键技术

最新的人工智能研究揭示,通过人类反馈的强化学习(RLHF)是训练大型语言模型(LLMs)的关键技术。尽管某些AI从业者因熟悉监督学习而回避使用RL,但RL技术其实并不复杂,并能显著提升LLM的性能。本文深入探讨了Proximal Policy Optimization (PPO)算法,它易于理解和使用,被OpenAI选为对InstructGPT进行RLHF的算法,并随着ChatGPT的普及而广为人知。

背景与基本概念

训练LLMs的过程中,除了使用监督式微调(SFT),RLHF成为对齐过程中的关键,可通过人类反馈训练模型满足特定准则,如避免有害输出、避免幻觉等。

RL算法的优化

之前,我们探讨了基于策略梯度的基础RL算法,如(Deep) Q-Learning和简单的策略梯度算法,它们在解决复杂问题时存在数据效率低和鲁棒性差的问题。TRPO和PPO算法旨在改进这些问题,其中PPO以其简单性、数据效率、鲁棒性,成为RLHF的首选算法。

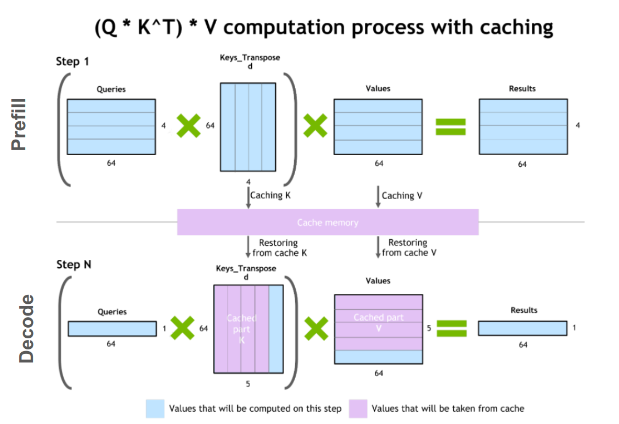

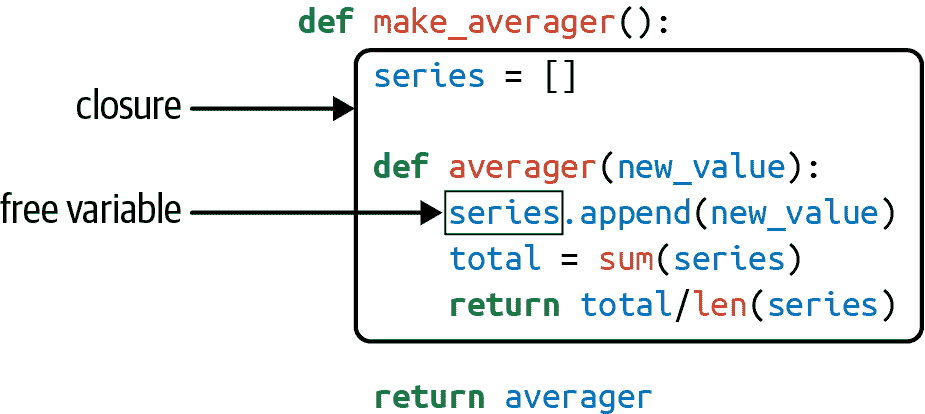

PPO的工作原理

PPO是在TRPO基础上简化而来,通过对策略更新的多次迭代优化,增强了数据效率和泛用性。PPO使用"裁剪"的概率比率和最小化策略更新代价,避免了复杂的约束优化问题,简化了实现过程,并通过增加均方误差来训练联合网络,进一步提升了数据效率。

PPO与语言模型对齐

PPO不仅在RL研究中占有一席之地,还对语言模型的训练产生了重大影响。通过SFT和RLHF,InstructGPT首次采用PPO作为训练算法,后续被广泛应用于包括ChatGPT在内的各种模型。这标志着PPO在改进语言模型对齐方面的重要地位。

结论

综上所述,相比之前的算法,PPO提高了数据效率和稳定性。它因简单性、泛用性而广受欢迎,是现代LLMs训练中不可或缺的工具。

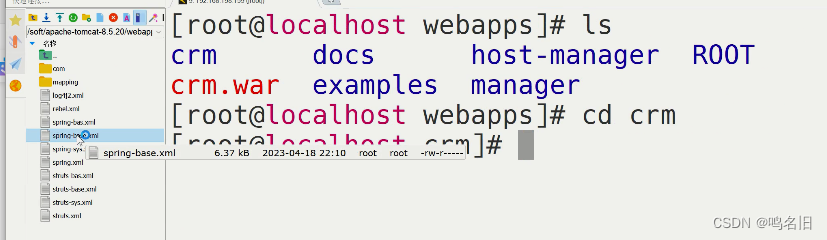

![[Linux]文件基础-如何管理文件](https://img-blog.csdnimg.cn/direct/dfc60152711d4fbb86724921f666e4d3.png#pic_center)