BERT:深度学习领域中的语言理解利器

摘要

BERT(双向编码器表示法自转换器)是一种领先的深度学习模型,它在许多语言理解任务中都显示出卓越的性能。BERT模型基于转换器编码器架构,并通过自监督学习在大量未标记文本数据上进行预训练,随后针对特定任务进行微调。这种预训练和微调的方法推动了BERT在11种语言理解任务上创下新的最佳成绩,从而迅速获得了广泛关注。

关键特性和创新

- 双向特征表征:相较于以往的单向自注意力模型,BERT通过双向自注意力在序列中的每个令牌之间构建丰富的上下文特征表征。

- 自监督学习:BERT通过掩码语言建模(MLM)和下一句预测(NSP)这两种独特的预训练任务,利用大规模未标记文本进行自监督学习,从而捕捉到更深入的语言特征。

- 通用架构:BERT模型的通用性允许其通过少量特定于任务的调整,在包括命名实体识别、情感分类等在内的多种任务中获得最先进的性能。

- 低成本微调:尽管BERT的预训练耗费资源,但其微调过程相对经济,使得深度学习实践者能够以较低的计算成本解决广泛的NLP问题。

BERT的基础组成

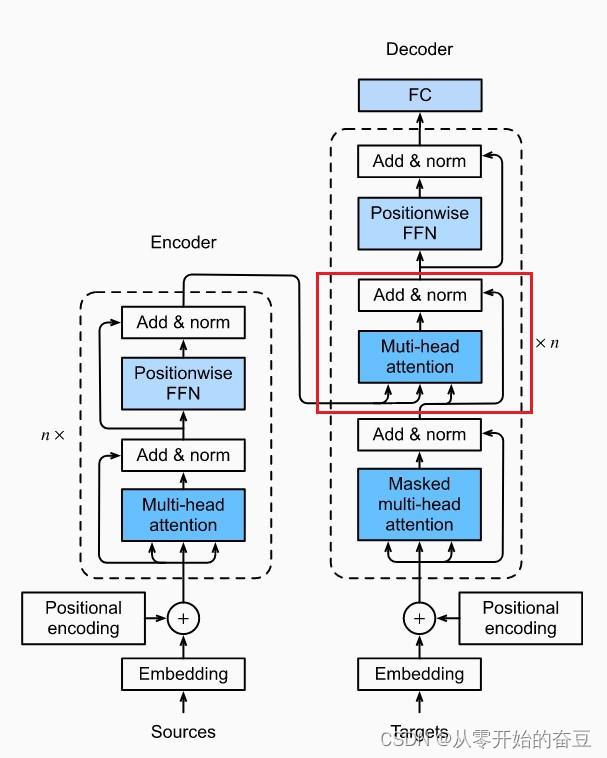

- **双向自注意力(Bi-directional Self-Attention)和变换器编码器(Transformer Encoders)**是BERT构建双向特征表征的基础。

- **自监督学习(Self-Supervised Learning)**策略,不依赖人工标注,通过预训练从大量未标记文本中学习有用的语言特征。

预训练和微调过程

- 预训练:BERT通过在大量文本数据上运行MLM和NSP任务进行预训练,学习文字间的丰富关系。

- 微调:预训练完成后,BERT可以通过简单的结构调整和在特定任务的标记数据上的微调,以优异的性能解决多种NLP问题。

结论

BERT不仅仅因其在多个任务上的突出表现而被看作是深度学习工具包中的“瑞士军刀”,更重要的是,它的出现标志着双向自注意力和自监督学习这两个核心概念对于实现深度语言理解的重要性。通过预训练和微调,BERT能够在各种NLP任务中实现或超越最新的技术水平,这使得它成为现代深度学习实践者的重要工具。

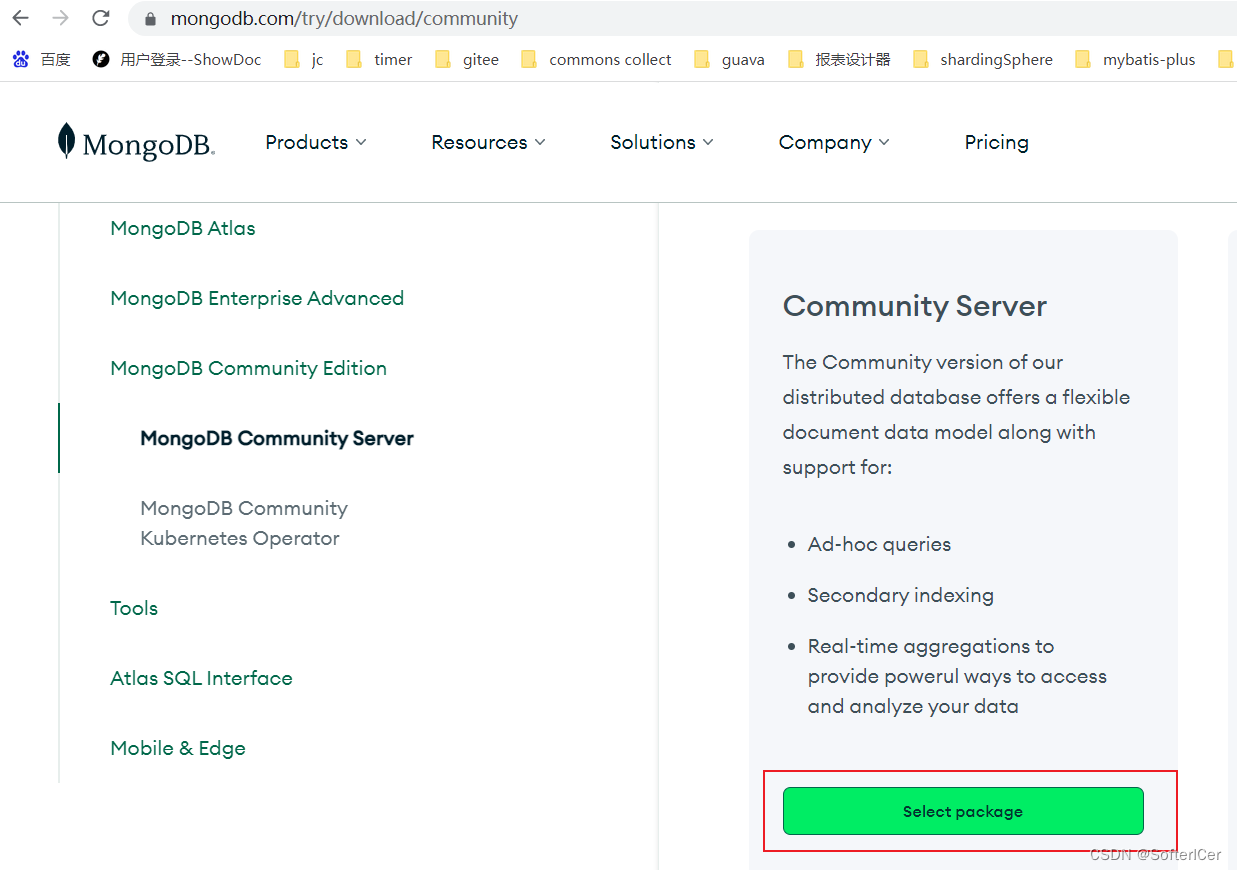

![[保姆级教程]Windows安装MongoDB教程](https://img-blog.csdnimg.cn/b161eb27bad34615904c5600b4108e58.gif#pic_center)