目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于python的电影票房预测系统

课题背景和意义

随着电影产业的快速发展,电影票房成为了衡量电影成功与否的重要指标之一。然而,电影票房受到多种因素的影响,如电影类型、演员阵容、上映时间等,使得准确预测票房成为一项具有挑战性的任务。基于Python的电影票房预测系统的研究旨在利用Python编程语言和相关算法,分析电影的各种特征和历史票房数据,以实现对未来票房的准确预测。这一课题的研究不仅有助于电影制片方制定合理的营销策略和预算计划,还有助于观众做出更明智的观影选择。

实现技术思路

一、算法理论技术

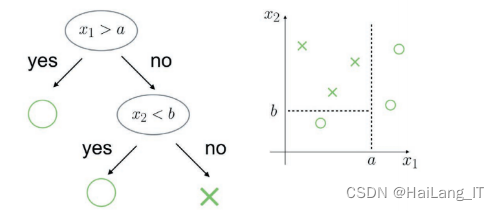

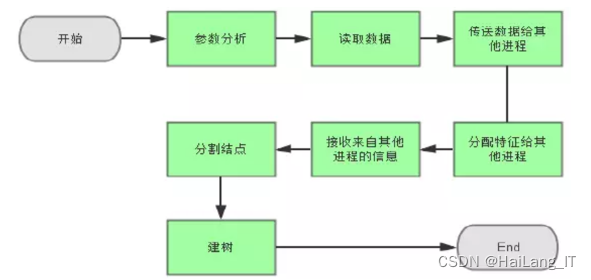

随机森林是一种集成学习算法,它基于bagging框架下的决策树模型。具体来说,随机森林包含很多树,每棵树都会给出分类结果。从原训练样本集N中有放回地重复随机抽取n个样本生成新的训练样本集合,用于训练决策树。这个过程重复多次,生成多棵决策树,形成随机森林。新数据的分类结果按分类树投票多少形成的分数而定。在每个决策树的训练过程中,如果每个特征的样本维度为M,会指定一个常数m(m远小于M),然后随机地从M个特征中选取m个特征进行子树的分裂和生长。这个过程使得每棵树的建立都依赖于独立抽取的样本和特征,增加了模型的多样性。

梯度提升(Gradient Boosting)是一种功能强大的机器学习技术,其核心思想在于集成学习,即通过结合多个较简单的模型(称为弱学习器,通常是决策树)来构建一个更强大、更准确的模型。在梯度提升的每次迭代中,算法会引入一个新的弱学习器,其目标是拟合前一轮模型所产生的残差(即真实值与当前模型预测值之间的差异)。通过这种方式,每个新加入的模型都专注于修正之前模型的错误,逐步减小训练数据上的损失。这种逐步优化、逐步逼近真实值的过程使得梯度提升在多种任务中,如回归、分类和排序等,都能展现出极高的预测精度和泛化能力。此外,梯度提升算法还具备灵活性,可以通过调整模型参数和弱学习器的数量来平衡偏差和方差,从而适应不同复杂度的数据集和问题。

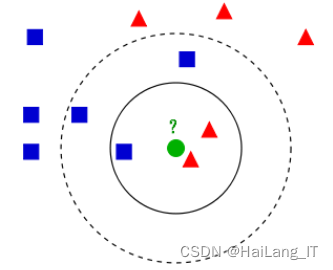

K近邻(KNN)是一种基于实例的学习,它的工作原理是:在特征空间中,如果一个样本的最接近的k个邻居中大多数属于某一个类别,则该样本也属于这个类别。KNN算法的核心在于距离的计算,通常使用欧氏距离或曼哈顿距离等。KNN算法简单易懂,无需训练阶段,但在处理大规模数据集时可能会面临计算量大、效率低下的问题。此外,KNN算法对特征的尺度敏感,因此在进行距离计算前通常需要对特征进行归一化或标准化处理。

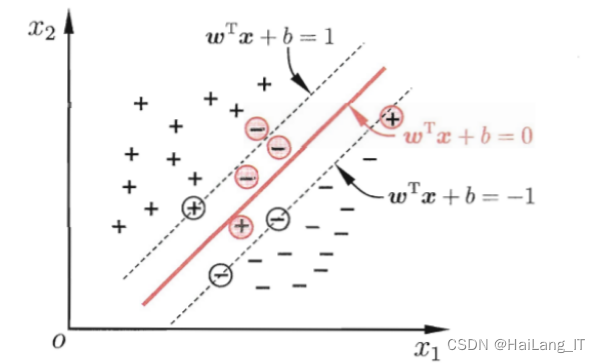

支持向量机(SVM)是一种二分类模型,它的基本模型是定义在特征空间上的间隔最大的线性分类器。SVM的学习策略就是间隔最大化,可形式化为一个求解凸二次规划的问题,也等价于正则化的合页损失函数的最小化问题。SVM的核心思想是通过将低维空间的数据映射到高维空间,使得原本线性不可分的数据变得线性可分。SVM算法在处理高维数据、非线性问题时表现出色,且对于小样本问题也具有良好的泛化能力。然而,SVM对大规模数据集的训练可能会比较慢,且对于多分类问题需要进行额外的处理。

二、数据集

现有的公开数据集并不能完全满足我的研究需求。为了提高预测系统的准确性和可靠性,我决定自行收集并整理一组全新的数据集。我通过网络爬虫技术从各大电影票务平台抓取了近年来上映的电影的详细信息和历史票房数据,并对这些数据进行了清洗和预处理。同时,我还利用计算机视觉技术对电影海报进行了图像特征提取和标注。最终,我构建了一个包含丰富电影特征和票房信息的数据集。这个自制的数据集不仅涵盖了各种类型和风格的电影,还包含了实际票房数据和观众反馈信息。通过这组数据集的训练和验证,我能够更准确地评估预测系统的性能,并为后续的研究提供有力支持。我相信这个自制的数据集将为电影票房预测领域的研究提供新的视角和思路,并为该领域的发展做出积极贡献。

三、实验及结果分析

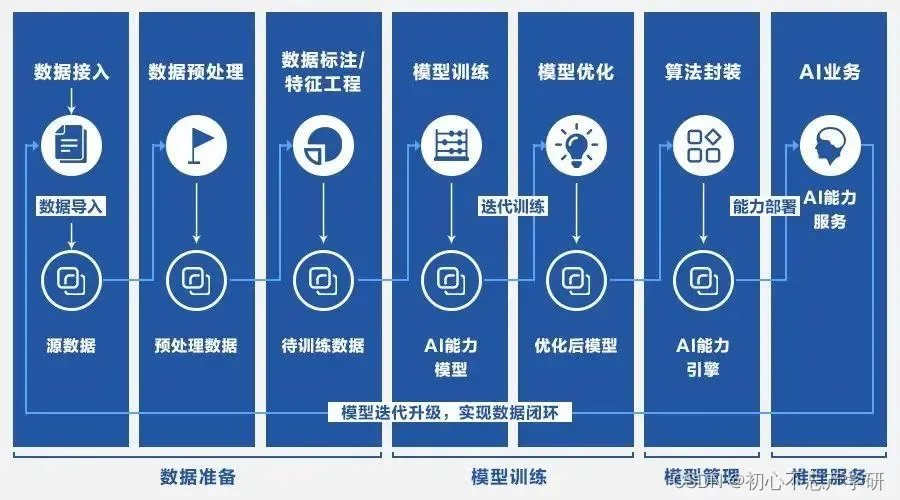

数据预处理是机器学习建模中的关键环节,其中数据清洗旨在确保数据质量,通过处理缺失值、异常值和重复值来减少数据噪声和偏差。特征工程则通过创建新特征,如演员/导演的热门程度、电影的宣传强度指数等,来捕捉更多影响票房的潜在因素。标准化/归一化是为了消除特征间的量纲差异,使不同尺度的特征在数值上具有可比性,从而提升模型的稳定性和性能。这些步骤共同构成了从原始数据到可用于建模的高质量数据集的转化过程。

import pandas as pd

import numpy as np

data = pd.read_csv('movie_data.csv')

data.dropna(subset=['director', 'actor'], inplace=True)

data.fillna(data.mean(), inplace=True)

box_office_mean = data['box_office'].mean()

box_office_std = data['box_office'].std()

data = data[(data['box_office'] >= box_office_mean - 3 * box_office_std) &

(data['box_office'] <= box_office_mean + 3 * box_office_std)]

data.drop_duplicates(inplace=True)

print(data.head())探索性数据分析(EDA)是数据分析的初步阶段,它侧重于通过统计方法和可视化技术来深入洞察数据。在这一阶段,我们特别关注分析特征与票房之间的相关性,以理解哪些因素对票房产生显著影响。同时,利用图表、散点图、热力图等可视化工具,我们可以直观地展示数据的分布情况、异常值、趋势以及特征间的相互关系。这不仅有助于识别潜在的数据问题,还能为后续的模型选择和特征工程提供有价值的指导,从而确保建模过程更加高效和准确。

import pandas as pd

import numpy as np

import seaborn as sns

import matplotlib.pyplot as plt

from scipy.stats import pearsonr, spearmanr

data = pd.read_csv('movie_data.csv')

# 分析特征与票房之间的相关性

# 使用Pearson相关系数

corr_pearson = data.corr(method='pearson')

# 或者使用Spearman相关系数来处理非线性关系或异常值

corr_spearman = data.corr(method='spearman')

print("Pearson correlation matrix:")

print(corr_pearson)

print("\nSpearman correlation matrix:")

print(corr_spearman)

plt.figure(figsize=(10, 8))

sns.heatmap(corr_pearson, annot=True, cmap='coolwarm')

plt.title('Pearson Correlation Heatmap')

plt.show()

# 分析特定特征与票房之间的相关性

box_office = data['box_office']

actor_popularity = data['actor_popularity']

director_popularity = data['director_popularity']

# 计算Pearson相关系数和p值

pearson_corr, pearson_p = pearsonr(box_office, actor_popularity)

print(f"Pearson correlation between box office and actor popularity: {pearson_corr:.3f} (p-value: {pearson_p:.3f})")

# 绘制散点图来可视化关系

plt.figure(figsize=(8, 6))

sns.scatterplot(x=actor_popularity, y=box_office)

plt.title('Actor Popularity vs Box Office')

plt.xlabel('Actor Popularity')

plt.ylabel('Box Office')

plt.show()

模型训练与调优是一个综合性的过程,包括使用训练集初步训练模型、利用交叉验证进行模型选择和参数优化,以及应用正则化、集成学习等高级技术来提高模型的预测性能和泛化能力。

pipe = Pipeline([

('scaler', StandardScaler()), # 数据标准化

('clf', RandomForestClassifier()) # 随机森林分类器

])

# 设置参数网格进行搜索

param_grid = {

'clf__n_estimators': [100, 200, 500], # 树的数量

'clf__max_depth': [3, 5, None], # 树的深度

'clf__max_features': ['auto', 'sqrt', 'log2'] # 最大特征数

}

# 使用交叉验证和网格搜索进行模型选择和参数调优

cv = 5 # 5折交叉验证

grid_search = GridSearchCV(pipe, param_grid, cv=cv, scoring='accuracy')

# 训练模型

grid_search.fit(X_train, y_train)

# 输出最佳参数

print("Best parameters found: ", grid_search.best_params_)

# 输出最佳模型的交叉验证分数

print("Highest cross-validation score: ", grid_search.best_score_)

# 使用最佳模型在测试集上进行预测

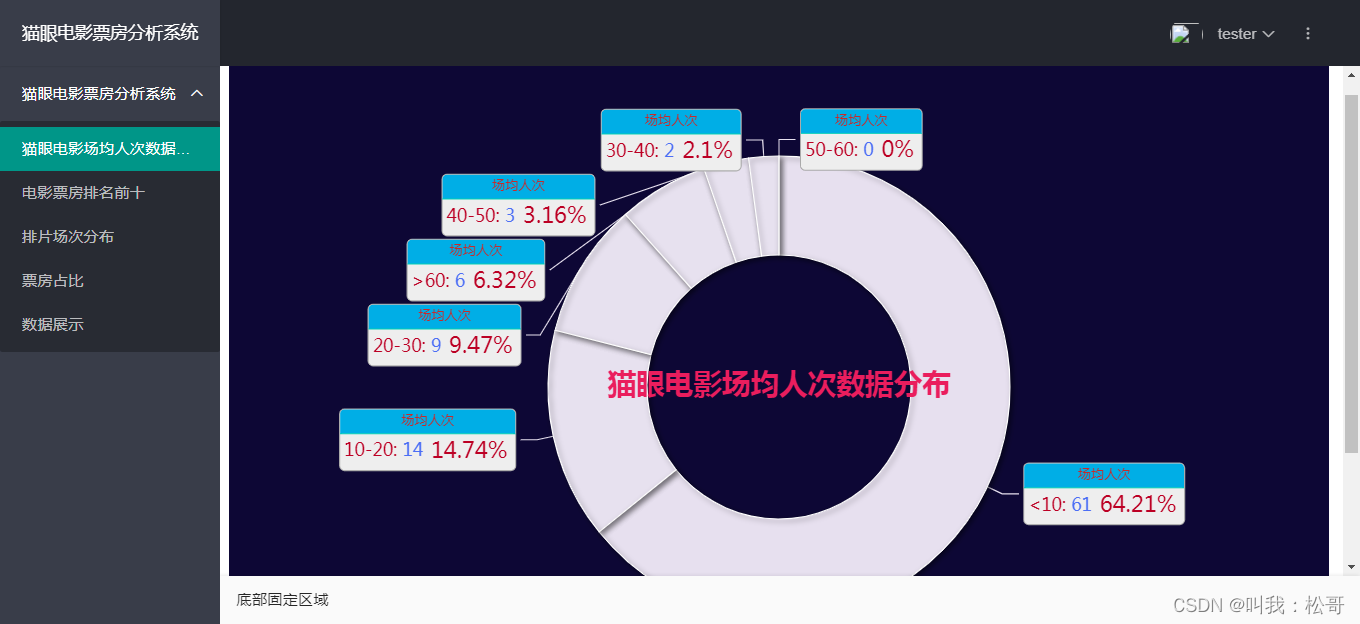

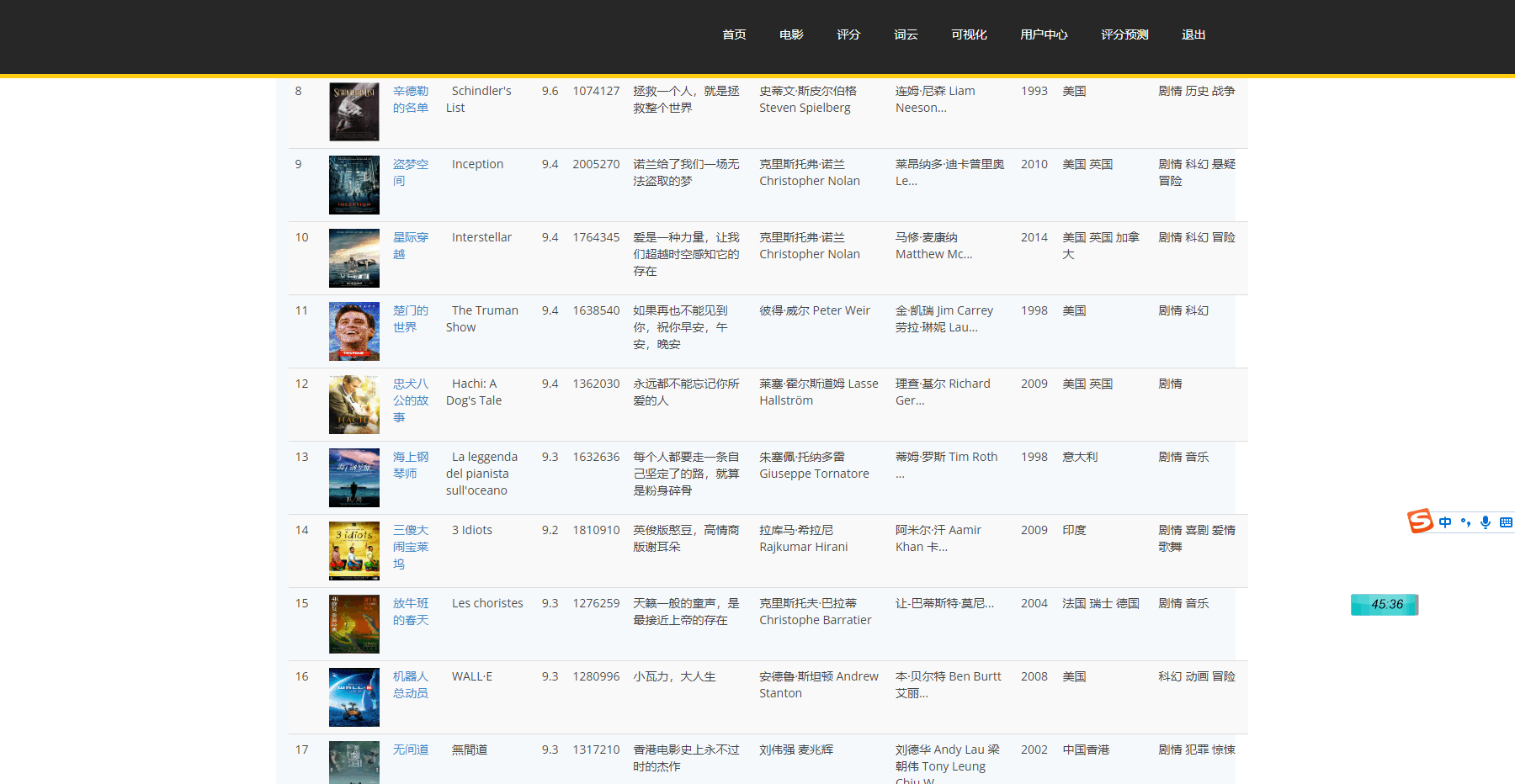

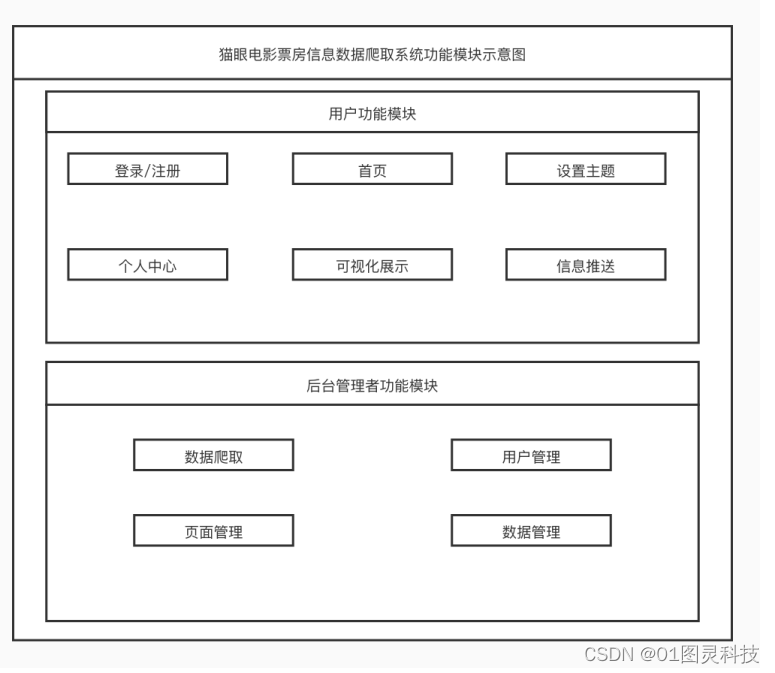

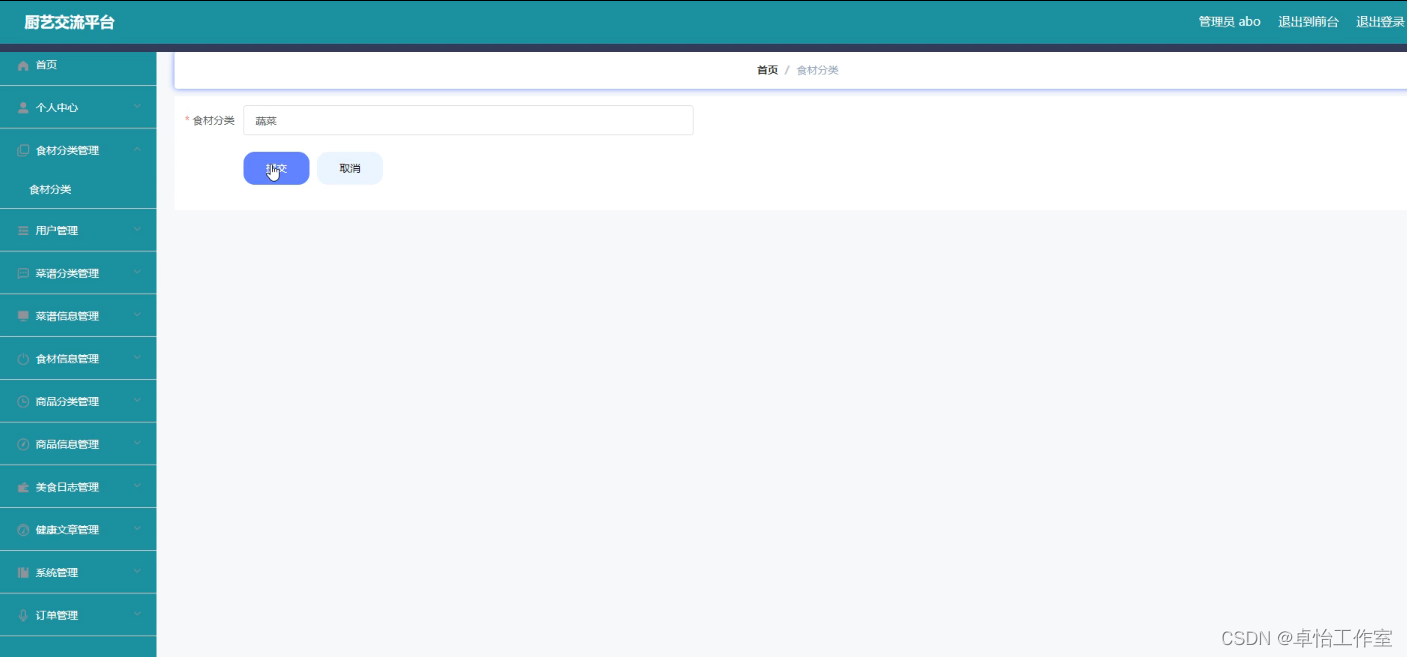

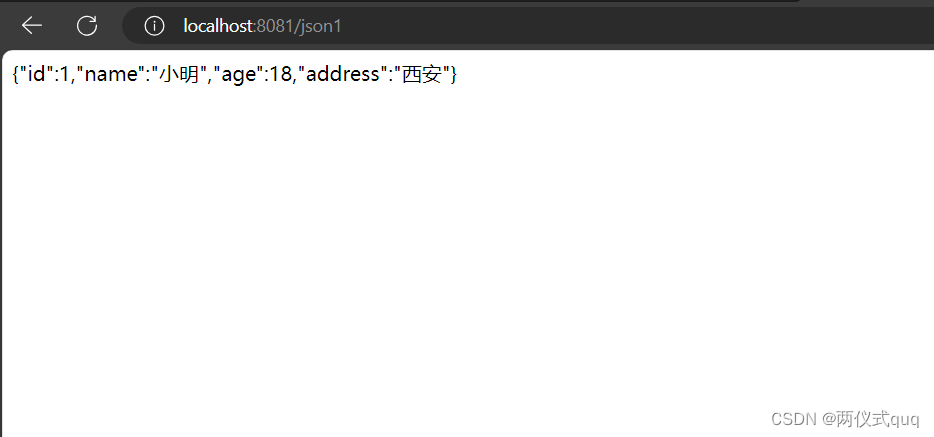

y_pred = grid_search.best_estimator_.predict(X_test) 实现效果图样例:

最后

我是海浪学长,创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

![[晓理紫]每日论文分享(有中文摘要,源码或项目地址)--强化学习、机器人等](https://img-blog.csdnimg.cn/direct/f6f124fc6bcb4fd995a26bf05958b098.jpeg#pic_center)