Apache Spark 是一种快速、通用的大数据处理引擎,用于分布式数据处理和分析。它支持在大规模数据集上进行高性能计算,并且具有内置的分布式数据处理功能。

Apache Spark 的基本概念包括以下几个方面:

弹性分布式数据集(Resilient Distributed Dataset, RDD):RDD 是 Spark 的核心数据结构,它代表了分布式内存中的不可变对象集合。RDD 允许在各个节点上并行处理数据,并提供了容错和恢复机制。

转换操作(Transformation):Spark 提供了一系列转换操作,如 map、filter、reduce 等,可以对 RDD 进行各种操作,生成新的 RDD。

动作操作(Action):Spark 提供了一系列动作操作,如 count、collect、reduce 等,用于触发计算并返回结果。

广播变量(Broadcast Variables):广播变量是一种高效共享的只读变量,可以在集群中的所有工作节点上使用。这种技术能够减少数据复制和网络传输,提高计算性能。

在大数据分析中,Apache Spark 有广泛的应用,包括但不限于以下几个方面:

批处理:Spark 可以处理大规模的批量数据,并提供了丰富的数据转换和计算操作。它通常与 Hadoop 生态系统中的 HDFS、Hive、HBase 等组件集成,能够进行高效的数据处理和分析。

流处理:Spark 还支持实时流式数据处理,通过 Spark Streaming 模块,可以实时接收和处理数据流。它可以与 Apache Kafka、Apache Flume 等流处理框架集成,实现实时数据的计算和分析。

机器学习:Spark 提供了机器学习库 MLlib,其中包括常见的机器学习算法和工具,如分类、回归、聚类、推荐系统等。它可以处理大规模的数据,并提供高性能的分布式机器学习模型训练和推断。

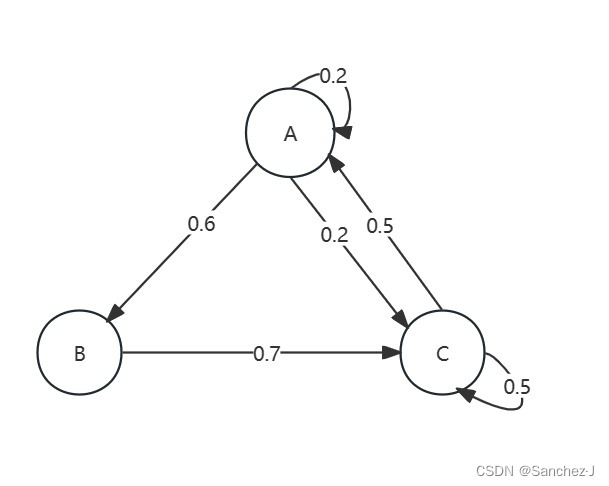

图计算:Spark 提供了 GraphX 图计算库,用于处理大规模的图数据,支持图的构建、遍历和计算。它可以应用于社交网络分析、推荐系统等领域。

因为 Apache Spark 具有高性能和易用性的特点,被广泛应用于大数据分析、机器学习和图计算等领域,并且得到了业界和学术界的认可。