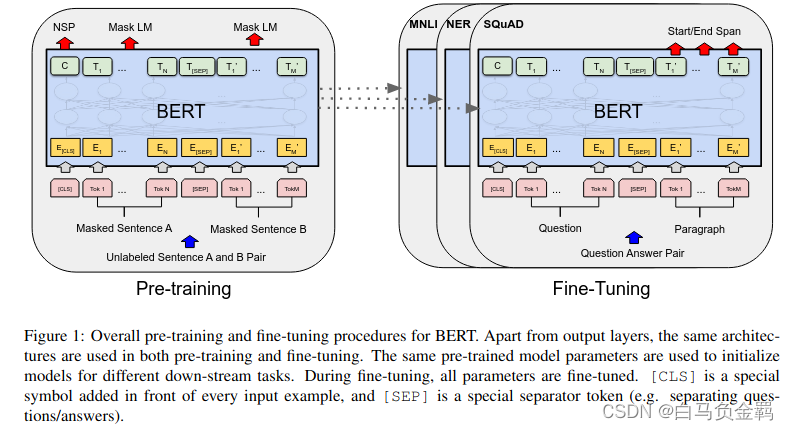

预训练模型:A pre-trained model is a saved network that was previously trained on a large dataset, typically on a large-scale image-classification task. You either use the pretrained model as is or use transfer learning to customize this model to a given task.

BERT是Google提出的一个基于Transformer的自然语言处理领域的预训练模型。它之所以被称为这个名字,一方面它是Bidirectional Encoder Representations from Transformers首字母的缩写。另一方面,还是为了致敬之前的一个模型ELMO。《Sesame Street》是由美国芝麻街工作室制作的一档儿童教育电视节目,其中的两个卡通人物分别是ELMO和BERT,如下图所示。

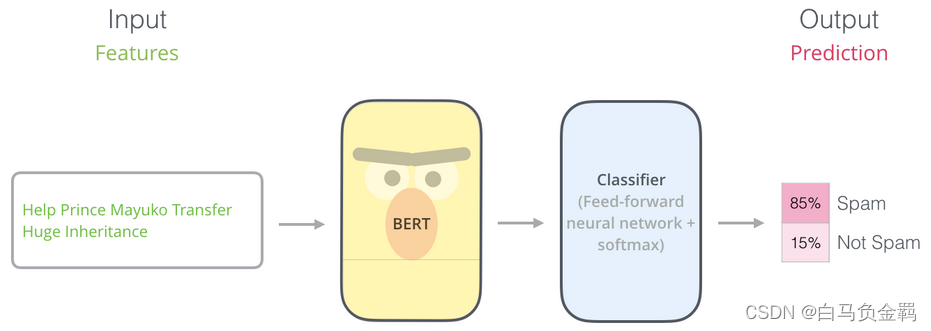

ELMO的基本概念就是利用上下文信息来生成一个单词的表达/Embedding(Contextualized word represen

![【算法每日一练]-数论 (保姆级教程 篇2 )#行列式 #甜甜花研究 #约数个数 #模数 #数树 #盒子与球](https://img-blog.csdnimg.cn/direct/2ffed86c1be349ffa85586cba666c236.jpeg)