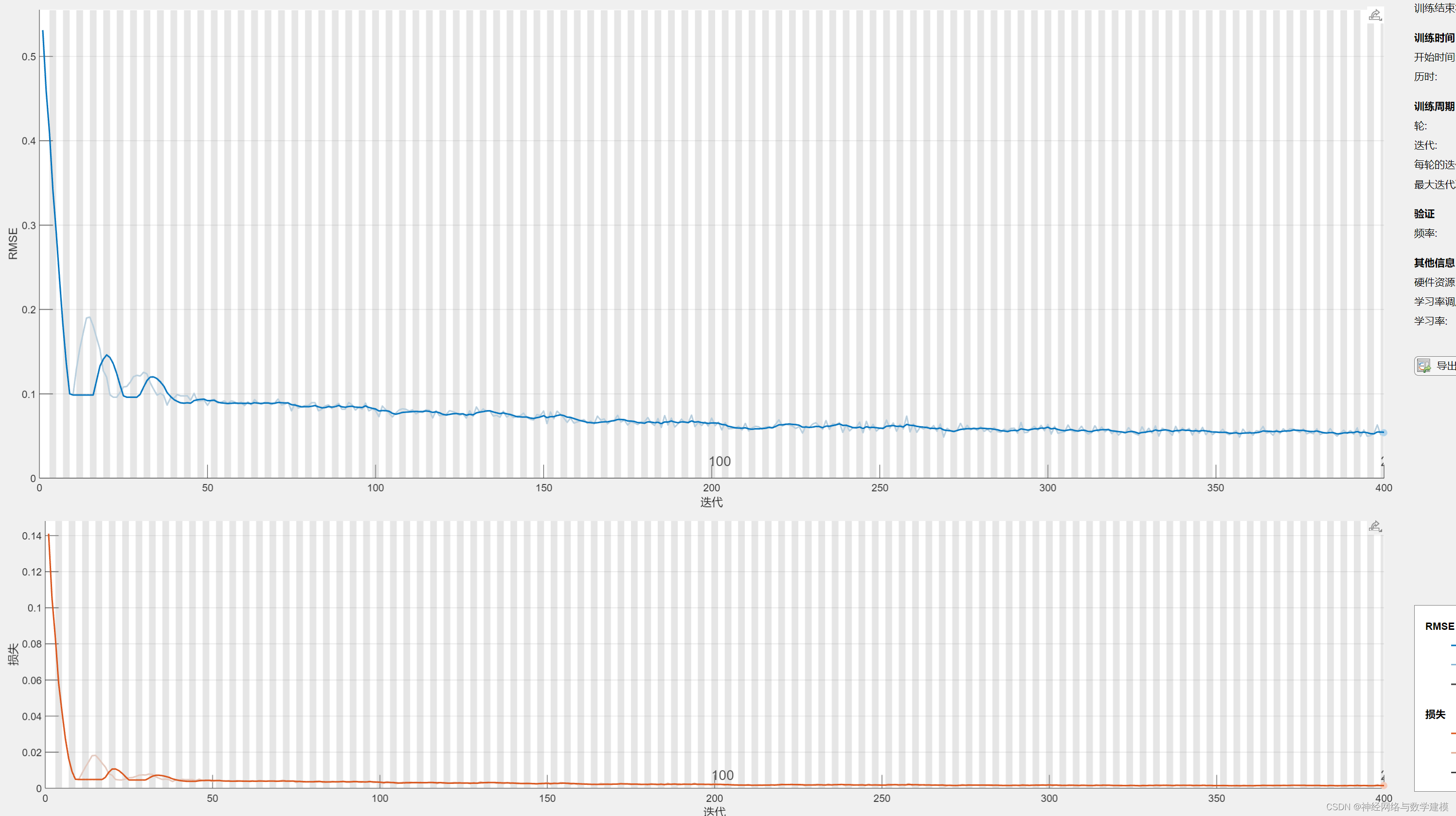

1、什么是梯度消失(gradient vanishing)?

参数更新过小,在每次更新时几乎不会移动,导致模型无法学习。

2、什么是梯度爆炸(gradient exploding)?

参数更新过小大,破坏了模型的稳定收敛。

3、利用梯度截断来缓解梯度爆炸问题

4、门控循环单元(GRU)与普通的循环神经网络之间的关键区别是:GRU支持隐状态门控。模型有专门的机制来确定应该何时来更新隐状态,以及何时重置隐状态。这些机制是可学习的。

5、长短期记忆网络(LSTM)引入记忆元,记忆元的设计目的是用于记录附加的信息。为了控制记忆元,需要许多门,输入门、遗忘门和输出门。

6、GRU和LSTM中的门控设计策略,能够有助于缓解梯度消失或梯度爆炸问题。主要是解决长序列梯度计算中幂指数大小的问题(长序列意味着高阶幂指数计算,容易导致梯度极大或极小),可以通过门控设计来直接减少幂指数大小(直接干掉大阶数,替换为合理数值),从而缓解梯度消失或梯度爆炸问题。