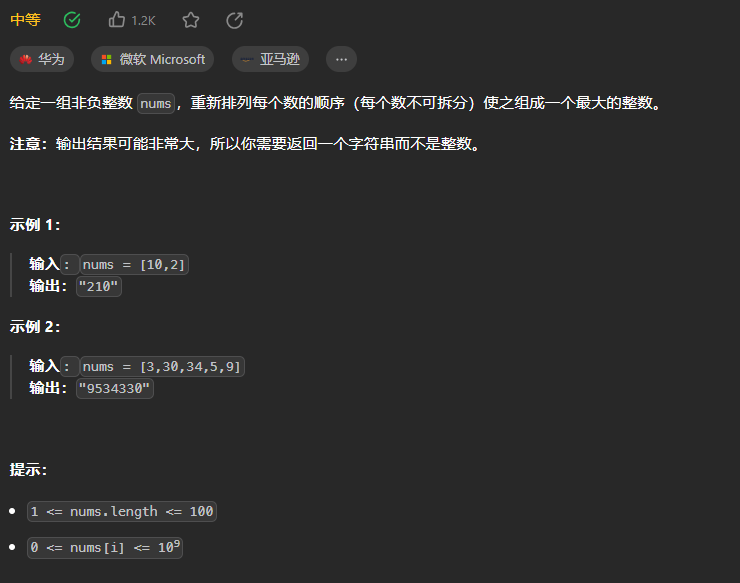

- 在训练神经网络的过程中,随着batch size的增大,处理相同数据量的速度会越来越快,但是达到相同精度所需要的epoch数量越来越多

- 换句话说,使用相同的epoch数量时,大batch size训练的模型与小batch size训练的模型相比,验证准确率会减小

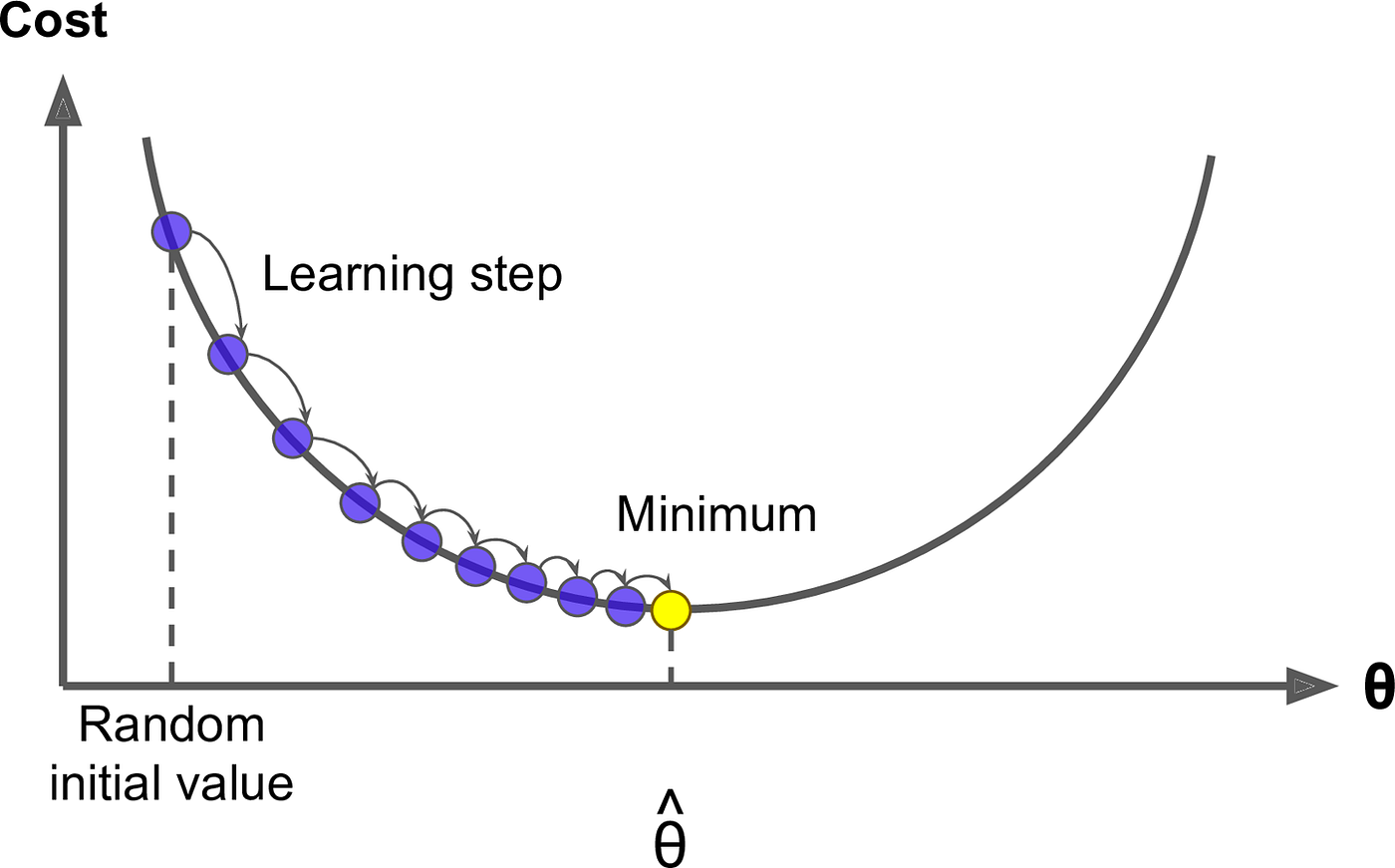

- ——>提出了linear scaling learning rate

- 在mini-batch SGD训练时,增大batch size不会改变梯度的期望,但是会降低它的方差

- ——>batch size 增加时,增大学习率来加快收敛

- eg,batch size为256时选择的学习率是0.1,当我们把batch size变为一个较大的数b时,学习率应该变为

0.1 × b/256

- eg,batch size为256时选择的学习率是0.1,当我们把batch size变为一个较大的数b时,学习率应该变为

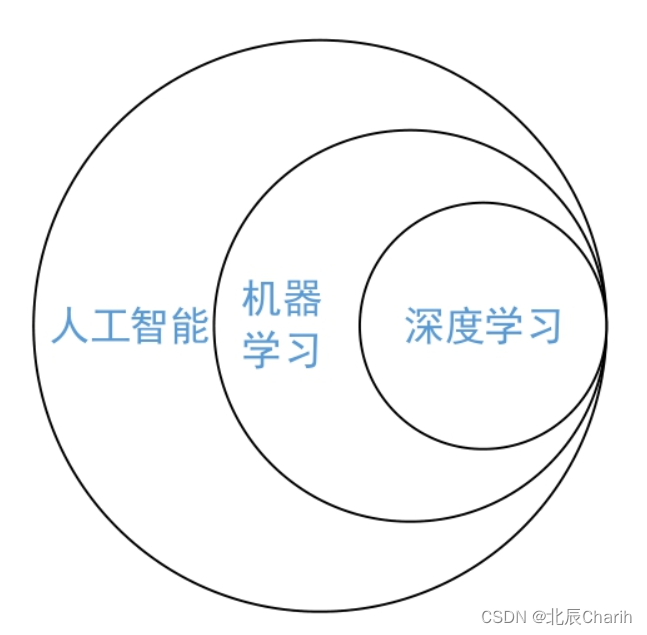

机器学习-1:人工智能、机器学习和深度学习的关系

2023-12-17 13:14:03 37 阅读